المؤلف: بوكسو لي

مقدمة: الرؤية كطبقة ضاغطة لنماذج اللغة الكبيرة

كانت معالجة السياقات الطويلة منذ فترة طويلة نقطة ألم لنماذج اللغة - إذا قمت بتغذية محول بمستند يحتوي على 100 ألف رمز، ستواجه تأخيرًا، أو تضخمًا في الذاكرة، أو تكاليف API محظورة. لم تُصمم النماذج اللغوية الكبيرة التقليدية بكثافة للتعامل بكفاءة مع المدخلات بطول الكتاب. هنا يأتي DeepSeek-OCR 3B، وهو نموذج جديد مفتوح المصدر من نوع Mixture-of-Experts (MoE) يعتمد نهجًا مختلفًا بشكل جذري: فهو يستخدم الاستيعاب البصري كوسيلة لضغط النص [1][2]. بدلاً من ابتلاع آلاف الرموز النصية مباشرةً، يقوم DeepSeek بتحويل الصفحات إلى صور ويتيح لخط أنابيب الرؤية-اللغة إعادة بناء النص. تُعرف هذه التقنية باسم الضغط البصري للسياق، وتسمح للنموذج بدمج كمية أكبر بكثير من المعلومات في عدد أقل بكثير من الرموز [2][3]. يعد DeepSeek-OCR بتقليل الرموز بنسبة تصل إلى 7–20× مع فقدان بسيط في الدقة [4][5]، مما يتيح معالجة وثائق فائقة الطول قابلة للتطوير على أجهزة عادية. والأهم من ذلك، أن النموذج مفتوح المصدر بالكامل (تم نشره على Hugging Face وGitHub) تحت ترخيص متسامح، مما يجعل قدرات OCR المتقدمة متاحة للجميع [6][7]. في هذه المقالة، سنقوم بتشريح بنية وتدريب DeepSeek-OCR، ومقارنته بالنماذج اللغوية الكبيرة الكثيفة التقليدية وخدمات OCR المغلقة المصدر، واستكشاف ما يعنيه إصداره للمطورين ومسار الصناعة المفتوحة المصدر.

تحليل المعمارية: دمج MoE Decoder مع Vision Encoder

تصميم الرؤية باللغة من مرحلتين. تم بناء DeepSeek-OCR كنظام من جزئين: مشفر بصري يسمى DeepEncoder و مفكك شيفرة نصي يسمى DeepSeek-3B-MoE-A570M[8]. يقوم DeepEncoder (≈380M params) بتناول صورة صفحة من وثيقة ويخرج تسلسل مضغوط من "الرموز البصرية". ثم تُغذي هذه الرموز إلى مفكك الشيفرة DeepSeek-3B-MoE، الذي يُنتج المحتوى النصي. هذا التقسيم يختلف عن نموذج اللغة التقليدي الكثيف (الذي يعالج مدخلات النص من البداية إلى النهاية) - هنا يتم الجهد الكبير لفهم تخطيط الصفحة والنص البصري بواسطة المشفر، مما يتيح لمفكك الشيفرة العمل على تسلسل أقصر بكثير[2][3].

الضغط عبر ترميز الرؤية. المشفر هو المكان الذي يكمن فيه الكثير من الابتكار. تم تصميمه للتعامل مع الصفحات ذات الدقة العالية بكفاءة وضغطها بمعدل عدة أضعاف أو أكثر. كيف؟ يجمع DeepEncoder بين عدة مكونات: (1) وحدة رؤية محلية تعتمد على SAM-base (نموذج التقسيم لأي شيء) للإدراك الدقيق، باستخدام انتباه النوافذ لمسح المناطق الصغيرة[9]؛ (2) مخفض تلافيفي 16× يقلل بشكل كبير من عدد رموز الصور (على سبيل المثال 4096 رموز التصحيح إلى 256)[10]؛ و (3) وحدة رؤية عالمية تعتمد على CLIP-large لفهم الصور الشامل مع انتباه كثيف[11]. في الممارسة العملية، يمكن ترميز صورة وثيقة كاملة 1024×1024 إلى 256 رمزًا خفيًا فقط دون فقدان معظم المعلومات النصية[12]. من خلال الحفاظ على عدد رموز الرؤية منخفضًا (64–400 رمز في أوضاع مختلفة)، يتجنب DeepSeek الانفجار الكلفوي التربيعي الذي قد يعاني منه محول الرؤية البسيط على الصور ذات الدقة العالية[13]. هذا يعني أن ذاكرة التفعيل تظل تحت السيطرة حتى للصفحات ذات الكثافة البكسلية العالية[14].

المفاضلة بين Mixture-of-Experts Decoder و Dense LLMs. الديكودر، DeepSeek-3B-MoE، هو محول Mixture-of-Experts ذو 3 مليارات معلمة[8]. على عكس نموذج LLM الكثيف التقليدي الذي تكون فيه جميع الأوزان نشطة لكل رمز، يحتوي نموذج MoE على العديد من الشبكات الفرعية المتخصصة ويفعّل فقط القليل منها لكل إدخال. في حالة DeepSeek، هناك 64 نموذجًا فرعيًا من الخبراء، منها 6 خبراء نشطون لكل رمز عند فك الترميز[15]. هذا ينتج حوالي 570 مليون معلمة "نشطة" لكل رمز - فعليًا يتصرف النموذج كأنه نموذج ذو 570 مليون معلمة في وقت التنفيذ، على الرغم من أن سعته الكلية هي 3 مليارات[16]. من خلال توجيه كل رمز إلى مجموعة من الخبراء، يمكن للنموذج توسيع إجمالي المعلمات دون زيادة متناسبة في تكلفة الحوسبة[17]. في LLMs الكثيفة التقليدية، إذا كنت ترغب في المزيد من السعة، ستزيد عدد المعلمات وتدفع التكلفة الحوسبية الكاملة لكل منها في كل مرة. يتجاوز MoE هذا: يمكن للديكودر DeepSeek استخدام الخبراء المتخصصين (فمثلاً، قد يتخصص بعض الخبراء في الصيغ الرياضية، وآخرون في البيانات الجدولية، وما إلى ذلك)، لكن فقط الخبراء المعنيين يتم تفعيلهم لرمز معين. النتيجة هي ديكودر خفيف الوزن في التشغيل وغني بالمعرفة. في جوهره، يقدم DeepSeek-3B-MoE قوة نموذج أكبر مع الاحتفاظ بسرعة نموذج أصغر[15]. هذه ميزة تمييزية عن نماذج OCR الكثيفة التقليدية و LLMs، التي تفتقر إلى ميزة الحوسبة الشرطية هذه. من الجدير بالذكر أن محولات Switch من Google و GLaM أثبتت لأول مرة فعالية MoE، لكن DeepSeek يجلب تلك القوة إلى نظام مفتوح المصدر للرؤية واللغة.

الشكل: يعتمد الهيكل ذو المرحلتين لـ DeepSeek-OCR على ضغط صورة الوثيقة المدخلة إلى عدد أقل بكثير من الرموز عبر DeepEncoder، ثم يعيد بناء مخرجات غنية بالهيكلية عبر وحدة فك الترميز Mixture-of-Experts. في هذا المثال، يُطلب من النموذج تحويل ملف PDF لمشكلة هندسية صينية إلى تنسيق Markdown: حيث لا يقتصر على استخراج النص فحسب، بل يقوم أيضًا بتحويل الرسم البياني إلى إحداثيات هيكلية وLaTeX، مما يظهر فهماً يتجاوز OCR العادي.[18][19]

أوضاع متعددة الدقة 'Gundam'. إحدى الجوانب الجديدة في تصميم DeepSeek هي أوضاع الدقة القابلة للتكوين، التي أطلق عليها بشكل فكاهي أسماء Tiny, Small, Base, Large, و Gundam. تتيح هذه الأوضاع للمطورين الموازنة بين التفاصيل وعدد الرموز لتلبية احتياجاتهم [20]. على سبيل المثال، يقوم وضع Tiny بمعالجة صورة 512×512 إلى 64 رمز فقط (مفيدة للمسح السريع منخفض التفاصيل)، بينما يتعامل وضع Large مع 1280×1280 مع 400 رمز للحصول على أقصى قدر من التفاصيل [21]. تتجاوز أوضاع Gundam ذلك - حيث تقسم الصفحة إلى عدة عروض محلية بالإضافة إلى عرض عالمي واحد، مما يدمج، على سبيل المثال، n مقاطع محلية بحجم 640×640 (كل منها 100 رمز) مع نظرة شاملة للصفحة (256 أو 400 رمز) [22]. يضمن هذا التقسيم الديناميكي معالجة الصفحات المعقدة أو الكبيرة جدًا من خلال تقسيمها، مع الحفاظ على السياق الشامل للنموذج. إنها تكرار لتقنيات InternVL 2.0 وغيرها، تم تعديلها هنا للحفاظ على دقة عالية في الوثائق الكثيفة [23]. من خلال توفير ميزانيات رمزية وأحجام صور واضحة، تقدم DeepSeek-OCR للمهندسين أساسًا قرصًا: التكيف مع السرعة أو الدقة عن طريق ضبط مقدار التفاصيل المرئية التي يحتفظ بها المشفر [24][25]. لا تقدم خطوط OCR التقليدية هذه الدقة - إنها خطوة هندسية ذكية لجعل النموذج عمليًا تحت قيود حسابية متنوعة.

تكامل التدريب و OCR: كيف يندمج الرؤية والنص

بناء نموذج يقرأ الصور كما يقرأ النصوص تطلب عملية تدريب منظمة بعناية. اختلف تدريب DeepSeek-OCR بشكل كبير عن نظام تدريب LLM العادي، لأنه كان يجب أن يدمج قدرة OCR من البداية إلى النهاية.

نظام تدريب مكون من مرحلتين. اعتمد الباحثون على خطة تدريب من مرحلتين[26][27]. في المرحلة 1، قاموا بتدريب الـDeepEncoder بشكل منفصل كمتنبئ للرمز التالي على بيانات الصور والنصوص المزدوجة. بشكل أساسي، تعلم المشفر إنتاج سلسلة من الرموز التي يتعرف عليها نموذج اللغة كوصف للصورة. استُخدمت في هذه المرحلة مجموعات ضخمة من البيانات الموجهة للتعرف الضوئي على الحروف (التفاصيل أدناه)، مما علم الوحدة البصرية فعليًا ترميز صور النصوص في نفس مساحة رموز النص. بعد أن أصبح المشفر كفؤًا، بدأت المرحلة 2: التدريب المشترك لنظام المشفر والمفكك بأكمله[27]. خلال المرحلة 2، تم تزويد النموذج بمزيج من مدخلات الصور والوثائق (حيث تعلم المفكك إخراج النص الصحيح) ومدخلات النص العادية (للحفاظ على مهاراته اللغوية حادة). هذا النهج المكون من خطوتين - أولاً الرؤية، ثم التعديل متعدد الوسائط - ضمن أن مهارات التعرف الضوئي على الحروف كانت متأصلة بعمق في المشفر قبل أن يُطلب من المفكك توليد اللغة من تعبيراته.

بيانات تدريب متعددة الوسائط ومتنوعة. يعد نطاق بيانات تدريب DeepSeek سببًا رئيسيًا لقوته. وفقًا لبطاقة النموذج، قامت الفريق بتنسيق مزيج من البيانات الحقيقية، والاصطناعية، وحتى النصية البحتة[28]:

- مجموعة بيانات OCR 1.0: 30 مليون صفحة من المستندات الحقيقية (مسح ضوئي، ملفات PDF) تغطي أكثر من 100 لغة. قدّم هذا الكورس الضخم متعدد اللغات للنموذج تعرضًا لعدد لا يحصى من الخطوط والتنسيقات، بدءًا من الفواتير الإنجليزية إلى الصحف العربية والكتب الصينية. هذه التنوع أمر حيوي – حيث تعاني العديد من محركات OCR عند تجاوز عدد قليل من اللغات، لكن تم تدريب DeepSeek منذ البداية ليكون متعدد اللغات.

- بيانات OCR 2.0: مجموعة بيانات اصطناعية تحتوي على مستندات منظمة مع مخططات، معادلات، تراكيب كيميائية، جداول، ورسوم بيانية. كانت هذه على الأرجح صورًا تم إنشاؤها بواسطة الكمبيوتر مقترنة بنصوص حقيقة (مثل صورة معادلة رياضية مُعالجة مع LaTeX كنص). من خلال تضمين ذلك، تعلم النموذج التعامل مع المحتوى الذي يتجاهله OCR التقليدي أو يفشل فيه – مثل قراءة الرسوم البيانية وإخراج البيانات أو المعادلة الأساسية. على سبيل المثال، يمكن لـ DeepSeek تفسير رسم كيميائي وإخراج صيغة SMILES أو تحويل صورة مخطط شريطي إلى جدول CSV/HTML، وهي مهام تتجاوز بكثير “قراءة النص المطبوع”. هذا يمنح DeepSeek ميزة فريدة في فهم المستندات المهيكلة.

- بيانات الرؤية العامة (20%): تم تضمين صور قياسية من مجموعات بيانات مثل LAION (100 مليون عينة). كان الهدف هو ضمان أن النموذج لم يصبح محدودًا – بل يحتفظ بأساسيات الرؤية-اللغة العامة، بحيث يمكنه، على سبيل المثال، توضيح صورة أو التعرف على عناصر بصرية. كنتيجة لذلك، يمكن لـ DeepSeek-OCR وصف الصور أو تحديد العناصر البصرية إذا طُلب منه (مشابه لذكاء بصري أساسي)، وهو ما لا تستطيع أدوات OCR البحتة القيام به.

- بيانات نصية نقية (10%): جزء صغير من التدريب كان على بيانات نصية فقط. كان ذلك للحفاظ على قدرة توليد اللغة السلسة للمحول. لأن في النهاية، بعد “قراءة” الصورة، يجب أن يخرج النموذج نصًا متماسكًا. تضمين بعض النصوص يساعد المحول على عدم التكيف المفرط على مجرد تكرار OCR الدقيق بل يبقى نموذج لغة قادرًا (يمكنه على سبيل المثال إعادة صياغة النص، تلخيص، أو الترجمة إذا طُلب منه).

هذا المزيج من البيانات يضمن أن قدرة التعرف الضوئي على الحروف (OCR) متكاملة بشكل عميق: DeepSeek لا يقوم فقط بمعالجة الصور واستخدام نموذج اللغة الكبير الجاهز، بل تم تدريبه بشكل مشترك لأداء فهم نصوص بصرية من البداية إلى النهاية. يقوم بإعادة بناء النصوص من الصور بدقة مذهلة - 97% مطابقة تامة عند ضغط يصل إلى ~10× على معيار قياسي[30][31]. وبفضل التدريب المتنوع، يفعل ذلك ليس فقط للنصوص المكتوبة البسيطة، بل أيضاً للتصميمات المعقدة والمرئيات المدمجة. في الواقع، جعل التدريب DeepSeek-OCR مزيجاً من نظام التعرف الضوئي على الحروف، ومحلل التصميمات، ونموذج اللغة في آن واحد.

المقياس والحوسبة. كان تدريب DeepSeek مهمة حوسبة جادة، مماثلة لتدريب LLM حديث. استخدم الفريق 20 عقدة تحتوي كل منها على 8×A100 (40GB) وحدات معالجة الرسومات - ما مجموعه 160 وحدة معالجة رسومات A100 [29]. بفضل توازي الأنابيب الفعال، حققوا إنتاجية هائلة تصل إلى 90 مليار رمز يوميًا على بيانات النصوص فقط و70 مليار رمز/يوم على البيانات متعددة الوسائط [29]. على مدار التدريب، من المحتمل أن يصل هذا إلى عدة تريليونات من الرموز المعالجة. يعد هذا المقياس أحد الأسباب التي تجعل النموذج يعمل بشكل جيد رغم أنه يضم فعليًا ~570 مليون معلمة نشطة؛ لقد تعرض لمجموعة متنوعة ضخمة من الأمثلة. تم ضبط تحسين التدريب (محسن AdamW، حجم الدفعة 640، LR ~3e-5 [32]) للتعامل مع هذا التدفق الضخم للبيانات. النتيجة النهائية تم تعبئتها في ملف safetensors بحجم ~6.7 جيجابايت لنموذج 3B MoE – صغير بما يكفي ليعمل على وحدة معالجة رسومات عالية الأداء واحدة [33]. هذا يختلف تمامًا عن نماذج OCR الملكية أو نماذج LLM الضخمة الكثيفة، التي قد تتطلب مجموعات أو لا يمكن استضافتها ذاتيًا على الإطلاق. يوضح خط تدريب DeepSeek الفعال أنه مع الهندسة المعمارية الصحيحة (MoE + ضغط الرؤية)، يمكن تحقيق دقة عالية دون الحاجة إلى نموذج ضخم.

الترخيص مفتوح المصدر واعتماد المطورين

أحد الجوانب الأكثر أهمية في DeepSeek-OCR 3B هو إصداره المفتوح المصدر بالكامل. تم توفير كل من أوزان النموذج والكود تحت ترخيص MIT[34]، وهو واحد من أكثر التراخيص تسامحًا في البرمجيات. للمطورين والمنظمات، هذا له تأثيرات كبيرة:

- حقوق الاستخدام الواسعة: رخصة MIT تعني أنه يمكنك استخدام النموذج تجارياً أو خاصاً مع قيود قليلة – بشكل أساسي يمكنك فعل أي شيء طالما أنك تضمن إشعار الرخصة. هذا يعتبر خروجاً واضحاً عن العديد من النماذج "المفتوحة" التي تحمل شروط غير تجارية أو تتطلب أذونات خاصة. بعبارة أخرى، يمكن للشركات الناشئة والمؤسسات دمج DeepSeek-OCR في المنتجات (حتى المنتجات المغلقة المصدر) دون عقبات قانونية. إنها حقاً ابتكار مفتوح.

- الشفافية والثقة: وجود الأوزان على Hugging Face والشفرة على GitHub يعني لا شيء يعتبر صندوقاً أسود. يمكن للمطورين فحص كيفية عمل النموذج، التحقق من البنية، بل وحتى مراجعته أو تحسينه لاحتياجاتهم. هذه الشفافية تبني الثقة – على سبيل المثال، إذا كنت تعالج وثائق حساسة، قد تفضل نموذجاً مفتوحاً يمكنك تشغيله بالكامل في مقر الشركة بدلاً من إرسال البيانات إلى API طرف ثالث.

- سهولة التكامل: الإصدار يتضمن بطاقة نموذج مفصلة واستخدامات أمثلة. ببضع سطور من Python (باستخدام Hugging Face Transformers مع trust_remote_code=True للسماح بشفرة النموذج المخصصة)، يمكنك تحميل النموذج وتشغيل الاستدلال [35][36]. فريق DeepSeek قدم أيضاً مواصفات بيئة مجربة (Python 3.12، Torch 2.6، Transformers 4.46، FlashAttention 2.7، إلخ) بحيث يمكن للمهندسين تكرار الإعداد بشكل موثوق [37]. هذا يخفض حاجز التبني – لا تحتاج لتكون باحثاً في الذكاء الاصطناعي لتجربته. إذا كان لديك ملف صورة لوثيقة ومعالج رسومي جيد، يمكنك الحصول على النتائج في دقائق.

- المجتمع والدعم: منذ الإطلاق، حظي DeepSeek-OCR باهتمام سريع. حصل مستودع GitHub على آلاف النجوم (أكثر من 5 آلاف نجمة) خلال أيام من الإصدار [38]، وحصل النموذج على عشرات الآلاف من التنزيلات على Hugging Face [39]، مما يشير إلى اهتمام كبير من المجتمع. ظهرت عدة تطبيقات تجريبية (Spaces) على Hugging Face حيث يمكنك تجربة النموذج في متصفحك [40]. هذه الزخم المجتمعي يعني أن المطورين يمكنهم على الأرجح العثور على مساعدة أو دروس أو إضافات مقدمة من قبل الآخرين. كما يعني أن النموذج سيتم اختباره في معارك عبر حالات استخدام متنوعة، مما يساعد في القضاء على الأخطاء وإلهام التحسينات.

- الحرية في التخصيص: ربما الأهم من ذلك، الأوزان المفتوحة تعني أن المطورين يمكنهم تحسين DeepSeek-OCR أو تعديله. إذا كان لدى شركتك مهمة OCR متخصصة (مثل قراءة نوع معين من المخططات الهندسية أو الخطوط المزخرفة جداً)، يمكنك تدريب النموذج أو تكييفه لهذا المجال. مع APIs OCR المغلقة، ليس لديك مثل هذا الخيار – تحصل على ما يقدمه المزود. DeepSeek يمكن الفرق البحث والتطوير من الابتكار على أساسه. قد نرى قريباً اشتقاقات متخصصة – على سبيل المثال، قد يقوم شخص ما بضبط نسخة من DeepSeek للمستندات اليدوية التاريخية، أو دمجه في خط أنابيب أكبر (روبوتات محادثة يمكنها الإجابة عن أسئلة حول محتوى PDF، إلخ).

باختصار، يزيل إصدار MIT المفتوح المصدر من DeepSeek-OCR حاجز التكلفة وحاجز الوصول لأحدث تقنيات التعرف البصري على الحروف (OCR). يمكن لأي مطور يمتلك وحدة معالجة الرسوميات (GPU) نشر نموذج رؤية-لغة متقدم في بيئته الخاصة، مجانًا. هذه الديمقراطية تشبه ما رأيناه عندما أصبحت نماذج الصور مثل Tesseract (التعرف البصري على الحروف مفتوح المصدر) أو Stable Diffusion (توليد الصور مفتوح المصدر) متاحة - باستثناء أن قدرات DeepSeek أكثر تقدمًا بكثير. الآثار المترتبة على ذلك هي أنه حتى الشركات الناشئة الصغيرة أو الباحثين يمكنهم دمج تقنيات التعرف البصري على الحروف وفهم المستندات من الطراز العالمي في مشاريعهم، مما يدفع المجال إلى الأمام من خلال المساهمات الجماعية.

مقارنة DeepSeek-OCR بواجهات برمجة التطبيقات المغلقة للتعرف البصري على الحروف من Google وAmazon

كيف يتفوق هذا النموذج المفتوح مقارنة بالمنافسين مثل Google Cloud Vision OCR و Amazon Textract؟ كانت هذه الخدمات المستندة إلى السحابة حلولاً موثوقة لمعالجة الوثائق في المؤسسات، معروفة بدقتها وقابليتها للتوسع. ومع ذلك، فإن وصول DeepSeek-OCR يبرز بعض الفروقات الواضحة في القدرة، والوصول، والمرونة، وسرعة الابتكار:

- الدقة والقدرة: في مهام استخراج النصوص، محركات OCR الخاصة بجوجل وأمازون دقيقة جدًا، حيث تم تحسينها استنادًا إلى بيانات كبيرة. يدخل DeepSeek-OCR هذا المجال بنتائج تنافسية (حتى أنها تعتبر من الطراز الأول) في المعايير – مثل مطابقة نص دقيق بنسبة 97-98% في معايير OCR القياسية عند مستويات ضغط معقولة[30]. يتفوق حتى على نماذج OCR الأكاديمية الحديثة (GOT-OCR 2.0, Mineru 2.0) بينما يستخدم عددًا أقل بكثير من الرموز[19]. من الناحية العملية، يمكن لـ DeepSeek أن يتنافس مع واجهات برمجة التطبيقات السحابية الكبيرة لاستخراج النصوص المطبوعة. لكن قدرات DeepSeek تتجاوز OCR العادي. بفضل تدريبه متعدد الوسائط، يفهم التخطيطات ويمكنه تفسير المحتوى المضمن. على سبيل المثال، يمكنه قراءة ملف PDF علمي وليس فقط نسخ الفقرات، بل أيضًا تفسير رسم بياني في ملف PDF – وإخراج بيانات الرسم البياني أو تلخيص محتواه. يمكنه تحويل صورة جدول إلى هيكل جدول HTML فعلي أو جدول Markdown. يمكنه حتى وصف العناصر غير النصية في المستند (الأشكال، الصور) إذا طُلب منه ذلك. واجهات برمجة التطبيقات المغلقة مثل Google Vision أو Textract متخصصة بشكل عام في مهام معينة (اكتشاف النص، استخراج بيانات النماذج، إلخ) – قد تستخرج النص وربما تحدد هيكل التخطيط الأساسي، لكنها لن تكتب ما يعنيه مخطط كيميائي أو تحول مخططًا إلى كود. يعمل DeepSeek بشكل يشبه القارئ البشري: يمكنه إنتاج مخرجات بتنسيقات مرنة والتعامل مع المحتوى المختلط. هذا يجعله ليس مجرد أداة OCR، بل نموذج فهم المستندات العام. ومع ذلك، فإن الخدمات المغلقة لديها ميزاتها المتقدمة (مثل Textract يمكن أن يعطيك حقول نماذج منظمة مباشرة، و Google’s Document AI يمكنه تصنيف أنواع المستندات) – لكن هذه محددة بدقة. يقدم DeepSeek قدرة أكثر انفتاحًا حيث يكون المخرجات ما تطلبه (“تحويل هذا إلى Markdown”، “استخراج جميع الأسماء وعناوين البريد الإلكتروني”، “تلخيص هذا التقرير”، إلخ)، مستفيدًا من طبيعته LLM.

- الوصول والدمج: فرق كبير هو كيفية استخدامهم. جوجل وأمازون OCR هما خدمات سحابية – ترسل الصور (أو ملفات PDF) إلى واجهة برمجة التطبيقات الخاصة بهم وتحصل على النتائج. هذا له إيجابيات وسلبيات. الإيجابية هي الراحة: لا حاجة للخبرة في التعلم الآلي، ويتوسع تلقائيًا؛ التكامل هو مجرد استدعاء بسيط لواجهة برمجة تطبيقات REST[41]. السلبية هي أنه يجب عليك إرسال مستنداتك الحساسة المحتملة إلى خادم خارجي، وتدفع لكل استخدام[42][43]. كون DeepSeek-OCR مفتوح المصدر يقلب هذا النموذج. تقوم بتنزيل النموذج وتشغيله على أجهزتك الخاصة. قد يتطلب التكامل المزيد من العمل (إعداد بيئة GPU، استدعاء النموذج في الكود)، لكن لا توجد تبعية خارجية – وهو أمر حاسم للخصوصية والامتثال. غالبًا ما تتردد شركات الرعاية الصحية أو القانونية في تحميل الملفات السرية إلى السحب السحابية التابعة لجهات خارجية؛ مع DeepSeek، يمكنهم الاحتفاظ بالبيانات بالكامل داخليًا. من حيث التكلفة، إذا كان لديك حجم ثابت من المستندات، فإن تشغيل النموذج الخاص بك يمكن أن يكون أكثر فعالية من حيث التكلفة على المدى الطويل[44][43]. عادةً ما تفرض واجهات برمجة التطبيقات السحابية الخاصة بـ OCR رسومًا على كل 1,000 صفحة تتم معالجتها. تتراكم هذه التكاليف، في حين أن النموذج المفتوح يسمح لك بالاستفادة من استثمار واحد في GPU أو مثيل سحابي ثم معالجة ملايين الصفحات بتكلفة هامشية. باختصار، الوصول إلى DeepSeek غير مقيد – لا توجد حدود للمعدل، ولا رسوم، وتحكم كامل في البيئة. المقايضة هي أنك تدير البنية التحتية، ولكن بالنسبة للكثيرين، هذا تبادل مرحب به للاستقلالية.

- المرونة والتخصيص: حلول OCR المغلقة المصدر هي عبارة عن عروض ثابتة بشكل أساسي. إذا ارتكبت خطأً أو لم تكن مخصصة لمجالك (على سبيل المثال، قراءة خط اليد أو المصطلحات المتخصصة)، فليس لديك سوى القليل من الخيارات باستثناء المعالجة اللاحقة أو الانتظار والأمل في أن يقوم المزود بتحسين النموذج. مع نموذج مفتوح مثل DeepSeek، لديك مرونة كاملة. يمكنك ضبط النموذج على بيانات المجال الخاص بك (على سبيل المثال، ضبطه على عينات مكتوبة بخط اليد أو مستندات لغة متخصصة) لتحسين أدائه خصيصًا لاحتياجاتك. يمكنك أيضًا تخصيص تنسيق الإخراج عبر التوجيه – على سبيل المثال، تطلب من DeepSeek إنتاج JSON مع استخراج حقول معينة، أو الحفاظ على تنسيق Markdown. يعني الحمض النووي لـ LLM للنموذج أنه يمكنه اتباع التعليمات حول كيفية عرض نتائج OCR، وهو أمر لا تفعله واجهات برمجة التطبيقات من Google/Amazon (لديها مخططات إخراج محددة مسبقًا). علاوة على ذلك، يمكنك دمج DeepSeek في تدفقات العمل المركبة: ربما تقوم بتشغيل DeepSeek للحصول على استخراج مسودة، ثم تقوم بتغذية ذلك إلى نموذج آخر للتحقق أو إلى نظام بشري في الحلقة. مع واجهات برمجة التطبيقات المغلقة، غالبًا ما تكون مقيدًا بخط أنابيبها. في الأساس، يمنحك DeepSeek بكونه مفتوح الوزن الحرية للابتكار على أساسه، في حين أن الحلول المغلقة هي “ما تراه هو ما تحصل عليه”. هذه المرونة هي محفز للابتكار الأسرع على جانب التطبيق – قد نرى حالات استخدام جديدة (مثل روبوتات دردشة المستندات التفاعلية، أو أدوات تحرير المستندات البصرية) مبنية حول DeepSeek التي لن تكون ممكنة أو مجدية من حيث التكلفة باستخدام واجهات برمجة التطبيقات المغلقة.

- وتيرة الابتكار: تميل النماذج المفتوحة المصدر إلى التطور بسرعة عبر مساهمات المجتمع وتكامل الأبحاث، بينما تتطور الخدمات المغلقة خلف الأبواب المغلقة ووفقًا لجدولها الزمني الخاص. مع ظهور DeepSeek-OCR في الميدان، يمكن للباحثين فحص بنيته والبناء عليه. إذا اكتشف أحدهم طريقة لجعله أسرع مرتين أو أكثر دقة، يمكنهم مشاركة هذه التحسينات علنًا. على سبيل المثال، تخيل جهدًا مجتمعيًا لتقليم أو تقليل حجم النموذج للنشر على الحافة – قد يحدث ذلك في غضون أسابيع في المصدر المفتوح. على النقيض من ذلك، قد يقوم مقدمو الخدمات المغلقة بتحديث تقنيات OCR الخاصة بهم كل بضعة أشهر أو عام، وقد لا يعرف المستخدمون حتى ما الذي تغير تحت السطح. لقد ثبت أن وتيرة الابتكار في النماذج المفتوحة كانت حارقة في مساحة LLM (لقد شاهدنا نماذج LLM المفتوحة تلحق بأداء المختبرات الكبرى في غضون أشهر)[45][46]. يمكننا توقع تأثير مشابه هنا: إطلاق DeepSeek سيحفز المنافسة المرجعية ضد Google/AWS، وإذا كان هناك أي نقص في أي مجال، ستركز الكثير من الأعين على كيفية تحسينه. أيضًا، وجود بديل مفتوح قابل للتطبيق من المحتمل أن يضغط على مقدمي OCR المغلقين بشأن التسعير والميزات. إذا بدأت الشركات في التحول إلى النماذج المفتوحة لتوفير التكاليف أو تجنب الاحتكار، فقد ترد الخدمات السحابية OCR بخفض الأسعار أو تقديم ميزات ذات قيمة مضافة جديدة (على سبيل المثال، تكامل أكثر سلاسة مع الأدوات السحابية الأخرى، أو ضمانات خصوصية البيانات). إنها منافسة صحية تعود بالنفع في النهاية على المستخدمين النهائيين. من اللافت للنظر أن بعض قادة التكنولوجيا الكبرى قد أقروا بالزخم الذي تكتسبه الذكاء الاصطناعي المفتوح – على سبيل المثال، صرح الرئيس التنفيذي لشركة OpenAI سام ألتمان مؤخرًا، “أنا شخصيًا أعتقد أننا كنا على الجانب الخطأ من التاريخ هنا [مع النماذج المغلقة] ونحتاج إلى إيجاد استراتيجية مفتوحة المصدر مختلفة.”[47]. جاءت هذه التصريحات مع إظهار النماذج المفتوحة، مثل تلك من DeepSeek، تقدمًا سريعًا. في ساحة OCR، قد يُجبر DeepSeek-OCR بالمثل على إعادة التفكير في مقدار القيمة التي تقدمها العروض المملوكة مقابل المشاريع المدفوعة من المجتمع.

التأثير على الصناعة: نماذج الرؤية-اللغة المفتوحة والعمالقة التقنية

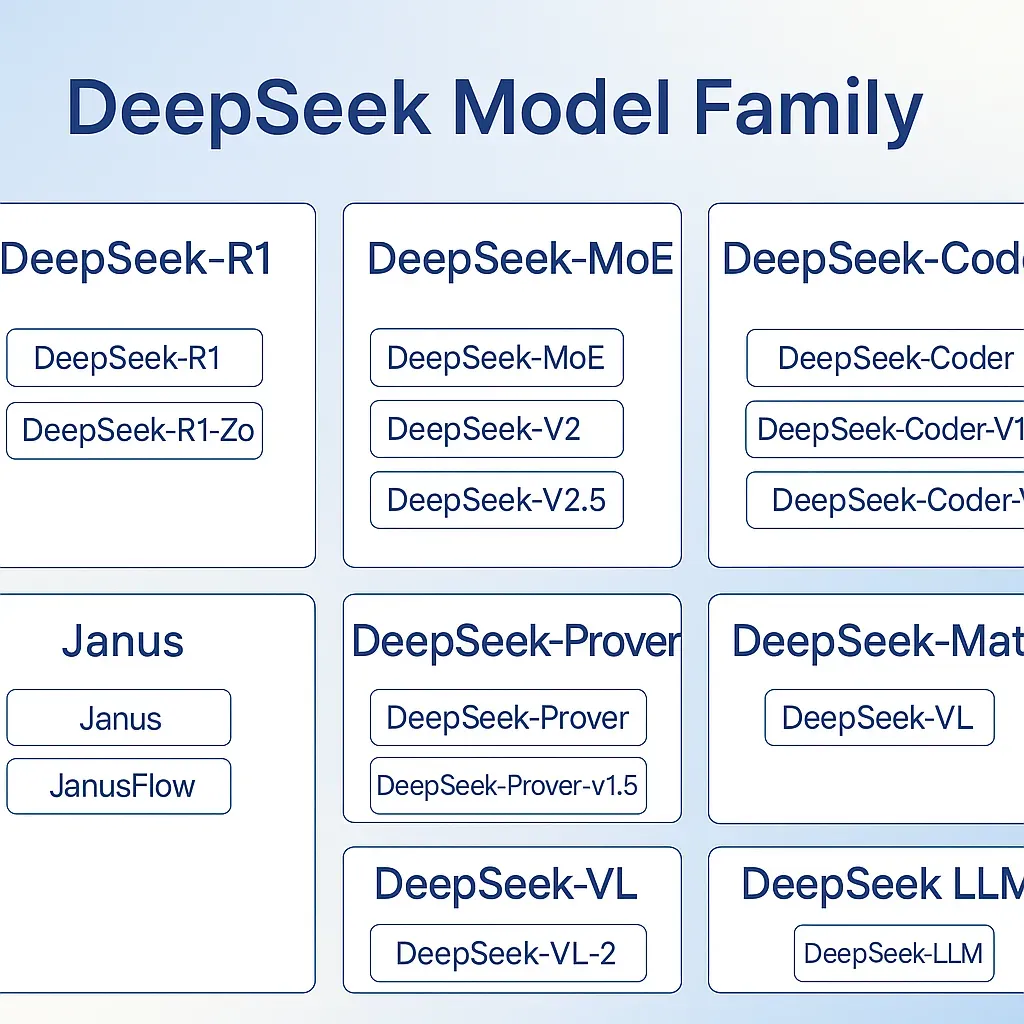

يُعَد ظهور DeepSeek-OCR جزءًا من موجة أوسع في الذكاء الاصطناعي: صعود نماذج الرؤية-اللغة المفتوحة الوزن (VLMs). في الماضي، كانت النماذج متعددة الوسائط المتقدمة (مثل تلك التي تقوم بمهام OCR، أو وصف الصور، أو VQA) تُعتبر حصريًا ملكية خاصة أو إثباتًا لمفاهيم أكاديمية. الآن، نشهد تحولًا في النهج. خلال السنة أو السنتين الماضيتين، بدأت المنظمات والجماعات البحثية - العديد منها خارج نطاق شركات التكنولوجيا الكبرى التقليدية - في فتح المصادر لنماذج VLMs المتقدمة ذات القدرات المذهلة. كان DeepSeek في طليعة هذه الحركة. إصداراتهم السابقة، مثل سلسلة DeepSeek-VL2 (نماذج MoE بحجم 3B، 16B، 27B في أواخر 2024)، كانت أنظمة رائدة في مجال الرؤية-اللغة المفتوحة[48][17]. قدمت تلك النماذج ابتكارات مثل تجزئة الصور الديناميكية والانتباه الكامن لمعالجة البيانات المرئية المعقدة بكفاءة[49][17]. يبني DeepSeek-OCR الجديد على هذا الأساس، ويركز على فهم الوثائق وضغط السياق الطويل. الأهم من ذلك، أن جميع هذه النماذج تشترك في شيء مشترك: الأوزان العامة ورسالة تهدف إلى ديمقراطية الذكاء الاصطناعي متعدد الوسائط.

هذا الاتجاه يضع ضغطًا تنافسيًا على عمالقة المصادر المغلقة. تذكر أنه تاريخيًا، إذا كنت بحاجة إلى نموذج يمكنه "الرؤية" و"القراءة"، كنت مضطرًا لاستخدام خدمات مثل Google Vision أو دفع أموال ضخمة لبرمجيات مملوكة (أو استخدام أدوات مفتوحة قديمة مثل Tesseract، والتي هي أقل قدرة بكثير). الآن، مع النماذج المفتوحة مثل DeepSeek-OCR (وغيرها، مثل Qwen-VL من علي بابا أو نماذج الصورة-النص المفتوحة من ميتا)، لدى المطورين خيارات لا تربطهم بنظام مزود كبير. يمكن لهذا الانفتاح تسريع الابتكار بطريقة لم تتمكن النماذج المغلقة من تحقيقها. على سبيل المثال، يمكن لمختبر أكاديمي أخذ أوزان DeepSeek وتخصيصها للإجابة على الأسئلة الغنية بصريًا، وإطلاق نموذج جديد يعتبر الأفضل في مجاله دون الحاجة لمشاركة جوجل أو OpenAI. التقدم الجماعي مذهل: كما أشارت إحدى التحليلات، على الرغم من أن النماذج المغلقة أخذت زمام المبادرة في البداية، إلا أن الإصدارات المفتوحة كانت تغلق الفجوة بسرعة في الأداء وتدفع باتجاهات بحث جديدة[45][46]. في مجال الرؤية-اللغة، نشهد نماذج مفتوحة تتعامل مع مهام مثل تحويل الصور إلى تنسيق (مثل تحويل الرسوم البيانية إلى كود) أو التفكير المتعدد الوسائط التي كانت سابقًا محصورة في الأبحاث الداخلية لدى شركات التقنية.

وجود VLMs مفتوحة الوزن يعزز أيضًا ثقافة بحثية أكثر شفافية. مع توفر التقرير الفني والنموذج الخاص بـ DeepSeek-OCR، يمكن للباحثين التحقق من الادعاءات والبناء عليها - على سبيل المثال، اختبار ادعاء الضغط بنسبة 97% على مستنداتهم الخاصة[50]. يغير هذا النموذج من "فقط عدد قليل من الشركات يمكنها القيام بذلك" إلى "أي شخص في المجتمع يمكنه تكرار ذلك وتوسيعه." لقد رأينا كيف حدث ذلك في عالم LLM النصي البحت: أثار LLaMA من Meta (جزئيًا مفتوح) موجة من الابتكار في عام 2023، ونماذج مثل R1 الخاصة بـ DeepSeek في أوائل 2025 تم الإشادة بها كـ "إعادة ضبط كبرى" لكونها مفتوحة بالكامل وتنافسية[51]. تم الإشارة إلى ذلك النموذج كأول نموذج على مستوى الحدود بدون قيود على الاستخدام، وفعلاً حث المدافعين عن النماذج المغلقة على إعادة التفكير[51][47]. الآن، يجلب DeepSeek-OCR نفس الروح إلى الذكاء الاصطناعي الذي يجمع بين النصوص والصور.

حتى الرواد في الصناعة يتفاعلون مع هذه الأفكار. علق الباحث المعروف في مجال الذكاء الاصطناعي أندريه كارباتي على نهج DeepSeek-OCR، مشيرًا إلى أن استخدام الصور كمدخلات للنماذج اللغوية الكبيرة قد يكون أكثر كفاءة وتعبيرًا من الرموز النصية في بعض الحالات[52][53]. وأشار إلى كيف يمكن لجزء من الصورة أن يشفر عدة حروف (كثافة معلومات أعلى) وكيف أن الصور تتضمن تنسيقًا بطبيعتها (الخطوط، التخطيطات) الذي يفقده النص[53][54]. في رأيه، تشير ورقة DeepSeek-OCR إلى مستقبل حيث يصبح إدخال الصور وسيلة شائعة لتغذية السياقات الطويلة في النماذج، مما قد يعيد تعريف النماذج اللغوية كنماذج معلومات عامة[55][56]. مثل هذه الرؤى من قادة الفكر تظهر كيف يمكن للأبحاث المفتوحة مثل هذه أن تشعل اتجاهات جديدة. إذا أصبح استخدام الصور كالسياق اتجاهاً، فقد ندين بذلك للتجارب مثل DeepSeek التي تثبت ذلك. مازح كارباتي بأنه كان عليه أن “يسيطر على نفسه من تطوير روبوت محادثة يدعم فقط إدخال الصور” بعد رؤية هذه النتائج[57] - إشارة فكاهية إلى مدى وعد الفكرة، حتى لو بقيت التحديات العملية (لأن النماذج لا تزال تخرج نصوصاً). النقطة الرئيسية هي أن النماذج المفتوحة تغذي النقاش والاستكشاف المفتوحين. الأفكار لا تبقى أسرارًا مملوكة؛ بل تنتشر في المجال بسرعة.

من منظور تنافسي، فإن اتجاه النموذج المفتوح الوزن يضعف التفوق الذي كانت تتمتع به أنظمة الرؤية-اللغة المغلقة المصدر سابقًا. على وجه الخصوص، تقوم مختبرات التكنولوجيا الصينية بإطلاق العديد من النماذج المفتوحة والمجموعات البيانية اللافتة للنظر، مما يجعلها تتماشى مع (أو حتى تتجاوز) الجهود الغربية في بعض المجالات[58]. ديبسيك نفسها هي شركة ناشئة صينية (مقرها هانغتشو) تحقق تأثيرًا عالميًا من خلال المصادر المفتوحة للاختراقات[1][59]. هذا التعاون المفتوح بين الشرق والغرب يسرع التقدم للجميع. الشركات الكبيرة في مجال التكنولوجيا تلاحظ ذلك - بعضها بدأ في الاستجابة عن طريق تحديد نهجها (على سبيل المثال، قامت ميتا بفتح بعض نماذج الرؤية مثل Segment Anything، أو بدأت أوبن إيه آي في فتح بعض النماذج الأصغر بشكل مؤقت)[47][60].

في الصورة الكبيرة، يعتبر إصدار DeepSeek-OCR 3B تحت رخصة MIT خطوة هامة في ثورة الذكاء الاصطناعي مفتوح المصدر. إنه يبرز E-E-A-T (الخبرة، التخصص، الموثوقية، الأمانة) من منظور المجتمع: حيث يشارك مطورو الذكاء الاصطناعي ذوو الخبرة خبراتهم و"تجاربهم" مع المجتمع، مما يعزز الثقة والمعرفة الجماعية. بالنسبة للمطورين والشركات، يعني ذلك أن تقنية التعرف الضوئي على الحروف المتقدمة لم تعد مقتصرة على عمالقة التكنولوجيا – بل أصبحت موردًا عامًا يمكن لأي شخص دمجه في تطبيقاته. وبالنسبة لمجال الذكاء الاصطناعي، يعتبر ذلك تذكيرًا بأن الانفتاح يمكن أن يقود الابتكار السريع. قدرة النموذج على ضغط السياقات ومعالجة مهام الرؤية والنص قد تلهم جيلًا جديدًا من التطبيقات الهجينة والبحث في هياكل MoE VLM الأكثر كفاءة. العمالقة المغلقة المصدر لديهم رسالة واضحة الآن: المجتمع المفتوح يتحرك بسرعة، وللبقاء ذات صلة (وأخلاقية وواسعة الانتشار)، قد لا يكون تبني الانفتاح اختياريًا. كما ذكرت إحدى التقارير، قدمت DeepSeek دفعة كبيرة لنماذج اللغة الكبيرة كمشروع علمي عالمي مفتوح، على عكس "مشروع مانهاتن" المغلق – لدرجة أن حتى اللاعبين المغلقين سابقًا يعيدون التفكير في موقفهم[51][47].

الخاتمة

يمثل DeepSeek 3B MoE OCR اندماجًا لأحدث الأبحاث: حيث يجمع بين محول خليط الخبراء مع مشفر رؤية مصمم بذكاء لتجاوز حدود طول السياق التي تعاني منها نماذج اللغة التقليدية. من الناحية المعمارية، يبتعد عن النماذج الكثيفة من خلال تنشيط خبراء متخصصين لكل رمز ومعاملة الصور كمدخلات أساسية لمهام النصوص. من الناحية العملية، يحقق ضغطًا شبه خالي من الفقدان لأجهزة التعرف على النصوص عند تقليل يصل إلى 10×، ويتعامل مع تعقيدات المستندات الواقعية، ويفعل ذلك في لغات وتنسيقات متعددة. والأهم من ذلك هو ما يمثله - نموذج مفتوح المصدر مرخص من MIT في وقت كان يُعتقد أن مثل هذه القدرات محمية من قبل عمالقة التكنولوجيا. من خلال إصدار DeepSeek-OCR بشكل مفتوح، قام منشئوه بتزويد المطورين في جميع أنحاء العالم بأداة قوية وتحدي مقدمي الخدمات المغلقة.

للْمُطَوِّرِينَ، الرِّسَالَة وَاضِحَة: تَقْنِيَة OCR وَالذَّكَاء الاصْطِنَاعِيُّ لِلْمُسْتَنَدَات أَصْبَحَت أَكْثَرُ وُصُولًا. يُمْكِنُكَ ضَمُّ نَمُوذَج رُؤْيَة-لُغَة عَلَى مُسْتَوَى الخُبَرَاء إِلَى بُنْيَتِكَ دُونَ دَفْع لِكُلِّ مكالمة API أَوْ القَلَق مِنْ حُدُود الخِدْمَة. يُمْكِنُكَ تَحْسِينُهُ، تَشْرِيحُهُ، أَوْ اسْتِخْدَامُهُ كَمَا هُوَ لِتَحْلِيل مُسْتَنَدَات PDF وَالصُّوَر وَأَكْثَر إِلَى نَصّ أَوْ بَيَانَات مُفِيدَة. المُسْتَخْدِمُون المُبَكِّرُون قَد أَظْهَرُوا تَحْوِيل أَوْرَاق بَحْثِيَّة كَامِلَة إِلَى Markdown، وَاسْتِخْلَاص الجَدَاوِل وَالرِّيَاضِيَّات بِدِقَّة، وَحَتَّى مُعَالَجَة مَهَامّ مِثْل إِجَابَة الأسْئِلَة البَصَرِيَّة بِاسْتِخْدَام هَذَا النَّمُوذَج. هَذِهِ المَرُونَة غَيْر مَسْبُوقَة فِي نِظَام OCR وَاحِد.

بالنسبة للصناعة، يُظهر DeepSeek-OCR كيف تستمر الجهود مفتوحة المصدر في تقليص الفجوة مع الحلول المغلقة (وأحيانًا تتفوق عليها) في الجودة والابتكار. يُضيف إلى الأدلة المتزايدة أن النماذج المفتوحة يمكن أن تحدد معايير جديدة - من Stable Diffusion في التصوير إلى مشتقات LLaMA في معالجة اللغة الطبيعية، والآن إلى DeepSeek في الرؤية واللغة لـ OCR. من المحتمل أن نشهد فترة من التجارب السريعة المبنية على DeepSeek-OCR: توقع إصدارات محسنة، ونماذج متابعة أكبر (ربما DeepSeek-OCR 16B MoE؟)، ودمج في خطوط أنابيب OCR مفتوحة المصدر وأدوات واجهة المستخدم. المستفيدون النهائيون سيكونون جميعنا، الذين سيستمتعون بتطوير أسرع لميزات الذكاء الاصطناعي والمزيد من الخيارات في الأدوات التي نستخدمها.

باختصار، يعتبر DeepSeek 3B MoE أكثر من مجرد نموذج OCR - إنه نذير للمرحلة التالية من الذكاء الاصطناعي حيث تدفع النماذج المتعددة الوسائط ذات الأوزان المفتوحة الابتكار في المجالات التي كانت تاريخياً تحت سيطرة الأنظمة المملوكة. إنه يوازن بين الفرص في البحث وتطوير التطبيقات في OCR وفهم المستندات الطويلة. من خلال تبني نموذج مفتوح مع مثل هذه القدرات العالية، يرسل المجتمع إشارة قوية: قد يكون مستقبل التقدم في الذكاء الاصطناعي ملكًا للجميع، وليس فقط للكبار القلة. وكما يظهر DeepSeek-OCR، فإن أفضل طريقة للتعامل مع كمية كبيرة من النصوص هي النظر إليها - والآن يمكن لأي شخص القيام بذلك، مع النموذج المناسب في يده.

المصادر: تم استخدام مراجع ووثائق ذات سلطة عالية لتجميع هذا التحليل، بما في ذلك التقرير الفني الرسمي لـ DeepSeek-OCR وبطاقة النموذج[8][50]، وتغطية إخبارية من South China Morning Post وMarkTechPost[1][24]، ورؤى من خبراء الذكاء الاصطناعي مثل Andrej Karpathy[53][56]، ومعلومات مقارنة حول خدمات جوجل/أمازون OCR[41][44]. تدعم هذه المصادر التفاصيل المعمارية، ادعاءات الأداء، وسياق الصناعة المذكور أعلاه، مما يضمن حسابًا دقيقًا وجديرًا بالثقة لأهمية DeepSeek-OCR.

[1] [6] [59] ديبسيك تكشف عن نموذج ذكاء اصطناعي متعدد الوسائط يستخدم الإدراك البصري لضغط المدخلات النصية | ساوث تشاينا مورنينغ بوست

[2] [3] [9] [10] [11] [12] [15] [18] [23] [27] [28] [32] DeepSeek OCR وصل الآن. كيف تستخدم DeepSeek OCR مجانًا؟ | بقلـم ميهول جوبتا | علم البيانات في جيبك | أكتوبر، 2025 | ميديوم

https://medium.com/data-science-in-your-pocket/deepseek-ocr-is-here-37096b562bb0

[4] [5] DeepSeek-OCR: الذكاء الاصطناعي متعدد الوسائط يقلل من معالجة النصوص بنسبة 7-20x - الأخبار والإحصاءات - IndexBox

https://www.indexbox.io/blog/deepseek-releases-multimodal-model-for-text-compression/

[7] [38] GitHub - deepseek-ai/DeepSeek-OCR: ضغط بصري للسياقات

https://github.com/deepseek-ai/DeepSeek-OCR/tree/main

[8] [13] [14] [16] [19] [20] [21] [22] [24] [25] [26] [29] [30] [31] [33] [37] [50] أطلقت ديب سيك للتو نموذجًا للتعرف الضوئي على الحروف بسعة 3B: نموذج VLM بسعة 3B مصمم لأداء عالٍ في التعرف الضوئي على الحروف وتحويل الوثائق المهيكلة - مارك تك بوست

DeepSeek-AI مفتوح المصدر DeepSeek-VL2 سلسلة: ثلاثة نماذج مع 3B، 16B، و 27B من المعاملات مع بنية مزيج الخبراء (MoE) التي تعيد تعريف الرؤية واللغة في الذكاء الاصطناعي : r/machinelearningnews

[34] [35] [36] [39] [40] deepseek-ai/DeepSeek-OCR · Hugging Face

https://huggingface.co/deepseek-ai/DeepSeek-OCR

[41] [42] [43] [44] مقارنة بين AWS وGoogle Vision (مقارنة ميزات التعرف الضوئي على الحروف) | IronOCR

[45] [46] [47] [51] [58] [60] مفتوح مقابل مغلق: المعركة من أجل مستقبل نماذج اللغة | الاتحاد الأمريكي للحريات المدنية

https://www.aclu.org/news/privacy-technology/open-source-llms

[52] [53] [54] [55] [56] [57] يعلّق Andrej Karpathy على ورقة DeepSeek-OCR: قد يصبح إدخال الصور اتجاهاً جديداً لنماذج اللغة الكبيرة