Gemini 3 vs ChatGPT‑4 vs Claude 2: Ein umfassender Vergleich

Autor: Boxu Li

Googles Gemini 3 ist das neueste multimodale KI-Modell von Google DeepMind und stellt einen bedeutenden Fortschritt in den technischen Fähigkeiten dar. Im Folgenden untersuchen wir die Architektur, die Trainingsdaten und die Benchmark-Leistung von Gemini 3 und vergleichen es ausführlich mit OpenAIs GPT‑4 (einschließlich des neueren GPT‑4 Turbo) und Anthropics Claude 2/2.1 in Bezug auf Argumentation, Programmierung, Multimodalität, Effizienz, Kontextlänge, Entwicklerwerkzeuge und Sicherheitsausrichtung. Wir fügen auch eine Vergleichstabelle hinzu, die wichtige Kennzahlen und Funktionen zusammenfasst.

Gemini 3 Technische Fähigkeiten

Architektur: Die Gemini-Modelle von Google verwenden eine sparsame Mixture-of-Experts (MoE) Transformer-Architektur[1]. Das bedeutet, dass das Modell Tokens dynamisch an verschiedene Experten-Unternetze weiterleitet und nur einen Teil der Parameter für jedes Eingangstoken aktiviert. Das MoE-Design ermöglicht eine enorme Gesamtkapazität ohne eine proportionale Erhöhung der Berechnung pro Token[2]. In der Praxis kann Gemini extrem groß sein (Milliarden von Parametern, verteilt über Experten) und dennoch effizient betrieben werden, was zu seiner hohen Leistung beiträgt. Im Gegensatz dazu verwenden GPT‑4 und Claude dichte Transformer-Architekturen (ihre genauen Größen und Details sind nicht öffentlich bekannt), was bedeutet, dass alle Modellparameter für jedes Token genutzt werden. Die Architektur von Gemini ist auch nativ multimodal – es wurde von Grund auf gemeinsam mit Text, Bildern und Audio (und sogar Video) vortrainiert, anstatt später separate visuellen Module hinzuzufügen[3]. Dieses integrierte Design hilft ihm, über Modalitäten hinweg effektiver zu schlussfolgern als frühere multimodale Ansätze, die oft separate Netzwerke kombinierten[4].

Multimodale Fähigkeiten: Gemini 3 ist ein „nativ multimodales“ Modell. Es kann Text, Bilder, Audio und Video als Eingabe akzeptieren und Text (und sogar Bilder) als Ausgabe generieren[5][6]. Zum Beispiel können Sie Gemini ein Bild zusammen mit einer Frage oder sogar einen Audio- oder Videoausschnitt geben, und es wird den Inhalt interpretieren und mit Analysen oder Antworten reagieren. Google berichtet, dass Gemini frühere Modelle beim Verständnis von Bildern übertrifft, ohne auf externe OCR für Text in Bildern angewiesen zu sein[7] – ein Beweis für sein umfassendes visuelles Verständnis. Durch das Training auf mehreren Modalitäten von Anfang an und das Feintuning mit zusätzlichem multimodalem Datenmaterial entwickelt Gemini eine einheitliche Darstellung von Text- und visuellen/audio Daten[8]. Besonders bemerkenswert ist, dass Gemini Bilder aus Textvorgaben erzeugen kann (über das integrierte Gemini Image Modell) und sogar Bildbearbeitungsoperationen durch Textanweisungen ausführen kann[6]. Dies geht über die visuellen Fähigkeiten von GPT‑4 hinaus – GPT‑4 kann Bilder interpretieren (GPT‑4V) und textlich beschreiben, jedoch keine neuen Bilder erzeugen (die Bilderzeugung wird in OpenAIs Ökosystem von separaten Modellen wie DALL·E übernommen). Anthropics Claude 2 hingegen ist derzeit ein reines Textmodell – es akzeptiert oder erzeugt standardmäßig keine Bilder/Audio. Somit hebt sich Gemini 3 durch seine Unterstützung für multimodale Ein- und Ausgabe hervor, indem es Text, Vision und Audio/Video nahtlos in einem System verarbeitet.

Trainingsdaten und Umfang: Während die genauen Parameter für Gemini 3 (Ultra) nicht öffentlich sind, wurde es auf einem extrem großen und vielfältigen Datensatz trainiert. Googles kleinere Gemma 3 offene Modelle (27B und kleiner) wurden mit bis zu 14 Billionen Tokens trainiert, die Webtexte, Code, Mathematik und Bilder in über 140 Sprachen abdecken[9][10]. Wir können davon ausgehen, dass das Flaggschiff Gemini ähnlich umfangreiche Daten nutzte. Der Wissensstand von Gemini 2.5 (dem unmittelbaren Vorgänger) war Januar 2025[11], was bedeutet, dass es auf Informationen bis vor kurzem trainiert wurde und damit aktueller ist als GPT‑4 oder Claude. (Zum Vergleich: Der Wissensstand von GPT‑4 lag bei der ersten Veröffentlichung im März 2023 etwa im September 2021, obwohl GPT‑4 Turbo später mit Wissen über Weltereignisse bis April 2023 aktualisiert wurde[12]. Die Trainingsdaten von Claude 2 reichen im Allgemeinen bis Anfang 2023.) Dies deutet darauf hin, dass Gemini 3 die aktuellste Wissensbasis der drei Modelle bis Ende 2025 hat. Google hat auch eine umfassende Datenfilterung zur Sicherheit angewandt, um problematische Inhalte (z.B. CSAM oder sensible persönliche Daten) aus dem Trainingskorpus von Gemini zu entfernen[13].

Langer Kontextbereich: Ein Hauptmerkmal von Gemini ist seine enorme Kontextlänge. Gemini 3 kann extrem lange Eingaben – über 1 Million Tokens in seinem Kontextfenster verarbeiten[14]. Dies ist eine Größenordnung mehr, als andere Modelle derzeit bieten. Praktisch gesehen entsprechen 1 Million Tokens etwa 800.000 Wörtern oder mehreren tausend Seiten Text. Google hat gezeigt, dass Gemini 2.5 ein 402-seitiges Apollo-Mission-Transkript lesen und zusammenfassen konnte und sogar über 3 Stunden Videoinhalt ohne Probleme schlussfolgern konnte[15]. Zum Vergleich: OpenAI's basiertes GPT‑4 bietet 8K oder 32K Token-Kontextoptionen, und das neuere GPT‑4 Turbo unterstützt bis zu 128K Tokens im Kontext[16] – etwa 300 Seiten Text. Anthropics Claude 2 kam ursprünglich mit einem 100K-Token-Fenster, und das aktualisierte Claude 2.1 verdoppelte dies auf 200K Tokens (ungefähr 150.000 Wörter oder 500+ Seiten)[17]. Während Claude 2.1 nun OpenAI in der Kontextgröße übertrifft (200K vs 128K), übertrifft Gemini 3 beide weiterhin mit einer Kapazität von über 1M Tokens. Dieser enorme Kontext ist besonders nützlich für Aufgaben wie das Einlesen ganzer Codebasen, großer Dokumente oder sogar mehrerer Dokumente gleichzeitig. Es bringt jedoch auch einen Rechenaufwand mit sich – die Verarbeitung von Hunderttausenden von Tokens wird langsamer sein (Anthropic merkt an, dass eine 200K-Token-Abfrage für Claude 2.1 einige Minuten dauern kann)[18]. Der Vorteil von Google ist, dass auf ihrer TPUv5-Infrastruktur Gemini verteilt und für diese langen Kontexte optimiert werden kann.

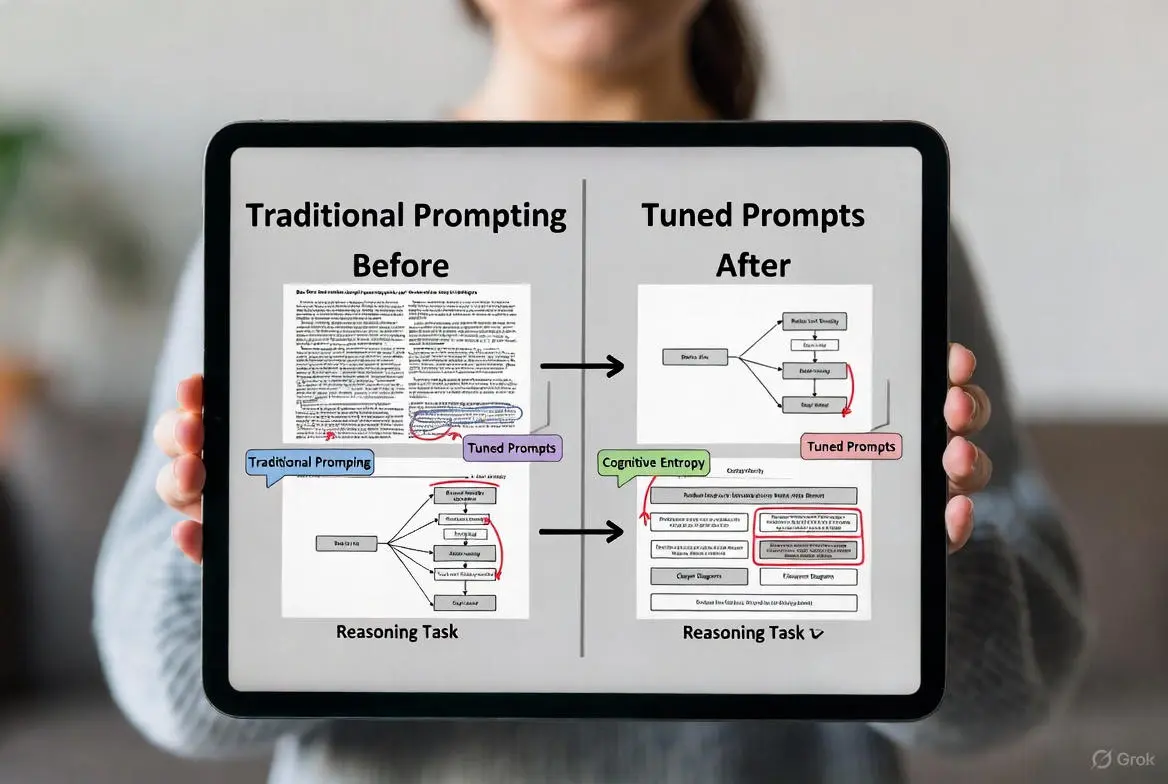

Benchmark-Leistung: Auf standardmäßigen akademischen Benchmarks hat Gemini 3 (und seine Vorgänger der Version 2.x) Spitzenergebnisse erzielt. Tatsächlich war Gemini das erste Modell, das die Leistung menschlicher Experten im massiven Multitask-MMLU-Examen übertraf[19]. Gemini 1.0 Ultra erreichte 90,0 % im MMLU[20], knapp über dem menschlichen Expertenmaßstab (~89,8 %)[21][22] und weit über GPT-4s Ergebnis. (GPT-4s berichtete MMLU-Genauigkeit beträgt 86,4 % in einem vergleichbaren 5-Schritt-Setting[23]. Gemini erreichte seine 90 % durch den Einsatz fortschrittlicher Prompting-Techniken – z.B. Kette-von-Gedanken mit Mehrheitsentscheidung – um „sorgfältiger zu überlegen“, bevor Antworten gegeben wurden[24].) Gemini übertraf GPT-4 auch in vielen anderen Aufgaben bei frühen Bewertungen. Zum Beispiel erzielte Gemini Ultra im Big-Bench-Hard-Suite anspruchsvoller Denkaufgaben 83,6 % gegenüber GPT-4s 83,1 % (im Wesentlichen ein Unentschieden für den Spitzenplatz)[25]. Bei mathematischen Textaufgaben im GSM8K erreichte Gemini 94,4 % Genauigkeit (mit Kette-von-Gedanken-Prompting) im Vergleich zu GPT-4s ~92 %[26]. Im Bereich Programmierung hat Gemini bemerkenswerte Fähigkeiten gezeigt: Es erreichte 74,4 % beim HumanEval-Python-Programmierungsbenchmark (pass@1)[27], deutlich über GPT-4s ~67 % im gleichen Test[28]. Tatsächlich ist Geminis Programmierfähigkeit branchenführend – Google bemerkte, es „übertrifft mehrere Programmierbenchmarks, einschließlich HumanEval“, und führte sogar ein AlphaCode 2 System ein, das von Gemini betrieben wird und Programmieraufgaben lösen kann, die das ursprüngliche AlphaCode übertreffen[29][30]. Zusammenfassend liefert Gemini 3 erstklassige Leistung in Wissensbegründung, Mathematik und Programmierung, und übertrifft oft GPT-4 und Claude in Benchmark-Ergebnissen (detaillierte Vergleiche folgen im nächsten Abschnitt).

Erweiterter „Deep Thinking“-Modus: Eine markante Fähigkeit der Gemini 2.x-Generation ist die Einführung eines Denkmodus namens „Deep Think“. Dieser Modus ermöglicht es dem Modell, intern durch Schritte zu denken, bevor es eine endgültige Antwort gibt[31][32]. In der Praxis werden Techniken wie parallele Gedankenketten und Selbstreflexion umgesetzt, inspiriert durch Forschung im Bereich Scratchpad Reasoning und Tree-of-Thoughts. Google berichtet, dass Gemini 2.5 Deep Think die Fähigkeit des Modells, komplexe Probleme zu lösen, die Kreativität und schrittweise Planung erfordern, deutlich verbessert hat, indem das Modell mehrere gedankliche Kandidatenpfade generiert und bewertet[33][34]. Beispielsweise erzielte Gemini 2.5 Pro mit aktiviertem Deep Think höhere Punktzahlen bei schwierigen Benchmarks (wie in Googles „Thinking vs. Non-Thinking“-Bewertungsmodi zu sehen)[35]. Während dieser Modus in Gemini 2.5 eine separate Einstellung war, gibt es Gerüchte, dass Gemini 3 diese fortschrittlichen Denkstrategien standardmäßig integriert, sodass kein separater Schalter mehr erforderlich ist[36]. Weder GPT‑4 noch Claude verfügen über eine genau gleichwertige Funktion, die Endbenutzern zugänglich ist (obwohl auch sie durch Aufforderungen zum Ketten-Denken angeregt werden können). Bemerkenswert ist auch das „adaptive thinking budget“ von Gemini – Entwickler können einstellen, wie viel Denkvermögen das Modell anwenden soll (wobei Kosten/Latenz gegen Qualität abgewogen werden), und das Modell kann die Denktiefe automatisch kalibrieren, wenn kein Budget festgelegt ist[37][38]. Diese Ebene der Kontrolle ist einzigartig für Googles Angebot und spricht Entwickler an, die das Qualitäts-Geschwindigkeits-Verhältnis feinabstimmen müssen.

Infrastruktur und Effizienz: Google hat Gemini entwickelt, um auf ihrer speziellen TPU-Hardware hoch effizient und skalierbar zu sein. Laut Google wurde Gemini auf TPU v4- und v5e-Pods trainiert und ist das skalierbarste und zuverlässigste Modell, das sie bisher trainiert haben[39][40]. Tatsächlich kündigte Google bei der Einführung einen neuen Cloud TPU v5p Supercomputer an, der speziell entwickelt wurde, um Gemini und die nächste Generation der KI-Entwicklung zu beschleunigen[40]. Ein Vorteil besteht darin, dass Gemini schneller bei der Inferenzzeit laufen kann als frühere Modelle, trotz seiner Größe – Google bemerkte, dass Gemini auf TPUs eine 40%ige Reduzierung der Latenz für englische Anfragen in einem internen Test im Vergleich zum vorherigen Modell erreichte[41]. Darüber hinaus hat Google verschiedene Größen von Gemini, um unterschiedlichen Anforderungen gerecht zu werden: z.B. sind Gemini Flash und Flash-Lite kleinere, schnellere Varianten, die für geringere Latenz und Kosten optimiert sind, während Gemini Pro (und Ultra) größer sind, um maximale Qualität zu bieten[42][43]. Dies ist analog zu OpenAI, das GPT-3.5 Turbo vs GPT-4 anbietet, oder Anthropic, das Claude Instant vs Claude-v2 anbietet. Beispielsweise ist Gemini 2.5 Flash-Lite für hochvolumige, kostenempfindliche Aufgaben gedacht, während 2.5 Pro für die komplexesten Aufgaben konzipiert ist[44][45]. Indem die gesamte “Pareto-Grenze” von Fähigkeit vs. Kosten abgedeckt wird, ermöglicht die Gemini-Familie Entwicklern, das Modell auszuwählen, das zu ihrem Anwendungsfall passt[46]. Die Flexibilität und TPU-Optimierung bedeuten, dass Gemini effizient eingesetzt werden kann, und Google nutzt es wahrscheinlich umfangreich in seinen Produkten (Search, Workspace, Android) mit optimiertem Service.

Zusammenfassung von Gemini 3: Im Wesentlichen ist Gemini 3 ein multimodales KI-Kraftpaket mit einer innovativen MoE-Architektur, enormer Trainingsbreite (aktuelles Wissen, Code und visuelle Daten), einem beispiellosen Kontextfenster (~1M Token) und einer erstklassigen Leistung bei akademischen Benchmarks. Es führt neue Ebenen des Denkens ein (durch seinen „Denken“-Modus) und bietet Entwicklern die Möglichkeit, Genauigkeit und Geschwindigkeit auszubalancieren. Als Nächstes werden wir untersuchen, wie sich diese Stärken gegen OpenAI's GPT‑4 und die Claude 2-Serie von Anthropic behaupten.

Vergleich der Leistungsbenchmarks

Um den Vergleich zu untermauern, betrachten wir Standard-Benchmark-Ergebnisse für jedes Modell bei Schlüsselaufgaben: Wissen & Denken (MMLU und Big-Bench Hard), mathematische Textaufgaben (GSM8K) und Codierung (HumanEval). Diese Benchmarks sind zwar nicht umfassend, geben aber einen quantitativen Eindruck von den Fähigkeiten jedes Modells.

- MMLU (Massive Multitask Language Understanding): Dies ist ein Test des Wissens und der Argumentation über 57 Fächer hinweg. Gemini 3 (Ultra) erreichte etwa 90% Genauigkeit – bemerkenswert über dem Niveau menschlicher Experten (Menschen ~89,8%)[21][22]. GPT‑4 erzielte im Vergleich dazu 86,4% im OpenAI-Bericht (5-shot Einstellung)[23]. Claude 2 liegt etwas niedriger; Anthropic berichtete 78,5% auf MMLU für Claude 2 (5-shot mit Kettenargumentation)[47]. Für umfangreiches Wissen und Argumentation sind Gemini und GPT‑4 sehr stark (Gemini etwas höher), während Claude 2 hinter ihnen zurückbleibt. Es ist erwähnenswert, dass alle diese Modelle sich verbessern, wenn sie fortgeschrittene Prompting-Techniken verwenden dürfen (z.B. kann GPT‑4 mit Kettenargumentation und Voting ~87–88% erreichen[48]), aber die Zahl von Gemini spiegelt bereits wider, dass es während der Bewertung sorgfältige Argumentation nutzt[24].

- BIG-bench Hard (BBH): Dies ist eine Sammlung besonders herausfordernder Argumentationsaufgaben. GPT‑4 und Gemini liegen hier im Wesentlichen gleichauf – Gemini Ultra erreichte 83,6% und GPT‑4 etwa 83,1% auf BBH (beide in einer Few-Shot-Einstellung)[25]. Diese Ergebnisse liegen weit über den meisten älteren Modellen. Wir haben keine offizielle Claude 2-Bewertung auf BBH in veröffentlichten Quellen; Drittevaluierungen deuten darauf hin, dass Claude möglicherweise etwas niedriger liegt (möglicherweise im Bereich von 70% auf BBH). Im Allgemeinen sind GPT‑4 und Gemini bei vielen komplexen Argumentationstests gleichwertig und gewinnen jeweils leicht in einigen Kategorien. Google behauptete, dass Gemini auf 30 von 32 akademischen Benchmarks SOTA übertraf[49], was bedeutet, dass es zumindest GPT‑4 auf fast allen ebenbürtig ist.

- Mathematik – GSM8K: Dieser Benchmark für Mathematikaufgaben auf Grundschulniveau erfordert mehrstufiges Denken (normalerweise gelöst durch Kettenargumentation). Gemini zeigte herausragende mathematische Fähigkeiten – es erreichte 94,4% auf GSM8K (mit Mehrheitsvoting über 32 Argumentationswege)[26]. GPT‑4 ist auch hervorragend in Mathematik; OpenAI berichtete etwa 92% auf GSM8K mit Few-Shot-CoT-Prompting[26]. Claude 2 wurde Zero-Shot mit CoT getestet und erreichte 88,0%[50], was etwas unter GPT‑4 liegt. Alle drei Modelle sind bei mathematischen Textaufgaben weitaus besser als frühere Generationen (zum Vergleich: GPT-3.5 erreichte ~50-60% auf GSM8K). Aber Gemini hat derzeit die Nase vorn in Mathematik, wahrscheinlich aufgrund seines „parallelen Denkens“, das Lösungen mit höherer Zuverlässigkeit findet[33].

- Coding – HumanEval (Python): Dies misst die Fähigkeit des Modells, korrektes Code für Programmieraufforderungen zu generieren. Gemini 3 führt hier mit ~74–75% pass@1 bei HumanEval[27]. Dies ist ein branchenbestes Ergebnis auf diesem Benchmark. Claude 2 machte auch große Fortschritte im Codieren – es erzielt 71,2% pass@1[50], was tatsächlich GPT‑4 übertrifft. GPT‑4 erreichte im technischen Bericht vom März 2023 67% auf HumanEval (0-Shot)[28]. Bei reinen Codierungsaufgaben ist die Rangfolge Gemini > Claude 2 > GPT‑4. Anscheinend finden Benutzer Claude ziemlich gut im Codieren (es kann sehr detaillierten Code mit Erklärungen ausgeben), aber die Gemini-Modelle von Google scheinen davon profitiert zu haben, dass sie intensiv auf Code trainiert wurden und möglicherweise neue Techniken verwenden (Google hat sogar ein internes Benchmark WebDev Arena für Codierung erstellt, wo Gemini 2.5 Pro die Bestenliste anführte[51]). Es ist auch bemerkenswert, dass Google Gemini in AlphaCode 2 einsetzt, das ~2× mehr Wettbewerbsprobleme als das ursprüngliche AlphaCode löste (das auf einem älteren Modell basierte)[52] – was darauf hindeutet, dass Geminis Kombination aus Codierung und allgemeiner Argumentationsfähigkeit für algorithmische Herausforderungen leistungsstark ist.

- Weitere Bewertungen: Bei wissensintensiven QA (TriviaQA), Langformverständnis (QuALITY) und Wissenschaftsfragen (ARC-Challenge) schneiden alle Modelle stark ab, wobei GPT‑4 und Gemini typischerweise im Bereich von hohen 80% bis 90% liegen und Claude oft in den 80ern. Zum Beispiel erreichte Claude 2 91% bei der ARC-Challenge, fast auf Augenhöhe mit GPT‑4[53]. Beim gesunden Menschenverstand (HellaSwag) hatte GPT‑4 tatsächlich einen Vorteil und erreichte ~95% gegenüber Gemini 87,8%[54] – möglicherweise aufgrund von Unterschieden in den Trainingsdaten oder der Ausrichtung auf gesunden Menschenverstand. Und bei mehrsprachigen Aufgaben berichtet Google, dass Gemini überdurchschnittlich abschneidet; eine Variante („Global MMLU“) zeigte Gemini 2.5 Pro ~89%[55], was auf ein robustes mehrsprachiges Verständnis hinweist. Alle drei Modelle sind in einer Vielzahl von NLP-Benchmarks fähig, aber Gemini 3 und GPT‑4 stehen im Allgemeinen an der Spitze, wobei sie sich je nach Aufgabe abwechseln, während Claude 2/2.1 in der Gesamtbewertung akademischer Benchmarks eine Stufe darunter liegt.

Hier fassen wir einige dieser Benchmark-Vergleiche in der untenstehenden Tabelle zusammen:

Vergleichstabelle: Wichtige Kennzahlen und Fähigkeiten

Die folgende Tabelle zeigt die wichtigen Leistungskennzahlen und Fähigkeiten von Googles Gemini 3, OpenAIs GPT‑4 (GPT‑4 Turbo) und Anthropics Claude 2.1:

Quellen: Leistungsmetriken stammen aus offiziellen Berichten: Google DeepMind’s Gemini technischer Blog[72][27], OpenAI’s GPT-4-Dokumentation[28] und Anthropic’s Claude-Modellkarte[50]. Kontext- und Funktionsinformationen stammen aus Google’s Ankündigungen[14][6], OpenAI DevDay-Nachrichten[16] und Anthropic-Updates[17].

Detaillierter Vergleich von Gemini 3, GPT‑4 und Claude 2.1

Nachdem wir die Zahlen auf hoher Ebene gesehen haben, lassen Sie uns die Modelle im Detail über verschiedene Dimensionen hinweg vergleichen:

Schlussfolgerungen und Allgemeine Intelligenz

Alle drei Modelle – Gemini 3, GPT‑4 und Claude 2 – befinden sich an der Spitze der KI-Denkfähigkeiten, aber Gemini und GPT‑4 sind bei den herausforderndsten Aufgaben generell stärker. GPT‑4 setzte bei seiner Veröffentlichung einen neuen Standard, indem es oft menschliches Leistungsniveau in Wissenstests und logischen Tests erreichte oder übertraf. Googles Gemini wurde ausdrücklich entwickelt, um diese Messlatte zu übertreffen, und tatsächlich gelang es ihm, GPT‑4 in vielen akademischen Benchmarks (MMLU, Mathematik, Programmierung usw., wie oben erwähnt) leicht zu übertreffen. In der praktischen Anwendung zeigen sowohl GPT‑4 als auch Gemini eine exzellente logische Konsistenz, mehrstufiges Denken (z.B. das schrittweise Lösen komplexer Probleme) und umfangreiches Wissen. Benutzer haben beobachtet, dass GPT‑4 einen sehr ausgereiften, zuverlässigen Denkstil hat – es befolgt normalerweise Anweisungen sorgfältig und liefert gut strukturierte, fundierte Antworten. Gemini 3, insbesondere mit seiner Deep Think-Fähigkeit, kann bei schwierigen Problemen noch analytischer sein und effektiv ein internes „Gedankenkettendenken“ durchführen, um die Genauigkeit bei kniffligen Fragen zu erhöhen[33][34]. Google hat gezeigt, wie Gemini komplexe Aufgaben wie das Erstellen von Simulationen, das Schreiben von komplexem Code und sogar das Spielen von Strategiespielen durch mehrstufiges Denken meistert[73][74]. Ein Vorteil von Gemini ist die Aktualität der Trainingsdaten – mit Wissen bis 2024/2025 könnte es neuere Informationen zu aktuellen Ereignissen oder Forschungsarbeiten haben, während GPT‑4 (2023-Schnittstelle) manchmal sehr aktuelle Fakten fehlt.

Claude 2, obwohl sehr fähig, wird oft als etwas weniger „intelligent“ oder gründlich im Vergleich zu GPT-4 bei komplexen Schlussfolgerungen beschrieben. Seine MMLU-Punktzahl (78,5 %) zeigt, dass es nicht das gleiche Prüfungsniveau erreicht[47]. Dennoch glänzt Claude bei Verständnis und Erklärung natürlicher Sprache – es hat ein Talent dafür, menschlich wirkende, klare Erklärungen seiner Überlegungen zu liefern. Anthropic hat Claude im Dialogformat (die „Assistant“-Persönlichkeit) trainiert, und es neigt dazu, seinen Gedankengang deutlicher zu artikulieren als GPT-4 (das standardmäßig endgültige Antworten gibt, es sei denn, es wird zu Zwischenschritten aufgefordert). Bei vielen Aufgaben des gesunden Menschenverstands oder alltäglichen Überlegungen ist Claude auf Augenhöhe mit GPT-4. Doch bei besonders schwierigen logischen Rätseln oder hochspezialisierten technischen Fragen behält GPT-4 in Bezug auf Genauigkeit die Oberhand. Nutzer berichten auch, dass Claude eher bereit ist, Unsicherheiten zuzugeben oder „Ich bin mir nicht sicher“ zu sagen, wenn es unsicher ist (eine absichtliche Gestaltung für Ehrlichkeit)[71], während GPT-4 möglicherweise versucht, eine Antwort zu geben. Dies kann dazu führen, dass Claude manchmal vorsichtiger oder eingeschränkter wirkt, was aber auch bedeutet, dass es möglicherweise weniger Fakten halluziniert.

Summary: GPT‑4 and Gemini 3 represent the state-of-the-art in general reasoning, with Gemini showing equal or slightly better performance on new benchmarks (thanks to advanced techniques and possibly more training data). Claude 2 is not far behind for many tasks and often provides very detailed reasoning in its answers, but it doesn’t quite reach the same benchmark highs. If your use case demands the absolute strongest reasoning on difficult problems (e.g. complex exams, tricky word problems), Gemini 3 or GPT‑4 would be the top choices, with Claude as a capable alternative that errs on the side of caution in its answers.

Coding and Software Assistance

Gemini 3 und OpenAI’s GPT‑4 sind beide außergewöhnlich starke Programmierer, und bemerkenswerterweise hat sich auch Claude 2 von Anthropic als großartiger Coding-Assistent erwiesen. Bei Codierungsbewertungen wie HumanEval und im Bereich des kompetitiven Programmierens liegt Gemini derzeit leicht vorn (mit einer Erfolgsquote von 74 % gegenüber 67 % bei GPT‑4)[27][28]. Google hat gezeigt, dass Gemini komplexen interaktiven Code generieren kann – zum Beispiel Fraktalvisualisierungen, Browser-Spiele oder Datenvisualisierungen von Grund auf erstellen, basierend lediglich auf hochrangigen Eingaben[73][74]. Dank seines Million-Token-Kontexts kann es sehr große Codebasen bewältigen – ein Entwickler könnte buchstäblich ein ganzes Repository oder mehrere Quelldateien in Gemini einfügen und es bitten, den Code zu refaktorisieren oder Fehler zu finden. Dies ist transformativ für Entwicklungs-Workflows: Gemini kann den gesamten Code-Kontext eines Projekts „merken“ und nutzen während seines Denkprozesses. GPT‑4’s Kontext erreicht maximal 128K (was immer noch genug für vielleicht ~100 Code-Dateien ist, abhängig von der Größe)[56], und Claude 2.1 mit 200K Tokens könnte ein wenig mehr schaffen. Aber keiner erreicht Gemini’s Fähigkeit, das Verständnis für ganze Codebasen zu erfassen.

Bei der täglichen Unterstützung beim Programmieren (wie dem Schreiben von Funktionen, dem Erklären von Code oder dem Vorschlagen von Verbesserungen) leisten alle drei Modelle gute Arbeit. GPT‑4 ist bekannt dafür, sehr zuverlässig korrekten und syntaktisch gültigen Code in Sprachen wie Python, JavaScript usw. zu generieren. Es war das erste Modell, das in GitHub Copilot integriert wurde (als Backend von Copilot X) und ist bei Entwicklern beliebt für Aufgaben wie das Schreiben von Unit-Tests, das Umwandeln von Pseudocode in Code und das Debuggen. Die Codeausgaben von GPT‑4 sind möglicherweise etwas prägnanter und auf den Punkt gebracht, während Claude oft sehr ausführliche Erklärungen zusammen mit dem Code liefert, was einige Entwickler schätzen (es ist wie Pair-Programming mit einem gesprächigen Senior-Ingenieur). In Bezug auf die Leistungsfähigkeit hat Claude 2 tatsächlich GPT‑4 bei einigen Programmier-Benchmarks übertroffen (71 % vs. 67 % bei HumanEval)[50][28], was darauf hinweist, dass Anthropic bei der Trainingserweiterung von Claude den Fokus auf Programmierung gelegt hat. Nutzer haben festgestellt, dass Claude besonders gut darin ist, mehrdeutige Anfragen zu verstehen und Details im Code auszufüllen (es ist weniger wahrscheinlich, dass es einfach ablehnt, wenn die Eingabe ungenau ist; es versucht, die Absicht zu erraten und etwas Funktionierendes zu produzieren).

Feinabstimmung und Tools für das Programmieren: OpenAI bietet spezialisierte Tools wie den Code Interpreter (jetzt als Advanced Data Analysis bekannt) und hat Plugin-Integrationen für das Programmieren (z. B. ein Terminal-Plugin oder Datenbank-Plugin), die die Nützlichkeit von GPT‑4 für das Programmieren erweitern. Google hat solche spezifischen „Codeausführungs“-Tools für Gemini nicht öffentlich angekündigt, aber angesichts der Integration von Gemini in die Google-Cloud kann man sich vorstellen, dass es in Colab-Notebooks verwendet wird oder mit einer Ausführungsumgebung für das Testen von Code verbunden ist. Anthropic hat kürzlich eine Toolnutzungs-API in Claude 2.1 eingeführt, die es ermöglicht, von Entwicklern bereitgestellte Funktionen auszuführen – zum Beispiel könnte man Claude erlauben, eine Kompilier- oder Testfunktion auf seinem generierten Code auszuführen[61][75]. Dies ist analog zu OpenAI's Funktionsaufruf, der eine Art dynamischen Programmieragenten ermöglicht, der seine eigenen Ausgaben testen und Fehler korrigieren kann. Alle Modelle können von solchen Feedback-Schleifen profitieren, aber sie sind derzeit auf die Implementierung durch Entwickler angewiesen.

Zusammenfassend lässt sich sagen, dass alle drei Modelle hervorragende Coding-Assistenten sind, aber Gemini 3’s großer Kontext und der etwas höhere Coding-Benchmark deuten darauf hin, dass es größere und komplexere Programmieraufgaben in einem Durchgang bewältigen kann (z. B. das Analysieren von Tausenden von Codezeilen zusammen). GPT‑4 hat sich in der Entwicklergemeinschaft mit Werkzeugen und Integrationen weitgehend bewährt, und Claude 2 ist eine starke Alternative, insbesondere für diejenigen, die seinen erklärenden Stil bevorzugen oder den 200K-Kontext für große Code-Dateien benötigen. Für reine Codiergenauigkeit scheint Gemini 3 leicht im Vorteil zu sein, mit Claude 2 nicht weit dahinter, und GPT‑4 ist immer noch sehr beeindruckend und wahrscheinlich der am meisten erprobte in realen Codierungsszenarien.

Multimodale Eingabe/Ausgabe

Hier hebt sich Gemini 3 wirklich ab. Gemini wurde von Anfang an als multimodale KI entwickelt, während GPT‑4 die visuellen Fähigkeiten als Erweiterung hinzugefügt hat und Claude bisher nur textbasiert bleibt.

- Gemini 3: Akzeptiert Bilder (einzelne oder sogar mehrere Bilder) als Teil des Prompts und kann sie tiefgehend verstehen – nicht nur beschreiben, sondern auch Diagramme analysieren, Grafiken lesen, Screenshots interpretieren usw. Es kann auch Audio und Video verarbeiten. Zum Beispiel könnte man Gemini einen Audioclip geben und Fragen zu dessen Inhalt stellen oder einen Videosegment (Frames oder Transkript) bereitstellen und eine Zusammenfassung oder Antwort erhalten. Google hat gezeigt, wie Gemini Stummfilme und komplexe visuelle Daten analysiert[76]. Standardmäßig produziert Gemini Text als Ausgabe, aber es hat auch die Fähigkeit, Bilder aus Text-Prompts zu generieren (ähnlich wie DALL·E oder Imagen) innerhalb seines Gemini Image Modus[6]. Das bedeutet, dass ein Benutzer Gemini bitten kann, ein Kunstwerk zu erschaffen oder ein gegebenes Bild zu bearbeiten („lass dieses Foto wie ein Gemälde aussehen“), alles innerhalb desselben KI-Systems. Diese multimodale Generierung ist ein großer Schritt über das hinaus, was GPT-4/Claude nativ leisten können. Zusätzlich kann Gemini in bestimmten Kontexten mit Videoausgaben arbeiten (z.B. kann es Code für Animationen generieren oder möglicherweise Videoszenen beschreiben – obwohl die eigentliche Videorahmengenerierung wahrscheinlich von einem verwandten Modell wie Phenaki oder Imagen Video übernommen wird). Insgesamt ist Geminis multimodale Kompetenz hochmodern; es versteht und verknüpft verschiedene Modalitäten nativ. Zum Beispiel könnte es ein Bild analysieren und dann diese Informationen in einer textlichen Argumentationskette oder einer Codegenerierungsaufgabe verwenden, fließend.

- GPT‑4: Nur teilweise multimodal. GPT‑4 (das Basismodell) akzeptiert Bilder als Eingabe – man kann ihm ein Bild geben und Fragen dazu stellen. Dies ist die „Vision“-Funktion von GPT-4 (die ursprünglich 2023 in einer begrenzten Beta verfügbar war). Sie ist ziemlich leistungsstark: GPT-4 kann Bilder beschreiben, Objekte identifizieren, Text in Bildern lesen und über visuelle Inhalte nachdenken. Zum Beispiel haben Benutzer gezeigt, wie GPT-4 Vision Memes interpretiert oder den Inhalt eines Kühlschrankbildes analysiert, um Rezepte vorzuschlagen. Allerdings kann GPT‑4 keine Bilder oder Audiodaten ausgeben – seine Ausgaben sind rein textuell. Wenn man es bittet, ein Bild zu zeichnen, kann es bestenfalls eine textuelle Beschreibung oder ASCII-Kunst produzieren. OpenAI behandelt die Bilderzeugung über ein separates Modell (DALL·E 3), das aufgerufen werden kann, aber das liegt außerhalb von GPT-4 selbst. Also ist die multimodale Fähigkeit von GPT‑4 einseitig (Visuelle Eingabe zu Textausgabe). Es kann auch keine Audio- oder Videoeingaben direkt verarbeiten (das OpenAI Whisper-Modell übernimmt die Umwandlung von Sprache zu Text, aber auch das ist getrennt und nicht in die Konversationsschnittstelle von GPT-4 als einheitliche Modalitäten-Pipeline integriert). GPT‑4 Turbo führte Sprachausgabe für ChatGPT ein (Text-zu-Sprache), aber das ist nicht das Modell, das Audio erzeugt; es ist ein separates TTS-System. Zusammenfassend ist GPT‑4 teilweise multimodal (Text+Vision), während Gemini vollständig multimodal (Text+Vision+Audio+Video) im Verständnis ist, und zusätzlich kann Gemini Inhalte in mehreren Modalitäten generieren.

- Claude 2.1: Unterstützt derzeit keine Bild- oder Audioeingaben. Es ist rein ein textbasiertes Konversationsmodell. Man kann Claude kein Bild geben oder es bitten, ein Bild zu interpretieren (es wird einfach sagen, dass es keine Bilder sehen kann). Anthropic hat sich auf Text konzentriert und keine Vision-Features für Claude 2.1 angekündigt. Es gab Hinweise darauf, dass sie in Zukunft Multimodalität erkunden könnten, aber derzeit hinkt Claude in diesem Bereich hinterher. Wenn Ihre Aufgabe also Bilder oder andere nicht-textuelle Daten umfasst, ist Claude keine Option, außer durch Umwandlung dieser Eingaben in Text (z.B. Transkription von Audio und dann Claude geben).

In praktischen Anwendungen öffnen die multimodalen Fähigkeiten von Gemini 3 viele Möglichkeiten: Man könnte es als einzigen KI-Agenten verwenden, um ein PDF mit Text und Bildern (Tabellen, Diagrammen) zu analysieren oder um Fragen zu den Inhalten eines Videos zu beantworten usw. Zum Beispiel zeigte Google, dass auf einem neuen multimodalen Benchmark (genannt MMMU) Gemini Ultra einen neuen Stand der Technik mit 59,4% erreichte, während vorherige Modelle Schwierigkeiten hatten[77][78]. Die Fähigkeit, Modalitäten in einem Prompt zu mischen, bedeutet auch, dass man Dinge tun kann wie: „Hier ist ein Grafikenbild – welchen Trend zeigt es? Entwerfen Sie nun einen Bericht (Text) über diesen Trend.“ Gemini kann das Diagramm erfassen und direkt den Textbericht produzieren, der es analysiert. GPT‑4 könnte ein Diagrammbild ähnlich gut analysieren, aber Claude konnte es überhaupt nicht.

Fazit: Für jeden Anwendungsfall, der visuelles oder Audio-Verständnis zusammen mit Sprache erfordert, ist Gemini 3 das fähigste und flexibelste Modell. Die Vision von GPT‑4 ist mächtig, aber Gemini deckt mehr Datentypen ab und kann auch visuelle Inhalte generieren. Claude ist derzeit auf textuelle Aufgaben beschränkt. Daher gewinnt Gemini 3 in einem multimodalen Vergleich mit seinen umfassenden multisensorischen Fähigkeiten klar, mit GPT‑4 an zweiter Stelle (nur Vision) und Claude, der sich auf Text konzentriert.

Kontextfenster und Effizienz

Wir haben bereits über Kontextlängen gesprochen, aber lassen Sie uns die Effizienzüberlegungen noch einmal hervorheben und erweitern. Kontextfenster bezieht sich darauf, wie viel Eingabe (und generierte Ausgabe) das Modell gleichzeitig berücksichtigen kann. Ein größeres Kontextfenster ermöglicht es dem Modell, sich an frühere Gespräche oder größere Dokumente zu erinnern. Wie bereits erwähnt:

- Gemini 3: ~1 Million Token Kontextfenster[14]. Dies ist dramatisch höher als bei anderen. Das bedeutet, dass Gemini sehr lange Texte aufnehmen kann (wie ganze Bücher, umfangreiche technische Dokumente oder massive Aufforderungshistorien). Für Unternehmen könnte dies bahnbrechend sein: Stellen Sie sich vor, Sie füttern ein ganzes Unternehmenswissensdatenbank oder Hunderte von Seiten regulatorischer Texte auf einmal ins Modell. Gemini könnte dann Fragen beantworten oder Zusammenfassungen erstellen, die auf jedem Teil dieses riesigen Inputs basieren. Ein 1M-Token-Kontext ermöglicht auch komplexes agentisches Verhalten – Gemini könnte bei Bedarf intern Pläne oder Code über ein sehr langes Notizbuch generieren. Der praktische Nachteil ist Gedächtnis und Geschwindigkeit: Die Verarbeitung von 1M Tokens Eingabe ist schwer. Google verwendet wahrscheinlich effiziente Implementierungen (und MoE hilft, weil nicht alle Experten alle Tokens sehen). Sie berichteten auch über zwei Metriken in ihrem technischen Bericht: ein 128k-Token-Szenario vs. 1M-Token-Szenario, was darauf hindeutet, dass sie sich bewusst sind, dass das Modell über eine bestimmte Länge hinaus möglicherweise eine andere Strategie verwendet (128k wurde auf „durchschnittliche“ Weise bewertet, 1M auf „punktweise“ Weise)[79][80]. In jedem Fall werden Sie bei den meisten Anwendungen dieses Limit nicht erreichen, aber es bietet enormen Spielraum.

- Claude 2.1: 200k Token Kontext[17]. Dies ist ebenfalls extrem hoch, nur hinter Gemini. Anthropic verdoppelte es von 100k auf 200k mit Claude 2.1 und bezeichnete es zu diesem Zeitpunkt als „branchenführenden“ Kontext[17]. 200k Tokens entsprechen ungefähr 150k Wörtern (etwa 500 Seiten Text). Anthropic erwähnte speziell Anwendungsfälle wie das Einfüttern langer Finanzberichte, ganzer Codebasen oder langer Literatur und ließ Claude sie analysieren[81]. Der Haken ist, dass Claude zwar so viel aufnehmen kann, aber langsam sein könnte (sie erwähnen, dass es einige Minuten dauern kann, um Eingaben mit maximaler Länge zu verarbeiten)[18]. Außerdem kostet es mehr (die Preise skalieren mit Tokens). Sie arbeiten daran, dies zu optimieren. Aber aus Verfügbarkeitsperspektive ist der vollständige 200k-Kontextmodus von Claude 2.1 für Entwickler (Pro-Stufe) zugänglich, was beeindruckend ist.

- GPT‑4 / GPT‑4 Turbo: Ursprünglich bot GPT‑4 8k und 32k Token-Modelle an. Ende 2023 kündigte OpenAI GPT‑4 Turbo mit 128k Kontext an, was es näher an Claudes Bereich bringt[16]. Das 128k-Kontextmodell ist derzeit in der Beta-/Vorschau für Entwickler, aber es wird erwartet, dass es bald in die Produktion geht. 128k Tokens (~96k Wörter) entsprechen etwa dem Vierfachen eines 32k-Kontexts und reichen für die meisten praktischen Aufgaben aus (etwa 300 Seiten Text). OpenAI führte sogar eine Demo durch, bei der GPT‑4 einen ganzen Roman (Jane Austens Emma) las und Fragen beantwortete, was das Verständnis von Langkontexten demonstriert. So hat GPT‑4 die Lücke in der Kontextlänge erheblich geschlossen. Dennoch ist es 1/8 des theoretischen Maximums von Gemini und etwa die Hälfte des Maximums von Claude. Für extrem große Eingaben würde GPT‑4 Chunking-Strategien benötigen, während Claude oder Gemini es möglicherweise in einem Durchgang bewältigen könnten. OpenAI hat noch keine Pläne über 128k hinaus angekündigt.

Effizienz und Latenz: Bei größeren Kontexten und Modellen wird die Inferenzgeschwindigkeit zu einem Problem. GPT‑4 in seiner Grundform ist dafür bekannt, langsamer als GPT-3.5 zu sein und benötigt oft merklich länger für Antworten (insbesondere bei längeren Kontexten). OpenAI hat dieses Problem durch die Optimierung von GPT‑4 Turbo angegangen, um schneller und günstiger zu sein – sie berichteten 3× günstigere Eingabetokens und 2× günstigere Ausgabetokens für GPT‑4 Turbo im Vergleich zum ursprünglichen GPT-4[16][67], was auch einige Geschwindigkeitsgewinne oder zumindest Kosteneffizienz impliziert. Viele Entwickler haben beobachtet, dass GPT‑4 Turbo etwas schneller in der Antwort ist. Claude 2 ist für kurze bis mittlere Eingaben ziemlich schnell – oft schneller als GPT‑4 (da Claude etwas kleiner ist und für hohen Durchsatz optimiert wurde). Bei langen Kontexten wächst Claudes Latenz; bei vollen 200k, wie erwähnt, kann es Minuten dauern (was zu erwarten ist – das ist eine enorme Menge an Text, die verarbeitet werden muss). Gemini 3s Leistung in Bezug auf Geschwindigkeit wurde von außen noch nicht direkt gemessen, aber Googles Behauptung, “deutlich schneller als frühere Modelle auf TPUs”[82], deutet darauf hin, dass es effizient ist. Darüber hinaus bietet Google leichtere „Flash“-Varianten von Gemini an, was bedeutet, dass ein Entwickler, wenn Latenz kritisch ist, Gemini Flash oder Flash-Lite wählen kann, die schneller reagieren (bei einigen Genauigkeitsverlusten)[83][84]. Im Gegensatz dazu haben OpenAI und Anthropic auch die Idee kleinerer Modelle: GPT-3.5 Turbo ist eine schnelle Alternative für einfachere Aufgaben, und Claude Instant ist Anthropics schnelles Modell.

Ein weiterer Aspekt ist die Kosteneffizienz: Alle Anbieter verlangen mehr für die Nutzung des größten Kontexts. OpenAIs GPT-4 mit 128k wird pro Aufruf teuer sein, und Anthropics Claude mit 100k/200k Kontext kostet ebenfalls mehr (sie haben die Preise in Version 2.1 angepasst, um die Nutzung großer Kontexte günstiger zu gestalten [17][85]). Googles Preisgestaltung für Gemini über die API zeigt ein Gefälle: z.B. Gemini 2.5 Pro (mit >200k Kontext) hatte Kosten von etwa $1,25 pro 1M Tokens (oder $2,50 im „Denkmodus“)[35], während das kleinere Flash-Lite $0,10 pro 1M Tokens kostete[35] – eine enorme Spanne. Dies zeigt, dass Google erwartet, dass nur intensive Nutzer den massiven Kontext zu hohen Preisen nutzen, während die alltägliche Nutzung auf günstigeren Modellen stattfinden kann.

Fazit zu Kontext/Effizienz: Wenn Sie mit sehr großen Dokumenten oder Kontexten arbeiten müssen, ist Gemini 3 unschlagbar mit seinem 1M-Token-Fenster – es kann theoretisch ganze Bücher, Sammlungen von mehreren Dokumenten oder stundenlange Redeprotokolle auf einmal aufnehmen. Claude 2.1 belegt den zweiten Platz mit einem sehr großzügigen 200k-Fenster, das in der Praxis fast alle Anwendungsfälle abdeckt (außer vielleicht ganze Bibliotheken). GPT-4's 128k ist jetzt auch ziemlich groß, hinkt jedoch noch hinterher. Bei typischer Nutzung von einigen tausend Tokens sind alle Modelle einigermaßen schnell, wobei GPT-4 das langsamste, aber präziseste ist, Claude recht schnell ist und Gemini wahrscheinlich auf Googles Backend optimiert ist (obwohl genaue Geschwindigkeitsvergleiche ohne öffentliche Daten schwer sind). Googles Ansatz bietet mehr Flexibilität (verschiedene Modellgrößen, anpassbare Argumentation), während OpenAI und Anthropic sich auf eine einfachere Modellauswahl konzentrieren und den Benutzer entscheiden lassen, ob er höhere oder niedrigere Ebenen wählt (GPT-4 vs 3.5, Claude vs Claude Instant).

Entwicklertools und Feinabstimmung

Jeder dieser KI-Anbieter bietet ein unterschiedliches Ökosystem für Entwickler:

- Google Gemini (über Vertex AI & AI Studio): Google stellt Gemini über seine Cloud-Plattform (Vertex AI) und über eine API (Google AI Studio) zur Verfügung[86]. Entwickler können Gemini in Anwendungen auf Google Cloud verwenden und in Produkte integrieren (zum Beispiel integriert Google Gemini in Workspace-Apps wie Gmail, Docs usw. über ihre Duet AI). Ein bemerkenswertes Angebot ist Gemma – eine Familie von Open-Source- (oder Open-Weight-)Modellen, die mit Gemini verwandt sind[63]. Gemma 3-Modelle (27B, 12B, 4B usw.) sind kleiner, offen verfügbar und können von Entwicklern mit ihren eigenen Daten feinabgestimmt werden[64]. Diese Modelle teilen einige Technologien mit Gemini und geben der Community Zugang zu hochwertigen Modellen, ohne dass die Google-API benötigt wird. Für die Feinabstimmung der größten Gemini-Modelle (Ultra/Pro) selbst hat Google das nicht für Kunden geöffnet (es wird vermutlich intern mit RLHF feinabgestimmt und bleibt geschlossen). Google bietet jedoch Tools für Prompt-Engineering und -Verankerung – z. B. ermöglicht die Vertex AI-Plattform die generative Abfrageerweiterung, sodass Entwickler Gemini mit ihren privaten Daten über Vektorsuche nutzen können, anstatt die Modellgewichte zu ändern. Google betont auch „verantwortungsvolle AI“-Toolkits[87], um Entwicklern zu helfen, Prompts zu testen und anzupassen, um Toxizität oder Vorurteile zu verringern, wenn sie auf Gemini aufbauen. Ein weiterer einzigartiger Aspekt ist die Denken-Budget-Kontrolle, wie erwähnt – ein Entwickler kann programmatisch entscheiden, ob eine bestimmte Anfrage im „Schnellmodus“ (oberflächliche Argumentation) oder im „Tiefdenkmodus“ für mehr Genauigkeit bearbeitet werden soll[66]. Dies ist ein neuartiger Hebel zur Kostenoptimierung.

- OpenAI GPT‑4: OpenAI bietet GPT-4 über seine API und in der ChatGPT-Oberfläche an. Für Entwickler hat OpenAI ein reichhaltiges Ökosystem aufgebaut: Funktionsaufrufe (die es GPT-4 ermöglichen, JSON auszugeben und externe Funktionen auszulösen)[88], die Assistants API (angekündigt auf dem DevDay), die hilft, agentenähnliche Zustände und Werkzeugnutzung beizubehalten, und Plugin-Frameworks, die GPT-4 den Zugriff auf externe Tools (z. B. Browsing, Datenbanken, Code-Ausführung) ermöglichen. Die Feinabstimmung von GPT-4 selbst ist noch nicht allgemein zugänglich – OpenAI hatte eine Warteliste für die GPT-4-Feinabstimmung, die sich in den experimentellen Phasen befindet[89]. Sie haben die Feinabstimmung auf GPT-3.5 Turbo ermöglicht. Derzeit verwenden die meisten Entwickler GPT-4 in einer Zero-Shot- oder Few-Shot-Manier, möglicherweise ergänzt durch Abruf (OpenAIs neue Retrieval-API hilft, GPT-4 einfach mit Vektordatenbanken zu verbinden). OpenAIs Plattform ist bekannt für Benutzerfreundlichkeit – es gibt viele Bibliotheken und Integrationen. Sie bieten auch Systemnachrichten an, um das Modell zu steuern (was Anthropic erst später hinzugefügt hat, und Googles API hat wahrscheinlich ähnliche Konstrukte). Zusammenfassend lässt sich sagen, dass OpenAIs Tooling sehr ausgereift ist mit Dingen wie dem Funktionsaufruf (der jetzt auch in Gemini und Claude Analogien hat) und der Verwaltung mehrerer Gesprächsrunden. Wenn ein Entwickler schnell ein AI-Modell in seine App integrieren möchte, sind OpenAIs APIs unkompliziert und gut dokumentiert. Der Nachteil ist, dass das Modell eine Blackbox ist (geschlossene Gewichte) und die Anpassung über den Prompt und Few-Shot hinaus begrenzt ist, es sei denn, man nimmt am Feinabstimmungsprogramm teil.

- Anthropic Claude 2/2.1: Anthropic bietet Claude über eine API (und eine Chat-Oberfläche bei claude.ai) an. Sie haben weniger öffentlich angekündigte „Features“ als OpenAI, aber mit Claude 2.1 haben sie Unterstützung für System-Prompts eingeführt (ähnlich wie bei OpenAIs Systemnachricht, um das Verhalten im Voraus festzulegen)[90] und die Tool Use API in der Beta[61]. Die Tool-Use-Funktion ist im Wesentlichen Anthropics Antwort auf OpenAIs Funktionsaufruf – Entwickler können Tools definieren (z. B. einen Taschenrechner, eine Websuche, eine Datenbankabfrage), und Claude kann entscheiden, diese während eines Gesprächs zu verwenden[62]. Dies ist eine große Verbesserung, die Claude in Anwendungen erweiterbarer macht (er kann Informationen abrufen oder Aktionen ausführen, anstatt sich nur auf seine Trainingsdaten zu verlassen). Claude hat keine öffentlich verfügbaren Feinabstimmungsoptionen. Seine „Constitutional AI“-Ausrichtung bedeutet, dass es in gewissem Maße darauf beschränkt ist, bestimmten Prinzipien zu folgen, die nicht direkt von Benutzern anpassbar sind – obwohl System-Prompts einige Anpassungen des Tons und Stils ermöglichen. Anthropic vermarktet Claude stark für den Unternehmenseinsatz (sie haben Partnerschaften mit AWS usw.), wobei sie sein großes Kontextverständnis für die Analyse von Geschäftsdokumenten und seine Sicherheitsfunktionen hervorheben. Sie haben auch Claude Instant, eine schnellere und günstigere Version (mit geringerer Qualität), die Entwickler für leichte Aufgaben verwenden können. Die Entwicklererfahrung mit Claude verbessert sich stetig: Anthropic hat kürzlich eine Web-Arbeitsplatz für die Prompt-Entwicklung gestartet[91] und arbeitet an der Dokumentationsparität mit OpenAI. Eine bemerkenswerte Sache: Viele Benutzer finden Claude sehr gut darin, den Gesprächskontext über lange Chats hinweg beizubehalten. Es kann weniger irrelevante Abschweifungen einführen und ist weniger wahrscheinlich, harmlose Anfragen abzulehnen (aufgrund seiner anderen Ausrichtungsstrategie), was einige Entwickler für benutzerorientierte Chatbots bevorzugen.

Integration with other products: Google is weaving Gemini into its own products (Android has APIs for on-device Nano models[87], Chrome is getting Gemini-based features, etc.), which means if you’re in the Google ecosystem, Gemini will be accessible in many places. OpenAI’s model is integrated via partnerships (e.g., Bing Chat uses GPT-4, certain Office 365 features use OpenAI via Azure). Anthropic’s Claude is integrated into fewer end-user products but is available in platforms like Slack (Claude app), and they collaborate with vendors like Quora (Poe uses Claude and GPT-4).

Developer community and support: OpenAI has the largest community usage so far, given ChatGPT’s popularity – so GPT-4 might have the most third-party tutorials, libraries, and community help. Google’s developer relations for AI is ramping up with resources on AI.Google.dev for Gemini[92], and Anthropic is a bit newer in outreach but is actively expanding availability (recently they opened claude.ai globally for free users, which helps devs get familiar).

Zusammenfassend lässt sich sagen, dass Entwickler mit allen drei Optionen hervorragende Möglichkeiten haben: Wenn Sie maximale Kontrolle und möglicherweise das Selbsthosting kleinerer Modelle wünschen, ist Googles Gemma/Gemini-Ansatz attraktiv (offene kleinere Modelle + leistungsstarke API für großes Modell). Wenn Sie eine unkomplizierte API mit vielen vorgefertigten Funktionen bevorzugen, ist OpenAIs GPT-4 eine starke Wahl. Wenn Sie langen Kontext und ein sicheres Modell out-of-the-box priorisieren, ist Anthropics Claude 2.1 überzeugend. Keines dieser Modelle ist auf höchstem Niveau quelloffen (außer Googles kleinere Gemmas), daher sind Sie in allen Fällen auf den Anbieter für die großen Modelle angewiesen. Aber der Wettbewerb hat zu konvergierenden Funktionen geführt: jetzt haben alle drei eine Form von Tool-Use-API, alle unterstützen Systemanweisungen, alle bieten große Kontexte (100k+), und alle investieren in Sicherheits- und Zuverlässigkeitswerkzeuge.

Sicherheit und Ausrichtung

Die Sicherstellung, dass die Modelle hilfreich agieren und keine schädlichen Inhalte produzieren, ist ein Hauptfokus für alle drei Organisationen, die jeweils leicht unterschiedliche Ansätze verfolgen:

- Google Gemini (DeepMind): Google betont das „verantwortungsvolle Bauen in der agentischen Ära“[93]. DeepMind legt seit langem einen Fokus auf die Sicherheit von KI und hat bei Gemini die umfassendsten Sicherheitsbewertungen aller Google-KI-Modelle bisher durchgeführt[68]. Laut Google wurde Gemini auf Voreingenommenheit, Giftigkeit und Risikoszenarien wie Missbrauch in der Cybersicherheit und manipulative Beeinflussung getestet[69]. Es gibt interne Red Teams, die versuchten, Schwachstellen auszunutzen und bösartige Verwendungen zu testen, um Geminis Antworten zu verbessern. Google hat auch proaktive Schutzmaßnahmen in das Modell und die API integriert – zum Beispiel könnte das Gemini-Modell Anfragen ablehnen, die gegen die Inhaltsrichtlinie verstoßen (ähnlich wie ChatGPT oder Claude), insbesondere da es in benutzerorientierte Produkte integriert ist (sie können es sich nicht leisten, dass es unerlaubte Inhalte generiert). Da Gemini auch Werkzeuge verwenden und Code erzeugen kann, hat Google wahrscheinlich Einschränkungen eingeführt, um zu verhindern, dass es etwas Gefährliches tut, wenn es autonom agiert. Es gibt auch einen Aspekt des Reinforcement Learning mit menschlichem Feedback (RLHF), ähnlich wie bei OpenAI: menschliche Bewerter haben Geminis Antworten so angepasst, dass sie hilfreich und harmlos sind. Eine interessante Forschung von DeepMind war „Scalable Alignment via Constitutional AI“ und andere Techniken – es ist möglich, dass Google einige dieser Ideen übernommen oder zumindest studiert hat (DeepMinds frühere Arbeiten an Sparrow usw.). Google hat jedoch nicht öffentlich beschrieben, einen verfassungsähnlichen Ansatz zu verwenden; sie haben wahrscheinlich eine Mischung aus kuratierten hochwertigen Daten und menschlichem Feedback genutzt. In der Praxis haben frühe Nutzer festgestellt, dass Gemini höflich ist und unangemessene Anfragen normalerweise ablehnt, im Einklang mit den KI-Prinzipien von Google[68]. Es könnte etwas nachgiebiger sein als GPT‑4 bei grenzwertigen Inhalten, laut einigen anekdotischen Tests, bleibt aber generell im sicheren Bereich. Google hat auch einen Secure AI Framework (SAIF) und ein Responsible AI Toolkit[87] für Entwickler, die Gemini nutzen, eingeführt, um potenzielle Probleme wie sensible Daten in Eingabeaufforderungen oder voreingenommene Ausgaben zu identifizieren und zu mindern.

- OpenAI GPT‑4: Die Ausrichtung von GPT-4 war ein wesentlicher Bestandteil seiner Entwicklung. OpenAI nutzte RLHF intensiv, plus eine abschließende Verfeinerung mit „modellunterstützter Optimierung“, bei der sie auch KI-Bewerter einsetzten. Sie veröffentlichten auch eine GPT-4 Systemkarte, die detailliert beschreibt, wie sie auf Missbrauch getestet haben (z. B. ob GPT-4 gefährliche Anweisungen geben könnte usw.). GPT-4 gilt allgemein als sehr sicher und kontrollierbar – es lehnt es ab, Anfragen zu Gewalt, Hass, sexuellem Missbrauch, illegalem Verhalten usw. nachzukommen, mit den vertrauten Nachrichten „Es tut mir leid, ich kann dabei nicht helfen“. Kein Modell ist jedoch perfekt: clevere Prompt-Ingenieure und Hacker haben gelegentlich Wege gefunden, die Beschränkungen zu umgehen. OpenAI aktualisiert das Modell kontinuierlich, um diese Lücken zu schließen. Die Ausrichtung von GPT‑4 frustriert manchmal die Nutzer (zum Beispiel könnte es harmlose Anfragen aufgrund konservativer Abstimmung ablehnen oder zu oft entschuldigen), aber es hat sich im Laufe der Zeit verbessert. Die Systemnachricht in der API von OpenAI ermöglicht es Entwicklern, organisatorische Richtlinien oder gewünschte Personas einzufügen, die GPT-4 zu befolgen versucht, was eine gewisse Flexibilität in Ton und Rolle bietet. Zum Beispiel kann man GPT-4 anweisen, ein knapper Assistent zu sein oder einen bestimmten Stil zu übernehmen, solange dies nicht den Kernrichtlinien widerspricht. OpenAI bietet auch eine Option namens „OpenAI Moderation API“, um Benutzereingaben/-ausgaben auf unerlaubte Inhalte vorzusortieren. In Bezug auf Ehrlichkeit ist GPT-4 faktenorientierter als seine Vorgänger, kann aber immer noch selbstsicher halluzinieren. OpenAI berichtete, dass GPT-4 eine fast 40% niedrigere Halluzinationsrate bei bestimmten Tests im Vergleich zu GPT-3.5 hat, aber es wird immer noch gelegentlich Referenzen oder Code erfinden, die korrekt erscheinen, es jedoch nicht sind. Das ist eine offene Herausforderung für alle Modelle.

- Anthropic Claude 2/2.1: Der Ansatz von Anthropic ist Constitutional AI (CAI) – sie geben der KI einen Satz schriftlicher Prinzipien (eine „Verfassung“) und lassen sie ihre Ausgaben selbst kritisieren und überarbeiten, um diesen Prinzipien zu entsprechen. Die Idee ist, die Werte des Modells anzugleichen, ohne so viel menschliches Feedback für jedes Beispiel zu benötigen. Claudes Verfassung beinhaltet Dinge wie „wähle die Antwort, die am hilfreichsten und harmlosesten ist“ und beruft sich auf Ideale aus Quellen wie der UN-Menschenrechtserklärung. In praktischen Begriffen meidet Claude es, schädliche oder voreingenommene Inhalte zu erzeugen – er lehnt Anfragen elegant ab, indem er Prinzipien anführt („Es tut mir leid, aber ich kann bei dieser Anfrage nicht helfen“). Nutzer bemerken oft, dass Claude einen freundlichen, etwas wortreichen Ablehnungsstil hat und versucht, seine Argumentation zu erklären. Mit Claude 2.1 zielte Anthropic speziell auf Halluzinationen ab und machte Fortschritte: sie berichten von einer 2-fachen Reduzierung falscher Aussagen im Vergleich zu Claude 2.0[70] und dass Claude 2.1 häufiger Unsicherheit zugibt, anstatt zu raten[71]. Sie erzielten auch eine 30%ige Reduzierung falscher Antworten bei kniffligen faktischen Aufgaben und einen großen Rückgang bei Fällen, in denen Claude die Informationen eines Dokuments falsch interpretierte[94][95]. Diese Änderungen sind Teil von Anthropics Ethos, eine ehrliche und harmlose KI zu schaffen. Aufgrund von CAI nimmt Claude manchmal eine neutralere oder unverbindlichere Haltung zu kontroversen Themen ein und fügt häufig Einschränkungen hinzu wie „Ich bin nur eine KI, aber…“, was einige Nutzer als vorsichtig empfinden. Ein potenzieller Nachteil ist, dass Claude historisch leichter mit Rollenspielszenarien auszutricksen war, obwohl er mit 2.1 strenger geworden ist. Die Einführung von System-Prompts in 2.1 ermöglicht es Entwicklern, Claudes „Verfassung“ in Echtzeit anzupassen (zum Beispiel könnte man betonen, dass es einer Unternehmenspolitik folgen sollte).

In Bezug auf welches Modell „am sichersten“ ist, ist es schwer zu quantifizieren, ohne den Kontext zu kennen. Alle drei gelten als Spitzenmodelle in Bezug auf die Ausrichtung zu ihren jeweiligen Veröffentlichungszeiten. Anekdotisch hat Claude den Ruf, sehr resistent gegen Ablehnungen bei harmlosen Inhalten zu sein – das bedeutet, dass es normalerweise nur dann ablehnt, wenn es wirklich notwendig ist. GPT-4 kann manchmal vorsichtiger sein (zum Beispiel erfordert es eine sorgfältige Umschreibung, wenn ein Nutzerhinweis auch nur andeutet, dass etwas gegen die Richtlinien verstößt). Geminis Ausrichtung wird noch von der Gemeinschaft beobachtet; es scheint eine Balance ähnlich wie GPT-4 zu finden (streng bei nicht erlaubten Inhalten, aber nicht übermäßig eifrig, neutrale Anfragen abzulehnen). DeepMinds Erfahrung in der Sicherheit des Verstärkungslernens (sie erwähnen Forschung zu „Red-Teaming“ für Überzeugung usw.[68]) hat wahrscheinlich zu einem robusten Sicherheitstraining für Gemini beigetragen. Da Gemini auch Bilder ausgeben kann, muss Google sicherstellen, dass es auch dort Regeln befolgt (z. B. keine expliziten oder urheberrechtlich geschützten Bilder generieren), was eine weitere Sicherheitsebene hinzufügt.

Schließlich sind alle drei Unternehmen der kontinuierlichen Verbesserung verpflichtet. Sie veröffentlichen regelmäßig Updates (OpenAIs GPT-4 wurde mit den ChatGPT-Updates sicherer, Anthropics Claude verbesserte sich in Version 2.1, und Google wird Gemini zweifellos mit Feedback aktualisieren). Für einen Entwickler oder eine Organisation könnte Claude ansprechend sein, wenn Sicherheit die absolute Priorität ist, da es einen doppelten Fokus auf Unschädlichkeit und Ehrlichkeit legt. GPT-4 ist dicht dahinter, mit viel Kontrolle und vielen Sicherheitsfunktionen (plus der Unterstützung der Compliance-Standards und Überwachung von OpenAI). Gemini ist wahrscheinlich auch sehr sicher (Google hat viel zu verlieren, wenn es durch seine Dienste schädliche Ausgaben produziert); es bietet neue Funktionen wie die Bildgenerierung, die durch separate Richtlinien geregelt sind (zum Beispiel wird es keine gewalttätigen oder erwachsenen Bilder produzieren – vermutlich ähnlich wie bei der Filterung von Imagen).

Zusammenfassend sind alle drei Modelle stark ausgerichtet und relativ sicher für den allgemeinen Gebrauch, mit kleinen Unterschieden in der Philosophie: OpenAI und Google verwenden hauptsächlich RLHF mit menschlichem Feedback (plus etwas KI-Feedback), während Anthropic mehr auf KI-Selbstregulierung durch eine Verfassung setzt. Benutzer könnten feststellen, dass GPT-4 und Gemini bei Ablehnungen etwas knapper reagieren, während Claude aufgrund seiner Prinzipien möglicherweise einen höflicheren Mini-Aufsatz liefert. In Bezug auf die faktische Genauigkeit haben GPT-4 und Gemini leichte Vorteile in Benchmarks, aber die Verbesserungen von Claude 2.1 haben die Lücke bei der Reduzierung von Halluzinationen verringert[70][94]. Die beste Praxis bleibt, Überprüfungen durchzuführen und sich nicht blind auf die Ausgabe eines einzelnen Modells für kritische Anwendungen zu verlassen.

Fazit

Googles Gemini 3, OpenAIs GPT‑4 (Turbo) und Anthropics Claude 2.1 repräsentieren die Spitze der KI-Modelle im Jahr 2025. Gemini 3 tritt als ernstzunehmender Herausforderer von GPT‑4 auf, mit state-of-the-art Leistung in vielen Bereichen, mehr unterstützten Modalitäten und einer beispiellosen Kontextlänge, die völlig neue Anwendungsfälle ermöglicht. GPT‑4 bleibt ein Goldstandard für Zuverlässigkeit, mit exzellentem logischen Denken und einem umfangreichen Entwickler-Ökosystem, jetzt verstärkt durch visuelle Eingaben und einem 128K-Kontext. Claude 2.1 bietet eine überzeugende Mischung aus Fähigkeiten – sehr starke Sprach- und Programmierkenntnisse, das größte zugängliche Kontextfenster (200K) und ein sicherheitsorientiertes Design, das Unternehmen anspricht.

Die Wahl zwischen ihnen hängt von der Anwendung ab: Wenn Sie multimodales Verständnis oder Bildgenerierung mit Text integriert benötigen, ist Gemini 3 der klare Gewinner. Wenn Sie das absolut beste analytische Textmodell mit vielen Integrationen benötigen und keine Probleme mit Ratenbegrenzungen haben, ist GPT‑4 eine bewährte Wahl. Wenn Sie lange Dokumente analysieren müssen oder ein Modell wünschen, das auf hohe Transparenz abgestimmt ist und weniger wahrscheinlich Halluzinationen erzeugt, ist Claude 2.1 ausgezeichnet.

Eines ist sicher – der Wettbewerb zwischen diesen Modellen treibt schnelle Fortschritte voran. Alle drei verbessern sich ständig, und die Unterschiede könnten bei jedem Update geringer werden. Derzeit haben wir ihre Unterschiede in Architektur, Argumentationsstärke, Programmierfähigkeiten, Multimodalität, Geschwindigkeit, Kontextverarbeitung, Entwickler-Tools und Ausrichtung detailliert beschrieben. Durch die Nutzung glaubwürdiger Benchmarks und Quellen hoffen wir, dass dieser umfassende Vergleich Entwicklern und Technikbegeisterten hilft, zu verstehen, wo diese hochmodernen KI-Modelle im Vergleich zueinander stehen[72][27][96].

Empfohlene SEO-optimierte Blog-Titel

Wenn Sie schließlich in Erwägung ziehen, einen Blogbeitrag zu diesem Thema zu schreiben, sind hier einige SEO-freundliche Titelideen, die relevante Keywords ansprechen und sowohl Entwickler als auch allgemeine Technikleser ansprechen:

- „Google Gemini 3 vs OpenAI GPT-4 vs Anthropic Claude 2: Der ultimative Vergleich der KI-Modelle (2025)” – Ein einprägsamer Titel, der den direkten Vergleich und das aktuelle Jahr hervorhebt und wahrscheinlich diejenigen anzieht, die nach Vergleichen dieser KI-Modelle suchen.

- „Gemini 3 vs GPT-4 vs Claude 2 – Welches Next-Gen-KI-Modell führt in Codierung, Logik & Multimodaler KI?” – Betont die wichtigsten Vergleichspunkte (Codierung, Logik, multimodal) und verwendet die Modellnamen für SEO, was für Entwickler attraktiv ist, die technische Stärken bewerten.

- „Google’s Gemini 3 vs OpenAI GPT-4: Benchmark-Ergebnisse und Hauptunterschiede in 2025” – Fokussiert sich auf Benchmarks und Unterschiede und nutzt Organisationsnamen (Google, OpenAI) sowie Modellnamen für hochwertige Schlüsselwörter.

Jeder dieser Titel enthält beliebte Suchbegriffe (Gemini 3, GPT-4, Claude 2, KI-Modellvergleich) und verspricht eine klare Analyse, die helfen sollte, gut zu ranken und Leser anzuziehen, die an KI-Modellvergleichen und -fähigkeiten interessiert sind.

Quellen: Die Informationen in diesem Vergleich basieren auf offiziellen Quellen: Googles Ankündigungen und technischem Bericht für Gemini[72][1], OpenAIs GPT-4-Dokumentation[16], Anthropics Claude-Modellkarte und Aktualisierungshinweise[50][17], sowie auf weiteren zitierten Forschungs- und Benchmark-Ergebnissen in diesem Artikel. Alle Benchmarks und Aussagen wurden aus glaubwürdigen Quellen zur Verifizierung zitiert.

[1] [2] [11] [14] [15] [46] storage.googleapis.com

https://storage.googleapis.com/deepmind-media/gemini/gemini_v2_5_report.pdf

[3] [4] [5] [7] [8] [20] [24] [29] [30] [39] [40] [41] [49] [52] [68] [69] [72] [77] [78] [82] Einführung von Gemini: Googles bisher leistungsfähigstes KI-Modell

https://blog.google/technology/ai/google-gemini-ai/

[6] [31] [32] [33] [34] [35] [37] [38] [42] [43] [44] [45] [51] [55] [66] [73] [74] [79] [80] [83] [84] [86] [93] Gemini - Google DeepMind

https://deepmind.google/models/gemini/

[9] [10] [13] [63] [64] [87] [92] Gemma 3 Modellkarte | Google KI für Entwickler

https://ai.google.dev/gemma/docs/core/model_card_3

[12] [16] [56] [60] [67] [88] Neue Modelle und Entwicklerprodukte auf dem DevDay angekündigt | OpenAI

https://openai.com/index/new-models-and-developer-products-announced-at-devday/

[17] [18] [59] [61] [62] [65] [70] [71] [75] [81] [85] [91] [94] [95] Einführung von Claude 2.1 \ Anthropic

https://www.anthropic.com/news/claude-2-1

[19] [21] [22] [23] [25] [26] [27] [28] [48] [54] [57] [58] [76] Gemini - Google DeepMind

https://nabinkhair42.github.io/gemini-ui-clone/

[36] Gerüchte über Google Gemini 3 Pro: Erscheinungsdatum, Funktionen und was man Ende 2025 erwarten kann

[47] [50] [53] [96] anthropic.com

https://www.anthropic.com/claude-2-model-card

[89] Zugriff auf GPT-4 Finetuning - API - OpenAI Entwickler-Community

https://community.openai.com/t/access-to-gpt-4-finetuning/555372

[90] Das Claude 2.1 Foundation-Modell von Anthropic ist nun allgemein ...