लेखक: Boxu Li

परिचय: LLMs के लिए दृष्टि एक संपीड़न परत के रूप में

लंबे संदर्भ प्रसंस्करण लंबे समय से भाषा मॉडलों के लिए एक चुनौती रहा है - अगर आप एक ट्रांसफार्मर को 100K-टोकन दस्तावेज देंगे, तो आप विलंबता, मेमोरी फटने, या निषेधात्मक API लागतों का सामना करेंगे। पारंपरिक घने बड़े भाषा मॉडल (LLMs) को पुस्तक-लंबाई के इनपुट को कुशलता से संभालने के लिए डिज़ाइन नहीं किया गया था। यहाँ आता है DeepSeek-OCR 3B, एक नया ओपन-सोर्स मिश्रण-ऑफ-एक्सपर्ट्स (MoE) मॉडल जो एक बिल्कुल अलग दृष्टिकोण अपनाता है: यह दृश्य धारणा का उपयोग करता है टेक्स्ट के लिए एक संपीड़न माध्यम के रूप में[1][2]। हजारों टेक्स्ट टोकन को सीधे ग्रहण करने के बजाय, DeepSeek पृष्ठों को छवियों में परिवर्तित करता है और एक दृष्टि-भाषा पाइपलाइन के माध्यम से टेक्स्ट को पुनर्निर्माण करता है। इस तकनीक को संदर्भ ऑप्टिकल संपीड़न कहा जाता है, जो मॉडल को बहुत कम टोकनों में बहुत अधिक जानकारी भरने देता है[2][3]। DeepSeek-OCR 7–20× टोकन कमी के साथ न्यूनतम सटीकता हानि का वादा करता है[4][5], जिससे मानक हार्डवेयर पर स्केलेबल अल्ट्रा-लंबे दस्तावेज़ पार्सिंग संभव हो सके। महत्वपूर्ण रूप से, मॉडल पूरी तरह से ओपन-सोर्स है (Hugging Face और GitHub पर जारी किया गया) एक उदार लाइसेंस के तहत, जिससे उन्नत OCR क्षमताएँ सभी के लिए सुलभ हो जाती हैं[6][7]। इस पोस्ट में, हम DeepSeek-OCR की वास्तुकला और प्रशिक्षण का विश्लेषण करेंगे, इसे पारंपरिक घने LLMs और बंद-स्रोत OCR सेवाओं से तुलना करेंगे, और इसके रिलीज़ का डेवलपर्स और उद्योग के ओपन-सोर्स मार्ग के लिए क्या मतलब है, इसका पता लगाएंगे।

आर्किटेक्चर का विश्लेषण: MoE डिकोडर और विज़न एनकोडर का मिलन

दो-चरण दृष्टि-भाषा डिज़ाइन। दीपसीक-ओसीआर को एक दो-भाग प्रणाली के रूप में बनाया गया है: एक दृश्य एन्कोडर जिसे दीपएन्कोडर कहा जाता है और एक पाठ डिकोडर जिसे दीपसीक-3B-MoE-A570M कहा जाता है[8]। दीपएन्कोडर (≈380M पैरामीटर) एक दस्तावेज़ पृष्ठ की छवि को ग्रहण करता है और “दृष्टि टोकन” का एक कॉम्पैक्ट अनुक्रम उत्पन्न करता है। ये टोकन फिर दीपसीक-3B-MoE डिकोडर में प्रवेश करते हैं, जो पाठ सामग्री उत्पन्न करता है। यह विभाजन एक पारंपरिक घनी LLM के विपरीत है (जो पाठ इनपुट को अंत-टू-एंड प्रोसेस करेगा) – यहाँ पृष्ठ लेआउट और दृश्य पाठ को समझने का भारी काम एन्कोडर द्वारा किया जाता है, जो डिकोडर को एक बहुत छोटे अनुक्रम पर काम करने की अनुमति देता है[2][3]।

विजन एन्कोडिंग के माध्यम से संपीड़न। एन्कोडर वह जगह है जहां अधिकांश नवाचार निहित है। इसे उच्च-रिज़ॉल्यूशन पृष्ठों को कुशलतापूर्वक संभालने और एक क्रम या उससे अधिक के आकार में संपीड़ित करने के लिए डिज़ाइन किया गया है। कैसे? डीपनकोडर कई घटकों को जोड़ता है: (1) सूक्ष्म धारणा के लिए SAM-बेस (सेगमेंट एनीथिंग मॉडल) पर आधारित एक स्थानीय विजन मॉड्यूल, जो छोटी क्षेत्रों को स्कैन करने के लिए विंडोड ध्यान का उपयोग करता है[9]; (2) एक 16× कन्वोल्यूशनल डाउनसैंपलर जो छवि टोकनों की संख्या को बड़े पैमाने पर कम करता है (जैसे 4096 पैच टोकन को 256 तक)[10]; और (3) घनी ध्यान के साथ समग्र छवि समझ के लिए CLIP-लार्ज पर आधारित एक वैश्विक विजन मॉड्यूल[11]। व्यवहार में, पूरे 1024×1024 दस्तावेज़ छवि को 256 लेटेंट टोकनों के रूप में एन्कोड किया जा सकता है बिना अधिकांश पाठीय जानकारी खोए[12]। विजन टोकन की गिनती को कम रखते हुए (विभिन्न मोड में 64–400 टोकन), डीपसीक उस चतुर्भुज लागत विस्फोट से बचता है जो उच्च-रेज छवियों पर एक सरल विजन ट्रांसफार्मर झेल सकता है[13]। इसका मतलब है कि यहां तक कि पिक्सेल-घने पृष्ठों के लिए भी सक्रियण मेमोरी नियंत्रण में रहती है[14]।

Mixture-of-Experts डिकोडर बनाम Dense LLMs। डिकोडर, DeepSeek-3B-MoE, एक 3 बिलियन-पैरामीटर Mixture-of-Experts ट्रांसफार्मर है[8]। पारंपरिक डेंस LLM से अलग, जहां हर टोकन के लिए सभी वेट सक्रिय होते हैं, एक MoE मॉडल में कई विशेषज्ञ सबनेटवर्क होते हैं और प्रत्येक इनपुट के लिए केवल कुछ को सक्रिय करता है। DeepSeek के मामले में, 64 विशेषज्ञ सब-मॉडल हैं, जिनमें से प्रति टोकन 6 विशेषज्ञ सक्रिय होते हैं डिकोडिंग के समय[15]। इसका परिणाम प्रति टोकन लगभग 570 मिलियन पैरामीटर “सक्रिय” होते हैं – प्रभावी रूप से मॉडल इनफेरेंस समय पर 570M-पैरामीटर मॉडल की तरह व्यवहार करता है, जबकि इसकी कुल क्षमता 3B है[16]। प्रत्येक टोकन को विशेषज्ञों के एक उपसमुच्चय में मार्गदर्शित करके, मॉडल कुल पैरामीटर को बढ़ा सकता है बिना कंप्यूट लागत में समानुपाती वृद्धि के[17]। पारंपरिक डेंस LLMs में, यदि आपको अधिक क्षमता चाहिए, तो आप पैरामीटर की संख्या बढ़ाकर उनके लिए हर बार पूरी कंप्यूट लागत चुकानी होती है। MoE इसको दरकिनार करता है: DeepSeek का डिकोडर विशेष विशेषज्ञों में टैप कर सकता है (उदाहरण के लिए, शायद कुछ विशेषज्ञ गणित सूत्रों में विशेषज्ञ होते हैं, अन्य तालिका डेटा में, आदि) लेकिन केवल प्रासंगिक लोग ही दिए गए टोकन के लिए सक्रिय होते हैं। परिणामस्वरूप, एक डिकोडर जो चलाने में हल्का और ज्ञान में समृद्ध होता है। मूल रूप से, DeepSeek-3B-MoE एक बड़े मॉडल की शक्ति पैक करता है जबकि छोटे मॉडल की गति बनाए रखता है[15]। यह पारंपरिक डेंस OCR मॉडलों और LLMs से एक महत्वपूर्ण अंतर है, जिनमें यह शर्तीय गणना लाभ नहीं होता। यह ध्यान देने योग्य है कि Google के Switch Transformers और GLaM ने पहले MoE की प्रभावकारिता को साबित किया था, लेकिन DeepSeek उस शक्ति को एक ओपन-सोर्स विजन-भाषा प्रणाली में लाता है।

चित्र: DeepSeek-OCR की दो-स्तरीय संरचना एक इनपुट दस्तावेज़ छवि को DeepEncoder द्वारा बहुत कम टोकनों में संपीडित करती है, फिर Mixture-of-Experts डिकोडर के माध्यम से समृद्ध संरचित आउटपुट को पुनर्निर्मित करती है। इस उदाहरण में, मॉडल से एक चीनी ज्यामिति समस्या PDF को Markdown में बदलने के लिए कहा गया है: यह न केवल टेक्स्ट को निकालता है बल्कि एक आरेख को संपूर्ण निर्देशांक और LaTeX में बदल देता है, साधारण OCR से परे समझ का प्रदर्शन करता है।[18][19]

मल्टी-रेज़ोल्यूशन “गुंडम” मोड्स। डीपसीक के डिज़ाइन का एक उपन्यास पहलू इसके कॉन्फ़िगर करने योग्य रेज़ोल्यूशन मोड्स हैं, जिन्हें मज़ाक में टिनी, स्मॉल, बेस, लार्ज, और गुंडम कहा जाता है। ये मोड्स डेवलपर्स को अपनी आवश्यकताओं के अनुसार विस्तार बनाम टोकन गणना में अदला-बदली करने की अनुमति देते हैं[20]। उदाहरण के लिए, टिनी मोड 512×512 इमेज को केवल 64 टोकन में प्रोसेस करता है (त्वरित, कम-विस्तार स्कैन के लिए उपयोगी), जबकि लार्ज मोड 1280×1280 को अधिकतम विस्तार के लिए 400 टोकन के साथ संभालता है[21]। गुंडम मोड्स इससे भी आगे जाते हैं – वे पेज को कई स्थानीय दृश्य और एक वैश्विक दृश्य में विभाजित करते हैं, उदाहरण के लिए, n स्थानीय 640×640 क्रॉप्स (प्रत्येक 100 टोकन) के साथ एक फुल-पेज ओवरव्यू (256 या 400 टोकन) को मिलाकर [22]। यह डायनामिक टाइलिंग सुनिश्चित करती है कि यहां तक कि बहुत जटिल या ओवरसाइज़ पेज को भी प्रोसेस किया जा सकता है, उन्हें विभाजित करके, जबकि मॉडल को एक वैश्विक संदर्भ देती है। यह InternVL 2.0 और अन्य तकनीकों की गूंज है, जो यहां घने दस्तावेज़ों पर उच्च सटीकता बनाए रखने के लिए अनुकूलित है[23]। स्पष्ट टोकन बजट और इमेज आकारों को प्रकट करके, डीपसीक-ओसीआर मूल रूप से इंजीनियरों को एक डायल देता है: गति या सटीकता के लिए अनुकूलित करें यह समायोजित करके कि एन्कोडर कितना दृश्य विस्तार बनाए रखता है[24][25]। पारंपरिक ओसीआर पाइपलाइन्स यह सूक्ष्मता नहीं देतीं – यह मॉडल को विभिन्न कंप्यूट सीमाओं के तहत व्यावहारिक बनाने के लिए एक चतुर इंजीनियरिंग कदम है।

प्रशिक्षण और ओसीआर एकीकरण: कैसे दृष्टि और पाठ एक साथ आते हैं

एक मॉडल बनाना जो वास्तव में छवियों को पाठ की तरह पढ़ता है एक सावधानीपूर्वक संगठित प्रशिक्षण प्रक्रिया की आवश्यकता थी। डीपसीक-ओसीआर का प्रशिक्षण एक मानक एलएलएम के प्रशिक्षण कार्यक्रम से काफी भिन्न था, क्योंकि इसे ओसीआर क्षमता को अंत-से-अंत तक एकीकृत करना था।

द्वि-चरण प्रशिक्षण योजना। शोधकर्ताओं ने एक दो-चरण प्रशिक्षण पाइपलाइन को अपनाया[26][27]। चरण 1 में, उन्होंने DeepEncoder को एक अगला-टोकन भविष्यवक्ता के रूप में अलग से जोड़े गए चित्र-पाठ डेटा पर प्रशिक्षित किया। मूल रूप से, एन्कोडर ने एक टोकन अनुक्रम का उत्पादन करना सीखा जिसे एक भाषा मॉडल उस चित्र का वर्णन करने के रूप में पहचान सके। इस चरण ने विशाल OCR-केंद्रित डेटासेट का उपयोग किया (नीचे विवरण), प्रभावी रूप से विज़न मॉड्यूल को पाठ टोकन के समान स्थान में पाठ की छवियों को एन्कोड करने के लिए सिखाया। एन्कोडर के सक्षम होने के बाद ही चरण 2 शुरू हुआ: पूरे एन्कोडर-डिकोडर सिस्टम का संयुक्त प्रशिक्षण[27]। चरण 2 के दौरान, मॉडल को छवि-दस्तावेज़ इनपुट (जिसमें डिकोडर को सही पाठ आउटपुट करना सीखना था) और नियमित पाठ इनपुट (अपनी भाषा कौशल को तेज रखने के लिए) के मिश्रण से खिलाया गया। यह दो-चरणीय दृष्टिकोण - पहले विज़न, फिर मल्टीमॉडल फाइन-ट्यूनिंग - सुनिश्चित करता है कि एन्कोडर में OCR कौशल गहराई से समाहित हो गए थे, इससे पहले कि डिकोडर को इसकी एम्बेडिंग से भाषा उत्पन्न करने के लिए कहा जाए।

विविध बहुउपयोगी प्रशिक्षण डेटा। डीपसीक के प्रशिक्षण डेटा की व्यापकता इसके मजबूत होने का एक प्रमुख कारण है। मॉडल कार्ड के अनुसार, टीम ने वास्तविक, सिंथेटिक और यहां तक कि केवल पाठ्य डेटा का मिश्रण तैयार किया।

- OCR 1.0 डेटासेट: 30 मिलियन पृष्ठों के वास्तविक दस्तावेज़ (स्कैन, पीडीएफ) 100+ भाषाओं को कवर करते हुए[28]। इस विशाल बहुभाषी कॉर्पस ने मॉडल को विभिन्न लिपियों और लेआउट्स का अनुभव कराया, अंग्रेजी इनवॉइस से लेकर अरबी समाचारपत्रों तक और चीनी किताबों तक। ऐसी विविधता महत्वपूर्ण है – कई OCR इंजन कुछ भाषाओं से आगे संघर्ष करते हैं, लेकिन DeepSeek को शुरू से ही बहुभाषी बनने के लिए प्रशिक्षित किया गया था।

- OCR 2.0 डेटा: एक सिंथेटिक डेटासेट जिसमें संरचित दस्तावेज़ शामिल हैं चार्ट्स, सूत्र, रासायनिक संरचनाएँ, तालिकाएँ, और आरेख[28]। ये संभवतः कंप्यूटर-जनित छवियाँ थीं जो ग्राउंड ट्रुथ टेक्स्ट के साथ जोड़ी गईं (उदाहरण के लिए, एक रेंडर्ड गणितीय समीकरण छवि के साथ LaTeX के रूप में टेक्स्ट)। इसे शामिल करके, मॉडल ने उस सामग्री को संभालने के लिए सीखा जिसे पारंपरिक OCR अक्सर नज़रअंदाज़ करता है या असफल रहता है – जैसे कि प्लॉट्स पढ़ना और अंतर्निहित डेटा या समीकरण आउटपुट करना। उदाहरण के लिए, DeepSeek एक रासायनिक आरेख की व्याख्या कर सकता है और SMILES फॉर्मूला आउटपुट कर सकता है या एक बार चार्ट छवि को CSV/HTML तालिका में बदल सकता है, ऐसे कार्य जो केवल 'मुद्रित पाठ पढ़ने' से परे हैं। यह DeepSeek को संरचित दस्तावेज़ समझने में एक अनूठा लाभ देता है।

- सामान्य दृष्टि डेटा (20%): LAION (100M नमूने) जैसे डेटासेट से मानक छवियाँ शामिल की गईं[29]। उद्देश्य था कि मॉडल संकीर्ण न बने – यह सामान्य दृष्टि-भाषा आधारित ग्राउंडिंग को बरकरार रखता है, ताकि यह, उदाहरण के लिए, एक छवि को कैप्शन कर सके या वस्तुओं को पहचान सके। परिणामस्वरूप, DeepSeek-OCR छवियों का वर्णन कर सकता है या दृश्य तत्वों को पहचान सकता है यदि संकेत दिया जाए (एक साधारण दृष्टि AI के समान), जो शुद्ध OCR उपकरण नहीं कर सकते।

- शुद्ध पाठ डेटा (10%): प्रशिक्षण का एक छोटा हिस्सा केवल पाठ डेटा था[28]। यह डिकोडर की प्रवाहमय भाषा उत्पादन क्षमता को बनाए रखने के लिए था। क्योंकि अंततः, छवि 'पढ़ने' के बाद, मॉडल को सुसंगत पाठ आउटपुट करना होता है। कुछ पाठ कॉर्पस को शामिल करने से डिकोडर को केवल सटीक OCR को प्रतिध्वनित करने के लिए ओवरफिट नहीं होता है और इसके बजाय यह एक सक्षम भाषा मॉडल बना रहता है (उदाहरण के लिए, यह टेक्स्ट को पुन: स्वरूपित कर सकता है, सारांशित कर सकता है, या अनुवाद कर सकता है अगर पूछा जाए)।

डेटा के इस मिश्रण ने सुनिश्चित किया कि ओसीआर क्षमता गहराई से एकीकृत है: डीपसीक केवल इमेज प्रीप्रोसेसिंग और तैयार एलएलएम नहीं कर रहा है, बल्कि इसे अंत-से-अंत दृश्य पाठ समझने के लिए संयुक्त रूप से प्रशिक्षित किया गया था। यह छवियों से पाठ को उल्लेखनीय सटीकता के साथ पुनर्निर्मित करता है - मानक बेंचमार्क पर ~10× संपीड़न पर 97% सटीक मिलान दर [30][31]। और विविध प्रशिक्षण के कारण, यह केवल सरल टाइप किए गए पाठ के लिए ही नहीं, बल्कि जटिल लेआउट और एम्बेडेड दृश्य के लिए भी करता है। प्रभाव में, प्रशिक्षण ने डीपसीक-ओसीआर को एक ओसीआर सिस्टम, एक लेआउट विश्लेषक और एक भाषा मॉडल का संकर बना दिया।

स्केल और कंप्यूट। डीपसीक का प्रशिक्षण एक गंभीर कंप्यूट प्रयास था, जो एक आधुनिक LLM के प्रशिक्षण के समान था। टीम ने 8×A100 (40GB) जीपीयू के साथ 20 नोड्स का उपयोग किया – कुल 160 A100 जीपीयू[29] । प्रभावी पाइपलाइन पैरेललिज़म के कारण, उन्होंने टेक्स्ट-केवल डेटा पर 90B टोकन प्रति दिन और मल्टीमॉडल डेटा पर 70B टोकन प्रति दिन की तेज़ दर प्राप्त की[29]। प्रशिक्षण के दौरान, यह संभवतः कई ट्रिलियन टोकनों को संसाधित करता है। इस तरह का पैमाना एक कारण है कि मॉडल इतनी अच्छी तरह से प्रदर्शन करता है, भले ही यह प्रभावी रूप से ~570M सक्रिय पैरामीटर है; उन्होंने इसे विभिन्न प्रकार के उदाहरणों के सामने प्रस्तुत किया। प्रशिक्षण अनुकूलन (AdamW ऑप्टिमाइज़र, बैच साइज 640, LR ~3e-5[32]) को इस विशाल डेटा प्रवाह को संभालने के लिए ट्यून किया गया था। अंतिम परिणाम को 3B MoE मॉडल के लिए एकल ~6.7 GB सेफटेंसर्स फ़ाइल में पैक किया गया – एकल उच्च-अंत जीपीयू पर चलाने के लिए पर्याप्त छोटा[33]। यह स्वामित्व वाले OCR मॉडल या विशाल डेंस LLMs से बहुत अलग है, जिन्हें क्लस्टर्स की आवश्यकता हो सकती है या जिन्हें स्वयं होस्ट नहीं किया जा सकता है। डीपसीक की प्रभावी प्रशिक्षण पाइपलाइन दिखाती है कि सही आर्किटेक्चर (MoE + विज़न कंप्रेशन) के साथ, आप एक विशाल मॉडल के बिना भी बड़ी सटीकता हासिल कर सकते हैं।

ओपन-सोर्स लाइसेंस और डेवलपर अपनाना

DeepSeek-OCR 3B का सबसे महत्वपूर्ण पहलू इसका पूरी तरह से ओपन-सोर्स रिलीज़ है। मॉडल के वज़न और कोड दोनों को MIT लाइसेंस के तहत उपलब्ध कराया गया है[34], जो सॉफ़्टवेयर में सबसे उदार लाइसेंसों में से एक है। डेवलपर्स और संगठनों के लिए, इसके बड़े प्रभाव हैं:

- व्यापक उपयोग अधिकार: MIT लाइसेंस का मतलब है कि आप मॉडल का वाणिज्यिक या निजी रूप से न्यूनतम प्रतिबंधों के साथ उपयोग कर सकते हैं – मूल रूप से “कुछ भी चलेगा” जब तक आप लाइसेंस नोटिस शामिल करते हैं। यह कई “खुले” मॉडल से बहुत अलग है जो गैर-वाणिज्यिक धाराएँ रखते हैं या विशेष अनुमतियों की आवश्यकता होती है। दूसरे शब्दों में, स्टार्टअप्स और उद्यम दीपसीक-OCR को उत्पादों (यहां तक कि बंद-स्रोत उत्पादों) में एकीकृत कर सकते हैं, बिना कानूनी बाधाओं के। यह सचमुच खुला नवाचार है।

- पारदर्शिता और भरोसा: हगिंग फेस पर वज़न और गिटहब पर कोड के साथ कुछ भी ब्लैक बॉक्स नहीं है। डेवलपर्स देख सकते हैं कि मॉडल कैसे काम करता है, आर्किटेक्चर की पुष्टि कर सकते हैं, और यहां तक कि अपनी जरूरतों के लिए इसे ऑडिट या फाइनट्यून भी कर सकते हैं। यह पारदर्शिता विश्वास बनाती है – उदाहरण के लिए, यदि आप संवेदनशील दस्तावेजों को संसाधित कर रहे हैं, तो आप एक खुले मॉडल को पसंद कर सकते हैं जिसे आप पूरी तरह से ऑन-प्रिमाइसिस चला सकते हैं बजाय इसके कि डेटा को किसी तृतीय-पक्ष API को भेजें।

- एकीकरण में आसानी: रिलीज में एक विस्तृत मॉडल कार्ड और उदाहरण उपयोग शामिल है। कुछ पंक्तियों के पायथन कोड के साथ (विशिष्ट मॉडल कोड की अनुमति देने के लिए हगिंग फेस ट्रांसफॉर्मर्स का उपयोग करके trust_remote_code=True), आप मॉडल को लोड कर सकते हैं और इंफरेंस चला सकते हैं[35][36]. दीपसीक टीम ने परीक्षण किए गए पर्यावरण विनिर्देश भी प्रदान किए हैं (Python 3.12, Torch 2.6, Transformers 4.46, FlashAttention 2.7, आदि) ताकि इंजीनियर सेटअप को विश्वसनीय रूप से पुनः उत्पन्न कर सकें[37]। यह अपनाने की बाधा को कम करता है – इसे आज़माने के लिए आपको AI शोधकर्ता होने की आवश्यकता नहीं है। यदि आपके पास एक दस्तावेज़ की छवि फ़ाइल और एक अच्छा GPU है, तो आप मिनटों में परिणाम प्राप्त कर सकते हैं।

- समुदाय और समर्थन: लॉन्च के बाद से, दीपसीक-OCR ने तेजी से ध्यान आकर्षित किया है। गिटहब रिपोजिटरी ने रिलीज के कुछ ही दिनों में हजारों स्टार्स (5k+ स्टार्स) प्राप्त किए[38], और मॉडल को हगिंग फेस पर हजारों बार डाउनलोड किया गया[39], जो एक जीवंत सामुदायिक रुचि को इंगित करता है। कई डेमो एप्लिकेशंस (स्पेसेस) हगिंग फेस पर पॉप अप हुए हैं जहां आप अपने ब्राउज़र में मॉडल का परीक्षण कर सकते हैं[40]। इस समुदाय की गति का मतलब है कि डेवलपर्स को संभवतः मदद, ट्यूटोरियल या अन्य लोगों द्वारा योगदान किए गए एक्सटेंशन मिल सकते हैं। इसका मतलब यह भी है कि मॉडल को विविध उपयोग मामलों के बीच परीक्षण किया जाएगा, बग्स को बाहर निकाला जाएगा और सुधारों को प्रेरित किया जाएगा।

- कस्टमाइज़ करने की स्वतंत्रता: शायद सबसे महत्वपूर्ण, खुले वज़न का मतलब है कि डेवलपर्स दीपसीक-OCR को फाइन-ट्यून या संशोधित कर सकते हैं। यदि आपकी कंपनी के पास एक विशेष OCR कार्य है (कहें, एक विशेष प्रकार की इंजीनियरिंग योजना या बहुत स्टाइलिश फॉन्ट पढ़ने के लिए), तो आप उस डोमेन में मॉडल को और प्रशिक्षित या अनुकूलित कर सकते हैं। बंद OCR API के साथ, आपके पास ऐसा कोई विकल्प नहीं है – आपको वही मिलता है जो प्रदाता प्रदान करता है। दीपसीक आर एंड डी टीमों को इसके ऊपर नवाचार करने का अधिकार देता है। हम जल्दी ही विशेष डेरिवेटिव्स देख सकते हैं – उदाहरण के लिए, कोई दीपसीक के एक संस्करण को ऐतिहासिक हस्तलिखित दस्तावेजों के लिए फाइन-ट्यून कर सकता है, या इसे एक बड़े पाइपलाइन में एकीकृत कर सकता है (ऐसे चैटबॉट्स जो PDF सामग्री के बारे में प्रश्नों का उत्तर दे सकते हैं, आदि)।

संक्षेप में, DeepSeek-OCR का ओपन-सोर्स MIT रिलीज़ अत्याधुनिक OCR के लिए लागत बाधा और पहुँच बाधा दोनों को हटा देता है। कोई भी डेवलपर जिसके पास GPU है, अपनी स्वयं की पर्यावरण में बिना किसी शुल्क के अत्याधुनिक विज़न-भाषा मॉडल को लागू कर सकता है। यह लोकतंत्रीकरण उस समय के समान है जब इमेज मॉडल जैसे Tesseract (ओपन-सोर्स OCR) या Stable Diffusion (ओपन-सोर्स इमेज जनरेशन) उपलब्ध हुए थे - सिवाय इसके कि DeepSeek की क्षमताएँ कहीं अधिक उन्नत हैं। इसका मतलब है कि छोटे स्टार्टअप्स या शोधकर्ता भी विश्व-स्तरीय OCR और दस्तावेज़ समझ को अपने प्रोजेक्ट्स में शामिल कर सकते हैं, जिससे सामूहिक योगदान के माध्यम से क्षेत्र में प्रगति हो सकती है।

DeepSeek-OCR की तुलना Google और Amazon के बंद OCR APIs से

यह ओपन मॉडल मौजूदा कंपनियों जैसे Google Cloud Vision OCR और Amazon Textract के मुकाबले कैसे खड़ा होता है? ये क्लाउड-आधारित OCR सेवाएँ एंटरप्राइज़ दस्तावेज़ प्रसंस्करण के लिए जानी जाती हैं, अपनी सटीकता और स्केलेबिलिटी के लिए प्रसिद्ध हैं। हालाँकि, DeepSeek-OCR का आगमन कुछ स्पष्ट अंतर को उजागर करता है जैसे क्षमता, पहुँच, लचीलापन, और नवाचार की गति:

- सटीकता और क्षमता: शुद्ध पाठ निकासी कार्यों पर, Google और Amazon के OCR इंजन अत्यधिक सटीक हैं, जो विशाल डेटा पर परिष्कृत किए गए हैं। DeepSeek-OCR इस क्षेत्र में प्रतिस्पर्धी (यहां तक कि अत्याधुनिक) परिणामों के साथ प्रवेश करता है, जैसे कि मानक OCR बेंचमार्क पर 97-98% सटीक पाठ मेल संतुलित संपीड़न स्तरों पर प्राप्त करता है। यह हाल के शैक्षिक OCR मॉडल (GOT-OCR 2.0, Mineru 2.0) को भी बेहतर प्रदर्शन करता है जबकि इससे बहुत कम टोकन का उपयोग करता है। व्यावहारिक रूप से, DeepSeek बड़ी क्लाउड APIs के साथ मुद्रित पाठ निकालने में टक्कर ले सकता है। लेकिन DeepSeek की क्षमताएं साधारण OCR से परे हैं। इसके बहुआयामी प्रशिक्षण के कारण, यह लेआउट को समझता है और एम्बेडेड सामग्री की व्याख्या कर सकता है। उदाहरण के लिए, यह एक वैज्ञानिक PDF पढ़ सकता है और न केवल अनुच्छेदों को लिप्यंतरित कर सकता है, बल्कि PDF में एक ग्राफ की व्याख्या भी कर सकता है - ग्राफ का डेटा आउटपुट करना या उसकी सामग्री को सारांशित करना। यह एक तालिका छवि को एक वास्तविक HTML या मार्कडाउन तालिका संरचना में परिवर्तित कर सकता है। यह एक दस्तावेज़ में गैर-पाठ्य तत्वों (आकृतियाँ, चित्र) का वर्णन भी कर सकता है यदि पूछा जाए। Google Vision या Textract जैसे बंद APIs आमतौर पर कुछ कार्यों के लिए विशेष होते हैं (पाठ पहचान, फ़ॉर्म डेटा निकासी, आदि) - वे पाठ निकाल सकते हैं और शायद बुनियादी लेआउट संरचना की पहचान कर सकते हैं, लेकिन वे रासायनिक आरेख का अर्थ नहीं लिखेंगे या चार्ट को कोड में परिवर्तित नहीं करेंगे। DeepSeek अधिक मानव पाठक की तरह काम करता है: यह लचीले प्रारूपों में आउटपुट उत्पन्न कर सकता है और मिश्रित सामग्री को संभाल सकता है। यह इसे केवल एक OCR टूल नहीं बनाता, बल्कि एक सामान्य दस्तावेज़ समझ मॉडल बनाता है। हालांकि, बंद सेवाओं की अपनी उन्नत विशेषताएँ होती हैं (उदाहरण के लिए, Textract सीधे आपको संरचित फ़ॉर्म फ़ील्ड दे सकता है, और Google का Document AI दस्तावेज़ प्रकारों को वर्गीकृत कर सकता है) - लेकिन वे संकीर्ण रूप से परिभाषित होते हैं। DeepSeek एक अधिक खुले-अंत क्षमता प्रदान करता है जहां आउटपुट वही होता है जो आप चाहते हैं ("इसे मार्कडाउन में परिवर्तित करें", "सभी नाम और ईमेल निकालें", "इस रिपोर्ट का सारांश बनाएं", आदि), इसके LLM प्रकृति का लाभ उठाते हुए।

- पहुँच और एकीकरण: एक प्रमुख अंतर कैसे आप उन्हें उपयोग करते हैं। Google और Amazon OCR क्लाउड सेवाएं हैं - आप उनकी API को छवियाँ (या PDF) भेजते हैं और परिणाम प्राप्त करते हैं। इसके फायदे और नुकसान हैं। फायदा है सुविधा: कोई ML विशेषज्ञता की जरूरत नहीं, और यह स्वतः स्केल करता है; एकीकरण एक साधारण REST API कॉल है। नुकसान यह है कि आपको अपनी संभावित संवेदनशील दस्तावेज़ों को बाहरी सर्वर पर भेजना होता है, और आप प्रति उपयोग भुगतान करते हैं। DeepSeek-OCR ओपन-सोर्स होने के कारण इस मॉडल को बदल देता है। आप मॉडल को डाउनलोड करते हैं और इसे अपने हार्डवेयर पर चलाते हैं। एकीकरण में थोड़ा अधिक काम लग सकता है (GPU पर्यावरण स्थापित करना, कोड में मॉडल को कॉल करना), लेकिन कोई बाहरी निर्भरता नहीं है - गोपनीयता और अनुपालन के लिए महत्वपूर्ण। उदाहरण के लिए, स्वास्थ्य सेवा या कानूनी फर्में अक्सर गोपनीय फ़ाइलों को तृतीय-पक्ष क्लाउड्स पर अपलोड करने में हिचकिचाती हैं; DeepSeek के साथ, वे डेटा को पूरी तरह से इन-हाउस रख सकते हैं। लागत के हिसाब से, यदि आपके पास दस्तावेज़ों की स्थिर मात्रा है, तो अपने मॉडल को चलाना लंबे समय में कहीं अधिक लागत प्रभावी हो सकता है। क्लाउड OCR APIs आमतौर पर प्रति 1,000 पृष्ठों की प्रक्रिया के लिए शुल्क लेते हैं। ये लागतें बढ़ जाती हैं, जबकि एक ओपन मॉडल आपको GPU या क्लाउड इंस्टेंस में एक बार का निवेश करने और फिर लाखों पृष्ठों को न्यूनतम लागत पर प्रोसेस करने देता है। संक्षेप में, DeepSeek तक पहुंच अनियंत्रित है - कोई दर सीमाएं नहीं, कोई शुल्क नहीं, और पर्यावरण पर पूर्ण नियंत्रण। व्यापार-बंद यह है कि आप बुनियादी ढांचे का प्रबंधन करते हैं, लेकिन कई के लिए, यह स्वतंत्रता के लिए स्वागत योग्य व्यापार है।

- लचीलापन और अनुकूलन: बंद-स्रोत OCR समाधान अनिवार्य रूप से स्थिर पेशकशें हैं। यदि वे गलती करते हैं या आपके डोमेन के लिए उपयुक्त नहीं होते (कहें, हस्तलिखित पढ़ने या विशेष शब्दावली), तो आपके पास पोस्ट-प्रोसेसिंग या प्रदाता के मॉडल को सुधारने की प्रतीक्षा करने के अलावा कोई विकल्प नहीं होता। एक ओपन मॉडल जैसे DeepSeek के साथ, आपके पास पूर्ण लचीलापन है। आप अपने डोमेन डेटा पर मॉडल को फाइन-ट्यून कर सकते हैं (उदाहरण के लिए, हस्तलिखित नमूनों या विशेष भाषा दस्तावेज़ों पर फाइनट्यून), ताकि यह विशेष रूप से आपकी आवश्यकता के अनुसार प्रदर्शन में सुधार कर सके। आप आउटपुट प्रारूप को प्रॉम्प्टिंग के माध्यम से अनुकूलित भी कर सकते हैं - उदाहरण के लिए, DeepSeek से JSON आउटपुट के लिए पूछें जिसमें कुछ फ़ील्ड निकाली गई हों, या स्वरूपण के लिए मार्कडाउन सिंटैक्स को संरक्षित करने के लिए कहें। मॉडल की LLM डीएनए का मतलब है कि यह OCR परिणामों को प्रस्तुत करने के लिए निर्देशों का पालन कर सकता है, कुछ ऐसा जो Google/Amazon APIs नहीं कर सकते (उनके पास पूर्वनिर्धारित आउटपुट स्कीमाएं होती हैं)। इसके अलावा, आप DeepSeek को मिश्रित वर्कफ़्लो में एकीकृत कर सकते हैं: शायद आप DeepSeek को एक ड्राफ्ट निकासी प्राप्त करने के लिए चलाते हैं, फिर उसे सत्यापन के लिए एक अन्य मॉडल में या मानव-इन-द-लूप सिस्टम में फीड करते हैं। बंद APIs के साथ, आप अक्सर उनके पाइपलाइन द्वारा सीमित होते हैं। अनिवार्य रूप से, DeepSeek ओपन-वेट होने के कारण डेवलपर्स को ऊपर नवाचार करने की स्वतंत्रता दी जाती है, जबकि बंद समाधान "जो आप देखते हैं वही आपको मिलता है।" यह लचीलापन अनुप्रयोग पक्ष पर तेजी से नवाचार के लिए उत्प्रेरक है - हम DeepSeek के आसपास निर्मित नए उपयोग मामलों (जैसे, इंटरैक्टिव दस्तावेज़ चैटबॉट्स, या दृश्य दस्तावेज़ संपादन उपकरण) देख सकते हैं जो बंद APIs का उपयोग करके संभव नहीं होते या लागत-प्रभावी नहीं होते।

- नवाचार की गति: ओपन-सोर्स मॉडल आमतौर पर समुदाय योगदान और अनुसंधान एकीकरण के माध्यम से तेजी से विकसित होते हैं, जबकि बंद सेवाएं अपने दरवाजे के पीछे और अपने समय पर सुधार करती हैं। DeepSeek-OCR के खुला होने के कारण, शोधकर्ता इसके आर्किटेक्चर की जांच कर सकते हैं और उस पर निर्माण कर सकते हैं। यदि कोई इसे 2× तेज या अधिक सटीक बनाने का तरीका खोजता है, तो वे उन सुधारों को खुले तौर पर साझा कर सकते हैं। उदाहरण के लिए, कल्पना करें कि एक सामुदायिक प्रयास मॉडल को एज डिप्लॉयमेंट के लिए प्रून या क्वांटाइज़ करने के लिए होता है - यह ओपन सोर्स में हफ्तों के भीतर हो सकता है। बंद प्रदाता, इसके विपरीत, हर कुछ महीनों या साल में अपने OCR टेक को अपडेट कर सकते हैं, और उपयोगकर्ताओं को शायद यह भी नहीं पता होता है कि हड के नीचे क्या बदला गया। ओपन मॉडल में नवाचार की गति LLM क्षेत्र में साबित हुई है (हमने खुले LLMs को प्रमुख प्रयोगशालाओं के प्रदर्शन तक महीनों में पकड़ते देखा है)। हम यहां एक समान प्रभाव की उम्मीद कर सकते हैं: DeepSeek की रिलीज़ Google/AWS के खिलाफ प्रतिस्पर्धी बेंचमार्किंग को प्रोत्साहित करेगी, और यदि यह किसी भी क्षेत्र में कम पड़ता है, तो कई आँखें इसे सुधारने के तरीकों पर होंगी। इसके अलावा, एक व्यवहार्य ओपन विकल्प होने से बंद-स्रोत OCR प्रदाताओं पर मूल्य निर्धारण और सुविधाओं पर दबाव पड़ेगा। यदि कंपनियां लागत बचाने के लिए या विक्रेता लॉक-इन से बचने के लिए ओपन मॉडल पर शिफ्ट हो जाती हैं, तो क्लाउड OCR सेवाएं मूल्य कम करके या नए मूल्य-वर्धित सुविधाओं की पेशकश करके प्रतिक्रिया दे सकती हैं (उदाहरण के लिए, अन्य क्लाउड उपकरणों के साथ अधिक सहज एकीकरण, या डेटा गोपनीयता की गारंटी)। यह एक स्वस्थ प्रतिस्पर्धा है जो अंततः अंतिम उपयोगकर्ताओं को लाभ देती है। यह दर्शाता है कि कुछ बड़े तकनीकी नेताओं ने ओपन AI की गति को स्वीकार किया है - उदाहरण के लिए, OpenAI के CEO सैम ऑल्टमैन ने हाल ही में टिप्पणी की, "मुझे व्यक्तिगत रूप से लगता है कि हम यहाँ [बंद मॉडल के साथ] इतिहास के गलत पक्ष पर रहे हैं और हमें एक अलग ओपन-सोर्स रणनीति का पता लगाना होगा।" यह बयान तब आया जब DeepSeek जैसे खुले मॉडल ने तेजी से प्रगति दिखाई। OCR क्षेत्र में, DeepSeek-OCR समान रूप से यह सोचने के लिए मजबूर कर सकता है कि स्वामित्व वाली पेशकशें कितनी मूल्यवान हैं बनाम समुदाय-चालित परियोजनाएँ।

उद्योग पर प्रभाव: ओपन-वेट विज़न-लैंग्वेज मॉडल और बड़ी टेक्नोलॉजी

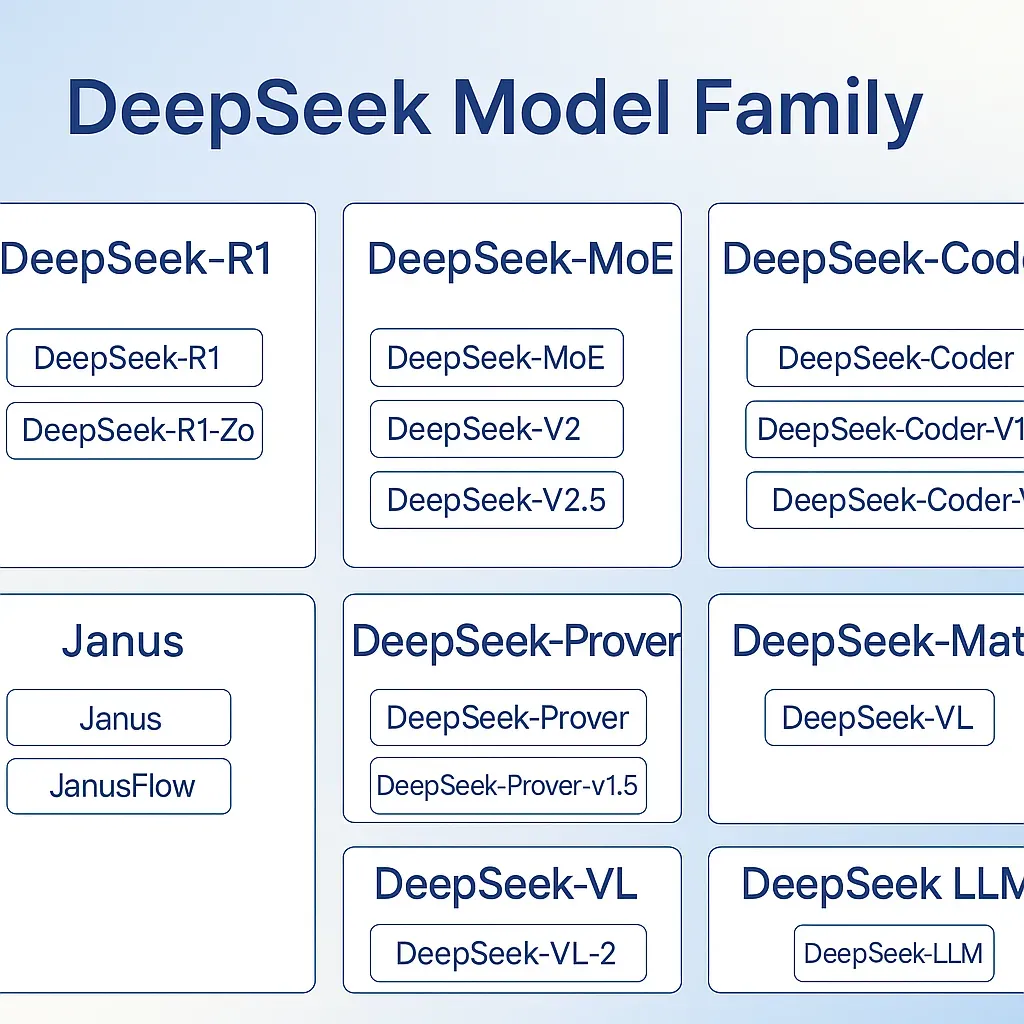

DeepSeek-OCR की शुरुआत AI में एक व्यापक लहर का हिस्सा है: खुले-वज़न दृष्टि-भाषा मॉडल (VLMs) का उदय। पहले, अत्याधुनिक बहु-मॉडल मॉडल (जैसे OCR, इमेज कैप्शनिंग, या VQA करने वाले) लगभग विशेष रूप से स्वामित्व या अकादमिक प्रमाण थे। अब हम एक परिवर्तन Paradigm देख रहे हैं। पिछले एक या दो वर्षों में, संगठनों और अनुसंधान समूहों ने – कई पारंपरिक बड़ी तकनीकी क्षेत्र से बाहर – उन्नत VLMs को ओपन-सोर्स कर दिया है जिनकी क्षमताएं प्रभावशाली हैं। DeepSeek खुद इस आंदोलन के अग्रणी रहे हैं। उनके पहले के रिलीज़, जैसे DeepSeek-VL2 श्रृंखला (2024 के अंत में 3B, 16B, 27B MoE मॉडल), अग्रणी खुले दृष्टि-भाषा प्रणालियाँ थीं[48][17]। उन मॉडलों ने जटिल दृश्य डेटा को कुशलतापूर्वक संभालने के लिए डायनामिक इमेज टाइलिंग और लेटेंट ध्यान जैसी नवाचारों को पेश किया[49][17]। नया DeepSeek-OCR उसी नींव पर बना है, दस्तावेज़ समझ और लंबी-संदर्भ संपीड़न पर ध्यान केंद्रित करता है। महत्वपूर्ण बात यह है कि इन सभी मॉडलों में एक चीज समान है: सार्वजनिक वज़न और बहुमॉडल AI को लोकतांत्रिक बनाने का मिशन।

यह प्रवृत्ति बंद-स्रोत दिग्गजों पर प्रतिस्पर्धात्मक दबाव डाल रही है। ऐतिहासिक रूप से देखें, तो यदि आपको ऐसा मॉडल चाहिए था जो "देख" और "पढ़" सके, तो आपको Google Vision जैसी सेवाओं का उपयोग करना पड़ता था या महंगे स्वामित्व वाले सॉफ्टवेयर के लिए भुगतान करना पड़ता था (या Tesseract जैसे पुराने खुले उपकरणों का उपयोग करना पड़ता था, जो बहुत कम सक्षम होते थे)। अब, DeepSeek-OCR जैसे खुले मॉडल (और अन्य, जैसे अलीबाबा का Qwen-VL या मेटा के खुले छवि-पाठ मॉडल) के साथ, डेवलपर्स के पास विकल्प हैं जो उन्हें किसी बड़े प्रदाता के पारिस्थितिकी तंत्र से नहीं बाँधते। यह खुलापन नवाचार को इस तरह से बढ़ावा दे सकता है जैसा कि बंद मॉडल नहीं कर सके। उदाहरण के लिए, एक अकादमिक लैब DeepSeek के वेट्स को लेकर उन्हें दृष्टि-समृद्ध प्रश्न-उत्तर के लिए फाइन-ट्यून कर सकती है, और गूगल या OpenAI की भागीदारी के बिना एक नया अत्याधुनिक मॉडल जारी कर सकती है। सामूहिक प्रगति उल्लेखनीय है: एक विश्लेषण में यह नोट किया गया कि भले ही प्रारंभ में बंद मॉडल ने बढ़त ली, खुले स्रोत रिलीज़ ने प्रदर्शन के अंतर को तेजी से बंद किया है और नए शोध दिशाओं को प्रेरित किया है[45][46]। दृष्टि-भाषा डोमेन में, हम देख रहे हैं कि खुले मॉडल छवि-टू-मार्कअप (जैसे, आरेखों को कोड में बदलना) या मल्टीमॉडल तर्क जैसी कार्यों को संभाल रहे हैं, जो पहले टेक कंपनियों के आंतरिक शोध का क्षेत्र था।

खुले-वजन वाले VLMs की उपस्थिति एक अधिक पारदर्शी अनुसंधान संस्कृति को भी बढ़ावा देती है। DeepSeek-OCR की तकनीकी रिपोर्ट और मॉडल उपलब्ध होने के साथ, शोधकर्ता दावों को सत्यापित कर सकते हैं और उन पर आगे काम कर सकते हैं – उदाहरण के लिए, अपने दस्तावेज़ों पर 97% संपीड़न निष्ठा के दावे की जाँच करना[50]। यह प्रतिमान को "केवल कुछ कंपनियाँ ही यह कर सकती हैं" से "समुदाय में कोई भी इसे दोहरा और विस्तारित कर सकता है" की ओर स्थानांतरित करता है। हमने देखा है कि शुद्ध पाठ LLM दुनिया में यह कैसे खेला गया: मेटा का LLaMA (आंशिक रूप से खुला) 2023 में नवाचार की बाढ़ लाया, और 2025 की शुरुआत में DeepSeek के अपने R1 जैसे मॉडल "पूरी तरह से खुले और प्रतिस्पर्धी" होने के लिए "मुख्य पुनरावृत्ति" के रूप में प्रशंसा किए गए थे[51]। उस मॉडल को पहले स्पष्ट फ्रंटियर-स्तरीय मॉडल के रूप में उद्धृत किया गया था जिसमें कोई उपयोग प्रतिबंध नहीं था, और यह वास्तव में बंद मॉडल समर्थकों के बीच आत्म-विश्लेषण को प्रेरित करता था[51][47]। अब DeepSeek-OCR वही भावना दृष्टि-पाठ AI में ला रहा है।

यहां तक कि उद्योग के नेताओं ने भी इन विचारों में रुचि दिखाई है। प्रसिद्ध AI शोधकर्ता आंद्रे कारपथी ने डीपसीक-ओसीआर के दृष्टिकोण पर टिप्पणी की, यह नोट करते हुए कि कुछ मामलों में छवियों का उपयोग LLM इनपुट के रूप में पाठ टोकन की तुलना में अधिक कुशल और अभिव्यक्तिपूर्ण हो सकता है[52][53]। उन्होंने बताया कि कैसे एक छवि पैच कई वर्णों को एन्कोड कर सकता है (उच्च सूचना घनत्व) और कैसे छवियां स्वाभाविक रूप से स्वरूपण (फॉन्ट, लेआउट) शामिल करती हैं जो पाठ खो देता है[53][54]। उनके दृष्टिकोण में, डीपसीक-ओसीआर पेपर एक ऐसे भविष्य की ओर संकेत करता है जहां छवि इनपुट मॉडलों में लंबे संदर्भों को खिलाने का एक सामान्य तरीका बन जाता है, संभावित रूप से "भाषा" मॉडलों को अधिक सामान्य "सूचना मॉडलों" के रूप में परिभाषित करता है[55][56]। इस तरह के विचार नेताओं के दृष्टिकोण यह दिखाते हैं कि कैसे इस तरह का खुला शोध नए दिशाओं को प्रज्वलित कर सकता है। यदि छवियां-संदर्भ एक प्रवृत्ति बन जाती हैं, तो हमें इसे डीपसीक जैसे प्रयोगों को साबित करने का श्रेय देना होगा। कारपथी ने मजाक में कहा कि उन्हें “तुरंत एक चैटबॉट विकसित करने से खुद को रोकना पड़ा जो केवल छवि इनपुट का समर्थन करता है” इन परिणामों को देखने के बाद[57] – यह विचार कितना आशाजनक है, इसका एक चुटीला संकेत है, भले ही व्यावहारिक चुनौतियां बनी रहें (क्योंकि मॉडल अभी भी पाठ आउटपुट करते हैं)। मुख्य बिंदु यह है कि खुले मॉडल खुले चर्चा और खोज को बढ़ावा देते हैं। विचार गुप्त स्वामित्व वाले रहस्य नहीं रहते; वे जल्दी से क्षेत्र में फैल जाते हैं।

प्रतिस्पर्धात्मक दृष्टिकोण से, ओपन-वेट मॉडल का चलन उन लीड को कम कर रहा है जो कभी बंद-स्रोत दृष्टि-भाषा प्रणालियों के पास थी। विशेष रूप से चीनी टेक लैब्स ने कई उल्लेखनीय ओपन मॉडल और डेटा सेट जारी किए हैं, जो कुछ क्षेत्रों में पश्चिमी प्रयासों के साथ तालमेल बिठा रहे हैं (या यहां तक कि उन्हें पार कर रहे हैं)[58]। दीपसीक स्वयं एक चीनी स्टार्टअप (हांग्जो आधारित) है जो ओपन-सोर्स की गई नई खोजों के जरिए वैश्विक लहरें बना रहा है[1][59]। यह पूर्व-पश्चिम ओपन सहयोग सभी के लिए प्रगति को तेज करता है। बड़ी टेक कंपनियां इसे नोटिस कर रही हैं - कुछ ने अपने दृष्टिकोण को हाइब्रिडाइज करके प्रतिक्रिया देना शुरू कर दिया है (उदाहरण के लिए, मेटा ने कुछ दृष्टि मॉडल जैसे सेगमेंट एनीथिंग को ओपन-सोर्स करना शुरू कर दिया है, या ओपनएआई ने कुछ छोटे मॉडल को खोलने की कोशिश की है)[47][60]।

बड़े परिप्रेक्ष्य में, MIT लाइसेंस के तहत DeepSeek-OCR 3B की रिलीज़ ओपन-सोर्स AI क्रांति में एक और मील का पत्थर है। यह समुदाय के दृष्टिकोण से E-E-A-T (अनुभव, विशेषज्ञता, अधिकारिता, विश्वसनीयता) का उदाहरण प्रस्तुत करता है: अनुभवी AI डेवलपर्स अपने ज्ञान और मॉडल के "अनुभव" को समुदाय के साथ खुलकर साझा करते हैं, जो विश्वास और सामूहिक ज्ञान को बढ़ाता है। डेवलपर्स और व्यवसायों के लिए, इसका मतलब है कि उन्नत OCR अब केवल टेक दिग्गजों तक सीमित नहीं है – यह एक साझा सार्वजनिक संसाधन है जिसे कोई भी अपनी ऐप्लिकेशन्स में बना सकता है। और AI के क्षेत्र के लिए, यह याद दिलाता है कि खुलापन तेजी से नवाचार को प्रेरित कर सकता है। मॉडल की संदर्भों को संपीड़ित करने और दृष्टि-पाठ कार्यों को संभालने की क्षमता एक नई श्रेणी के संकर ऐप्लिकेशन्स और और भी अधिक कुशल MoE VLM आर्किटेक्चर्स में अनुसंधान को प्रेरित कर सकती है। बंद-स्रोत दिग्गजों के लिए अब एक स्पष्ट संदेश है: ओपन समुदाय तेजी से आगे बढ़ रहा है, और प्रासंगिक (और नैतिक, और व्यापक रूप से अपनाया गया) बने रहने के लिए, खुलेपन को अपनाना आवश्यक हो सकता है। जैसा कि एक रिपोर्ट ने कहा, DeepSeek ने LLMs को एक खुले वैश्विक वैज्ञानिक परियोजना के रूप में एक बड़ा बढ़ावा दिया, एक बंद "मैनहट्टन परियोजना" के विपरीत – इतना कि यहां तक कि पहले से बंद खिलाड़ी भी अपनी स्थिति पर पुनर्विचार कर रहे हैं[51][47]।

निष्कर्ष

DeepSeek 3B MoE OCR अत्याधुनिक अनुसंधान का संगम है: यह विशेषज्ञों के मिश्रण वाले ट्रांसफॉर्मर को एक समझदारी से डिज़ाइन किए गए विज़न एन्कोडर के साथ जोड़ता है ताकि पारंपरिक LLMs की संदर्भ लंबाई सीमाओं को तोड़ सके। वास्तुकला के दृष्टिकोण से, यह घने मॉडलों से अलग होता है क्योंकि यह प्रति टोकन विशेषज्ञों को सक्रिय करता है और छवियों को पाठ कार्यों के लिए प्रथम श्रेणी के इनपुट के रूप में मानता है। व्यावहारिक रूप से, यह 10× कमी पर लगभग बिना हानि के OCR संपीड़न प्राप्त करता है, वास्तविक दुनिया के दस्तावेज़ों की जटिलताओं को संभालता है, और इसे कई भाषाओं और प्रारूपों में करता है। उतना ही महत्वपूर्ण है कि यह किसके लिए खड़ा है – एक ओपन-सोर्स, MIT-लाइसेंस प्राप्त मॉडल उस समय जब ऐसी क्षमताओं को तकनीकी दिग्गजों के संरक्षित क्षेत्र के रूप में माना जाता था। DeepSeek-OCR को खुले रूप में जारी करके, इसके निर्माताओं ने दुनिया भर के डेवलपर्स को एक शक्तिशाली उपकरण से सुसज्जित किया है और बंद प्रदाताओं को चुनौती दी है।

डेवलपर्स के लिए, संदेश स्पष्ट है: ओसीआर और दस्तावेज एआई अब और भी सुलभ हो गए हैं। आप अपने स्टैक में विशेषज्ञ स्तर के विज़न-लैंग्वेज मॉडल को शामिल कर सकते हैं बिना प्रति एपीआई कॉल के भुगतान किए या सेवा सीमाओं की चिंता किए। आप इसे फाइन-ट्यून कर सकते हैं, इसे विश्लेषित कर सकते हैं, या सिर्फ इसे आउट-ऑफ-द-बॉक्स उपयोग कर सकते हैं ताकि पीडीएफ, छवियों और अन्य को अर्थपूर्ण पाठ या डेटा में परिवर्तित किया जा सके। प्रारंभिक उपयोगकर्ताओं ने पहले ही पूरे शोध पत्रों को मार्कडाउन में बदलने, तालिकाओं और गणित को सटीक रूप से निकालने, और यहां तक कि इस मॉडल का उपयोग करके दृश्य प्रश्न उत्तर जैसी कार्यों को भी निपटाने का प्रदर्शन किया है। एकल ओसीआर सिस्टम में इस तरह की लचीलापन अभूतपूर्व है।

उद्योग के लिए, DeepSeek-OCR यह उदाहरण प्रस्तुत करता है कि कैसे ओपन-सोर्स प्रयास गुणवत्ता और नवाचार के मामले में बंद समाधानों के साथ अंतर को कम करते जा रहे हैं (और कभी-कभी उन्हें पछाड़ भी देते हैं)। यह बढ़ते सबूतों में जोड़ता है कि ओपन मॉडल नए मानक स्थापित कर सकते हैं – इमेजिंग में Stable Diffusion से लेकर NLP में LLaMA डेरिवेटिव्स तक, और अब विज़न-लैंग्वेज OCR में DeepSeek तक। हम DeepSeek-OCR पर आधारित तेजी से प्रयोग की अवधि देखने की संभावना रखेंगे: अनुकूलित संस्करणों की उम्मीद करें, बड़े फॉलो-अप मॉडल (शायद DeepSeek-OCR 16B MoE?), और ओपन-सोर्स OCR पाइपलाइनों और UI टूल्स में एकीकरण। अंतिम लाभार्थी हम सभी होंगे, जो AI फीचर्स के तेजी से विकास और हमारे द्वारा उपयोग किए जाने वाले टूल्स में अधिक विकल्प का आनंद लेंगे।

संक्षेप में, DeepSeek 3B MoE सिर्फ एक OCR मॉडल से कहीं अधिक है – यह AI के अगले चरण का अग्रदूत है जहाँ ओपन-वेट मल्टीमोडल मॉडल उन क्षेत्रों में नवाचार को बढ़ावा देते हैं जो ऐतिहासिक रूप से मालिकाना प्रणालियों द्वारा प्रभुत्व रखते थे। यह OCR और लंबे दस्तावेज़ की समझ में अनुसंधान और अनुप्रयोग विकास के लिए समान अवसर प्रदान करता है। इतनी उच्च क्षमताओं वाले एक ओपन मॉडल को अपनाकर, समुदाय एक मजबूत संकेत भेजता है: AI प्रगति का भविष्य शायद कुछ बड़े लोगों का नहीं, बल्कि सबका हो सकता है। और जैसा कि DeepSeek-OCR दिखाता है, कभी-कभी टेक्स्ट के पहाड़ को संभालने का सबसे अच्छा तरीका है उसे देखना – और अब सही मॉडल के साथ, कोई भी ऐसा कर सकता है।

स्रोत: इस विश्लेषण को संकलित करने के लिए उच्च-अधिकारिता संदर्भों और दस्तावेज़ों का उपयोग किया गया, जिसमें आधिकारिक डीपसीक-ओसीआर तकनीकी रिपोर्ट और मॉडल कार्ड शामिल हैं[8][50], साउथ चाइना मॉर्निंग पोस्ट और मार्कटेकपोस्ट से समाचार कवरेज[1][24], आंद्रेज कारपथी जैसे एआई विशेषज्ञों की अंतर्दृष्टि[53][56], और गूगल/अमेज़न ओसीआर सेवाओं पर तुलनात्मक जानकारी[41][44]। ये स्रोत वास्तुकला के विवरण, प्रदर्शन के दावों, और उद्योग के संदर्भ को प्रमाणित करते हैं, जो ऊपर चर्चा की गई डीपसीक-ओसीआर की महत्वता का एक सटीक और विश्वसनीय खाता सुनिश्चित करते हैं।

[1] [6] [59] डीपसीक ने मल्टीमॉडल एआई मॉडल का अनावरण किया जो विजुअल परसेप्शन का उपयोग करके टेक्स्ट इनपुट को संपीड़ित करता है | साउथ चाइना मॉर्निंग पोस्ट

[2] [3] [9] [10] [11] [12] [15] [18] [23] [27] [28] [32] DeepSeek OCR आ गया है। DeepSeek OCR को मुफ्त में कैसे उपयोग करें? | मेहुल गुप्ता द्वारा | डेटा साइंस इन योर पॉकेट | अक्टूबर, 2025 | मीडियम

https://medium.com/data-science-in-your-pocket/deepseek-ocr-is-here-37096b562bb0

[4] [5] DeepSeek-OCR: मल्टीमॉडल एआई 7-20x तक पाठ प्रसंस्करण टोकन को कम करता है - समाचार और आंकड़े - IndexBox

https://www.indexbox.io/blog/deepseek-releases-multimodal-model-for-text-compression/

[7] [38] GitHub - deepseek-ai/DeepSeek-OCR: संदर्भ ऑप्टिकल संपीड़न

https://github.com/deepseek-ai/DeepSeek-OCR/tree/main

[8] [13] [14] [16] [19] [20] [21] [22] [24] [25] [26] [29] [30] [31] [33] [37] [50] DeepSeek ने अभी एक 3B OCR मॉडल जारी किया है: उच्च-प्रदर्शन OCR और संरचित दस्तावेज़ रूपांतरण के लिए डिज़ाइन किया गया एक 3B VLM - MarkTechPost

[17] [48] [49] डीपसीक-एआई ने डीपसीक-वीएल2 श्रृंखला को ओपन सोर्स किया: 3B, 16B, और 27B पैरामीटर के तीन मॉडल, मिक्सचर-ऑफ-एक्सपर्ट्स (MoE) आर्किटेक्चर के साथ, विज़न-लैंग्वेज एआई को फिर से परिभाषित कर रहे हैं : r/machinelearningnews

[34] [35] [36] [39] [40] deepseek-ai/DeepSeek-OCR · Hugging Face

https://huggingface.co/deepseek-ai/DeepSeek-OCR

[41] [42] [43] [44] ए डब्ल्यू एस बनाम गूगल विजन (ओसीआर फीचर्स तुलना) | IronOCR

[45] [46] [47] [51] [58] [60] ओपन बनाम क्लोज्ड: भाषा मॉडलों के भविष्य की लड़ाई | अमेरिकी सिविल लिबर्टीज यूनियन

https://www.aclu.org/news/privacy-technology/open-source-llms

[52] [53] [54] [55] [56] [57] Andrej Karpathy ने DeepSeek-OCR पेपर पर टिप्पणी की है: छवि इनपुट बड़े भाषा मॉडलों के लिए एक नई दिशा बन सकता है