စတက်တစ်မော်ဒယ်များမှ အဆင့်မြင့် ဉာဏ်ရည်ရှိသော ကိရိယာများသို့: Tinker နှင့် Mind Lab တွင် ရှုထောင့်အသစ်များ

ရေးသားသူ: Boxu LI

အတုယူပညာရပ်၏ အဆင့်မြင့်ဖြစ်မှုအတွင်းတွင်၊ အလွန်ကြီးမားသောစွမ်းရည်များကို များပြားစွာ သင်ကြားခြင်းမှ ဉာဏ်ရည်ရှိသော AI ကိရိယာများ ဖန်တီးခြင်းသို့ ပြောင်းလဲလာခဲ့သည်။ ဤကိရိယာများသည် အနက်ရှိုင်းဆုံး အကြောင်းပြချက်ပေးခြင်း၊ ကိရိယာများကို အသုံးပြုခြင်း၊ ကြည့်ရှုခြင်းနှင့် မှတ်မိခြင်း၊ အတွေ့အကြုံမှ ဆက်လက်သင်ယူခြင်းတို့ကို ပြုလုပ်နိုင်သည်။ [1].

Thinking Machines Lab ၏ Tinker ပလက်ဖောင်းသည် 2025 ခုနှစ် ဒီဇင်ဘာလ 12 ရက်နေ့တွင် အထွေထွေအသုံးပြုနိုင်မှုကို ကြေညာခဲ့ပြီး၊ သန်းပေါင်းများစွာသော မော်ဒယ်များ၏ ပြုပြင်ခြင်းနှင့် မျက်မှောက်ပြုလုပ်မှုပိုင်းဆိုင်ရာကို အများပြည်သူသိရှိရန် အရေးကြီးသော အခြေခံအဆောက်အအုံတစ်ခုကို ဖန်တီးပေးသည်။ အတူတကွ၊ Mind Lab— Macaron AI ၏ သုတေသနဌာန—သည် "အတွေ့အကြုံမှ ဉာဏ်ရည်" အတွက် အတွေးအခေါ်နှင့် နည်းပညာဆိုင်ရာဖွဲ့စည်းခြင်းကို ဖော်ပြလျက်ရှိသည်၊ ဤမှာ မော်ဒယ်များသည် သိကြားထားသော အချက်အလက်များကို ရုပ်သိမ်းထားခြင်းမှ တိုးတက်မှုနဲ့အတူ ပြုပြင်ခြင်းကို အရေးကြီးသော အခါမှ နောက်ပြန်သွားရန် ဖြစ်သည်။ ဤအပြောင်းအလဲသည် သုတေသနနှင့် ထုတ်ကုန်၏ ဖန်တီးမှုကို တိုးတက်စေပြီး၊ အယ်လဂေါရစ်မှ ဆန်းသစ်မှုနှင့် အသုံးပြုမှုကြားတွင် ချိတ်ဆက်မှုကို ပိတ်ပြီး အရေးကြီးသော အခွင့်အလမ်းများကို ပေးစွမ်းသည်။

Tinker ၏ ဖွံ့ဖြိုးတိုးတက်မှုများတွင် အဓိက ဖန်တီးမှုများ

- Thinking Machines Lab ၏ Tinker ပလက်ဖောင်းသည် အထွေထွေသုံးနိုင်မှုအဆင့်သို့ရောက်ရှိပြီး Moonshot AI ၏ ထရီလီယံ-ပါရာမီတာ Kimi K2 Thinking MoE မော်ဒယ်၏ လိုအပ်ချက်များကို ထပ်တိုးပြုပြင်နိုင်မှု၊ OpenAI-compatible ချိန်ခွင်မှုနှင့် Alibaba ၏ Qwen3-VL စီးရီးမှ မြင်ကွင်းဝင်ရောက်မှုများကို ပံ့ပိုးပေးသည်။

- ဤအရာများသည် နောက်ဆုံးနည်းပညာ reasoning နှင့် မြင်ကွင်း-ဘာသာစကားမော်ဒယ်များကို ထိရောက်စွာစိတ်ကြိုက်ပြုပြင်နိုင်စေရန် ကူညီပေးပြီး၊ ပုံရိပ်ခွဲခြားမှုတွင် အလွန်ထူးခြားသော ဦးစားပေးမှုကို ဖျော်ဖြေရန် ကိုယ်စားပြုချက်များကို ပြသပေးသည်။

- Mind Lab (Macaron AI ၏ သုတေသနအဖွဲ့) သည် ထရီလီယံ-အတိုင်းအတာ MoE မော်ဒယ်များအပေါ် LoRA-based RL ကို အဆင့်မြှင့်တင်ပြီး အတွေ့အကြုံမှီပြုပြင်မှုကို အဓိကထားသည်။

ဤဆောင်းပါးတွင် Tinker ၏ Kimi K2 reasoning မော်ဒယ်အသစ်၊ OpenAI-compatible အင်တာဖေ့စ်နှင့် Qwen3-VL မြင်ကွင်းမော်ဒယ်များကို ဆန်းစစ်ကြမည်။ ထို့နောက် Mind Lab ၏ အတွေ့အကြုံမှီ ဉာဏ်ရည်အယူအဆ၊ ထရီလီယံ-ပါရာမီတာ reinforcement learning (RL) အောင်မြင်မှုများ၊ မှတ်ဉာဏ်ဖြန့်ဝေမှုနည်းလမ်းနှင့် AI စနစ်များ၏ နောက်မျိုးဆက်တည်ဆောက်မှုအတွက် မဟာဗျူဟာဆိုင်ရာ အကျိုးသက်ရောက်မှုများကို လေ့လာကြမည်။

Tinker ၏ နောက်ဆုံးဆန်းသစ်မှုများ: Reasoning, Tools, and Vision

Tinker သည် သုတေသနပြုသူများအတွက် အဆင့်မြင့်မော်ဒယ်များကို အခြေခံအဆောက်အအုံရှုပ်စရာမလိုဘဲ လေ့ကျင့်၍ အသုံးပြုနိုင်ရန် ဒီဇိုင်းထုတ်ထားသော AI လေ့ကျင့်မှုပလက်ဖောင်းဖြစ်သည်[2][3]။ 2025 ဒီဇင်ဘာလတွင် Tinker သည် AI မော်ဒယ်များ၏ လက်ခံနားလည်နိုင်မှု, ကိရိယာအသုံးပြုခြင်းနှင့် မြင်ကွင်းနားလည်မှုတို့ကို ပိုမိုမြှင့်တင်သည့် အရေးကြီးသော အပ်ဒိတ်အချို့ကို ကြေညာခဲ့သည်[4]။

- Kimi K2 စဉ်းစားမှု မော်ဒယ်: အသုံးပြုသူများသည် Kimi K2 စဉ်းစားမှု ကို ယခု fine-tune ပြုလုပ်နိုင်ပြီး၊ Tinker ၏ များစွာသော 1-ထရီလီယံ-ပါရာမီတာ မော်ဒယ်နှင့် အကြီးမားဆုံးဖြစ်သည်[5]။ Kimi K2 သည် ရှည်ကြာသော စဉ်းစားမှုနှင့် တန်ဆာပလာ အသုံးပြုမှုအတွက် ဒီဇိုင်းပြုလုပ်ထားသော MoE (Mixture-of-Experts) တရားဗက်စ်ဖော်မာဖြစ်သည်[6]။ ၎င်း၏ အရွယ်အစားကြီးမားစွာရှိသော်လည်း၊ ၎င်း၏ ပါရာမီတာများ၏ အနည်းငယ် (~32B) သာ အခါအားလျော်စွာ အသုံးပြုသည်၊ ထိုကြောင့် အထူးပြုစဉ်းစားမှု စွမ်းဆောင်ရည်ကို ရရှိစေပြီး၊ သုံးစွဲမှုကို ထိရောက်စွာ ထိန်းသိမ်းနိုင်သည်[7]။ ဤ ဖွင့်လှစ်ထားသော မော်ဒယ်သည် “ဖွင့်လှစ်ထားသော စဉ်းစားမှုသိပ္ပံ” ဟု ဖော်ပြထားပြီး၊ စဉ်းစားမှု ပြိုင်ဆိုင်မှုများတွင် များစွာသော ပိတ်ထားသော မော်ဒယ်များကို ယှဉ်ပြိုင်နိုင်သည် သို့မဟုတ် ကျော်လွန်နိုင်သည်[7]။ Tinker တွင် Kimi K2 ကို ထောက်ပံ့ခြင်းဖြင့်၊ Thinking Machines သည် ရှေးရှုခြင်း၊ အစီအစဉ်ရေးခြင်း သို့မဟုတ် ပြင်ပတန်ဆာပလာအသုံးပြုမှုလိုအပ်သော တာဝန်များအတွက် အဆင့်မြင့်စဉ်းစားမှု အင်ဂျင်တစ်ခုကို ရင်းနှီးအသုံးပြုနိုင်စေသည်။ အရေးကြီးသောအချက်တစ်ခုမှာ Tinker သည် LoRA (Low-Rank Adaptation) ကို အသုံးပြု၍ မော်ဒယ်များကို fine-tune ပြုလုပ်သည်၊ ထရီလီယံ အလေးချိန်အားလုံးကို ပြောင်းလဲမည်မှမဟုတ်ဘဲ စီမံချက်အနည်းများသာ လေ့ကျင့်သည့်အတွက်ဖြစ်သည်[8]။ ဤနည်းလမ်းသည် စိတ်ကြိုက်ပြုလုပ်မှုအတွက် လိုအပ်သော မှတ်ဉာဏ်နှင့် တွက်ချက်မှုကို အလွန်လျော့နည်းစေနိုင်သည်။ အမှန်အားဖြင့်၊ ပြင်ဆင်မှုကို တိကျစွာ ပြုလုပ်နိုင်သည်ဆိုပါက၊ LoRA သည် အပြည့်အဝ fine-tuning ၏ လေ့လာမှုစွမ်းဆောင်ရည်နှင့် ကိုက်ညီစွာ အရင်းအမြစ်နည်းပါးစွာ အသုံးပြုနိုင်ကြောင်း အတွင်းပိုင်း လေ့လာမှုများမှ တွေ့ရှိခဲ့သည်[9]။ အမှန်တကယ်တွင်၊ ၎င်းသည် သုံးစွဲသူများကို Kimi K2 အကြီးမားသော မော်ဒယ်ကို အသစ်သော တာဝန်များ သို့မဟုတ် နယ်ပယ်များသို့ ချိန်ညှိအသုံးပြုနိုင်စေသည်၊ စဉ်းစားမှု လုပ်ငန်းစဉ်များကို ထိရောက်စွာ ဆောင်ရွက်နိုင်ရန် အရေးကြီးသော ခြေလှမ်းဖြစ်သည်။

- OpenAI API-Compatible Inference: သုတေသန-ထုတ်ကုန် ပေါင်းစည်းမှုကို အရှိန်မြှင့်ရန် Tinker သည် OpenAI ၏ API နှင့် ကိုက်ညီသော inference အင်တာဖေ့စ်ကို မိတ်ဆက်လိုက်သည်[10]။ အထူးသဖြင့်၊ Tinker-hosted မော်ဒယ်ကို OpenAI ၏ ပလက်ဖောင်းအသုံးပြုမှုအတိုင်း API ခေါ်ဆိုမှုများကို အသုံးပြု၍ မော်ဒယ်လမ်းကြောင်းကို tinker:// URI နှင့် ထည့်သွင်း၍ မေးမြန်းနိုင်သည်။ ဥပမာအားဖြင့်၊ ဖွံ့ဖြိုးသူများသည် Tinker မော်ဒယ်ကို OpenAI စနစ်ဖြင့် (model, prompt, max_tokens, စသည်တို့) ခေါ်ဆိုပြီး၊ openai.Completion.create ကို ခေါ်ဆိုသည့်အတိုင်း ရလဒ်ရရှိနိုင်သည်[10]။ ဤ plug-and-play ကိုက်ညီမှု အားဖြင့် OpenAI API အပေါ်တွင် တည်ဆောက်ထားသော အရည်အသွေးဖြစ်သော တန်ဆာပလာ သို့မဟုတ် လုပ်ငန်းစဉ်များသည် Tinker ၏ မော်ဒယ်များကို ထိရောက်စွာ ပေါင်းစပ်နိုင်သည်[10]။ ၎င်းအတွက် အဆင့်မြင့် ဖွင့်လှစ်ထားသော မော်ဒယ်များကို အမှန်တကယ် ထုတ်ကုန်များတွင် သုံးနိုင်ရန် အခက်အခဲကို လျော့နည်းစေသည်။ ၎င်းသည် Tinker တွင် Kimi K2 ကို fine-tune ပြုလုပ်ပြီး၊ ရှည်လျားသော စဉ်းစားမှု အေးဂျင့် သို့မဟုတ် chatbot ဖရိမ်ဝေါ့ခ်အတွင်း အနည်းငယ်သော ကုဒ်ပြောင်းလဲမှုများဖြင့် ထည့်သွင်းနိုင်သည်။ ထို့အပြင်၊ Tinker ၏ API scaffolding သည် မော်ဒယ်ကို လေ့ကျင့်နေစဉ်တွင်ပင် နမူနာရယူနိုင်စေရန် ပါဝင်သည်[10] - မော်ဒယ်ကို fine-tuning လုပ်ငန်းစဉ်နှင့် တပြိုင်တည်း စမ်းသပ်ခြင်းနှင့် အသုံးပြုခြင်းကို ခွင့်ပြုသည်။ ဤ အပ်ဒိတ်သည် သုတေသနပြုသူများကို အဆင့်မြင့် စဉ်းစားမှု အင်ဂျင်များကို အရှိန်မြှင့်၍ လုပ်ငန်းစဉ်များကို ပုံမှန်စွာ ပေါင်းစပ်၍ စမ်းသပ်နိုင်စေရန် ထောက်ပံ့ပေးသည်။

- Qwen3-VL ရှုမျက်နှာ-ဘာသာစကား မော်ဒယ်များ: Tinker ၏ အခြားအရေးကြီးသော ထည့်သွင်းမှုတစ်ခုမှာ multimodal vision-language မော်ဒယ်များ ကို ထောက်ပံ့ခြင်းဖြစ်သည်။ ပလက်ဖောင်းတွင် ပုံရိပ်များကို လက်ခံနိုင်သော Qwen3-VL-30B နှင့် Qwen3-VL-235B ရှုမျက်နှာ မော်ဒယ်နှစ်ခုကို ထည့်သွင်းလိုက်သည်[11]။ ဤမော်ဒယ်များ (MoE နည်းပညာဖြင့် 30 ဘီလီယံနှင့် 235 ဘီလီယံ ပါရာမီတာ) သည် ပုံရိပ်များပါဝင်သော prompt များကို လိုက်နာရန် လမ်းညွှန်ချက်များဖြင့် လေ့ကျင့်ထားသည်၊ ဥပမာအားဖြင့် နိမိတ်ကို ဖြေကြားခြင်း သို့မဟုတ် ဓာတ်ပုံကို အဓိပ္ပါယ်ဖွင့်ဆိုခြင်း။ ရိုးရှင်းသော API ခေါ်ဆိုမှုများဖြင့် အသုံးပြုသူများသည် ယခုပုံရိပ် (ImageChunk အဖြစ်) နှင့် စာသားကို ထည့်သွင်း၍ ဘာသာစကားဖြေကြားမှုရနိုင်သည်[12]။ ဤသည်သည် ရှုမျက်နှာ-သတင်းအချက်အလက်များပါဝင်သော လုပ်ငန်းစဉ်များ ကို လွှမ်းခြုံနိုင်သည် - စခရင်ရှော့နှင့် ဇယားများကို ခွဲခြမ်းစိတ်ဖြာခြင်းမှ စ၍ မြင်မြင်သိသိ ပြောပြနိုင်သော ပေါင်းစပ်ကူညီသူများထိ။ အထူးသဖြင့်၊ Qwen3-VL မော်ဒယ်များကို ဒေတာထိရောက်စွာ ရှုမျက်နှာစွမ်းဆောင်ရည်များ ဖြင့် ဒီဇိုင်းပြုလုပ်ခဲ့သည်။ ဤကို ရှင်းပြရန်၊ Thinking Machines သည် 235B Qwen3-VL မော်ဒယ်ကို သမိုင်းဝင်ပုံရိပ် ခွဲခြားမှု လုပ်ငန်းများ (Caltech101, Oxford Flowers, စသည်တို့) အပေါ်တွင် LoRA adapters များဖြင့် ထိရောက်စွာ လေ့ကျင့်ထားသည်[13]။ ၎င်းတို့သည် ခွဲခြားမှုအတွက် လေ့ကျင့်သည့် ဒေတာအမျိုးမျိုးအပေါ်တွင် ကြီးမားသောရှုမျက်နှာ-အခြေခံ (DINOv2 ViT မော်ဒယ်နှင့် ခွဲခြားမှု ခေါင်း) နှင့် ၎င်း၏ စွမ်းဆောင်ရည်ကို နှိုင်းယှဉ်ခဲ့သည်[14]။

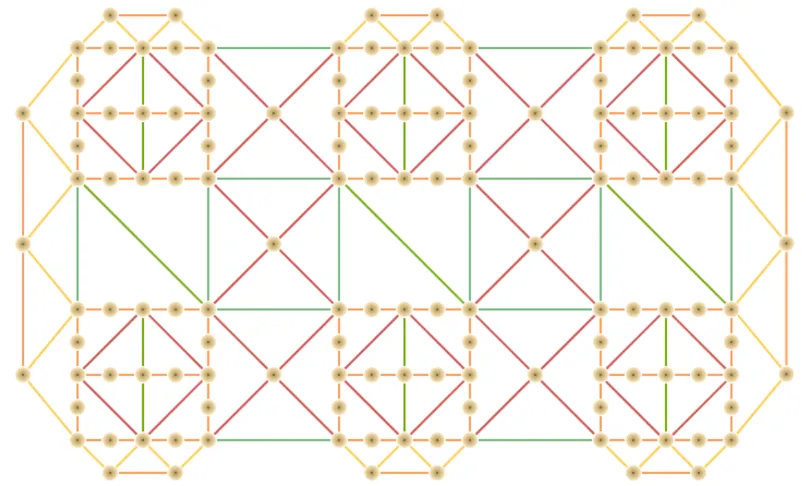

[15] Qwen3-VL-235B (မြင်ကွင်း-ဘာသာစကား မော်ဒယ်) နှင့် DINOv2 (မြင်ကွင်းသာ အခြေခံ) တို့ကို အနည်းငယ် သင်ကြားထားသော ပုံမှန် ခွဲခြားရေး လုပ်ငန်းများတွင် နှိုင်းယှဉ်ခြင်း။ Qwen3-VL သည် အနည်းငယ်သော အချက်အလက်များရှိသည့် အခြေအနေ (ဝဲဘက်အဝေး) တွင် ပိုမိုမြင့်မားသော တိကျမှုကို ရရှိသည်။ ၎င်း၏ ဘာသာစကားမှ သိမြင်သော မြင်ကွင်းနားလည်မှုကြောင့် ဖြစ်ပါသည်။

တစ်ခုချင်းစီအတွက် တစ်ခုတည်းသော ဥပမာနဲ့ပင် 235B Qwen3-VL မော်ဒယ်က လုံလောက်တဲ့ တိကျမှန်ကန်မှုကို ရရှိခဲ့ပြီး ဒီ အလွန်နည်းပါးတဲ့ ဒေတာအခြေအနေမှာ DINOv2 ကို အလွန်ကိုသာလွန်ခဲ့ပါတယ်[15]။ ဥပမာအရေအတွက် တိုးလာချိန်မှာ နှစ်ခုစလုံးက အဆင်ပြေသွားပေမယ့် Qwen3-VL က edge ရှိနေပြီး၊ နည်းနည်းသော ဥပမာနဲ့အတူ ပိုမိုခိုင်မာတဲ့ အထူးပြုစွမ်းရည်ကို ပြသခဲ့ပါတယ်[16]။ ဒီအားသာချက်က မော်ဒယ်ရဲ့ တည်ဆောက်ထားတဲ့ ဘာသာစကားနဲ့ ကမ္ဘာ့အသိပညာမှ လာတဲ့အကြောင်းဖြစ်ပြီး – ဥပမာ၊ Qwen3-VL က "ပန်းနွယ်" သို့မဟုတ် "ရွှေရောင်ရှီးရီးဗာ" ဘယ်လိုပြီးမဆိုရင် ကြည့်ရင်ဘယ်လိုဖြစ်တယ်ဆိုတာကို မျက်မှောက်အခြေအနေမှာ သိထားပြီးဖြစ်ပါတယ်[16]။ ဒါကတော့ အနည်းငယ်သော အသစ်တွေကို အသစ်တွေ့ရတဲ့ ရုပ်ပုံတွေကို မှတ်မိနိုင်ခြင်း သို့မဟုတ် အမျိုးအစားခွဲနိုင်ခြင်းကို တီထွင်နိုင်ပါတယ်ဆိုတာ ဖြစ်ပါတယ်။ လက်တွေ့အနေအထားမှာ Tinker ရဲ့ အသုံးပြုသူတွေက အလွန်နည်းပါးတဲ့ ဒေတာစာရင်းတွေနဲ့ မြင်နိုင်မှု ဒေတာလုပ်ငန်းတွေမှာ အမြင့်ဆုံး တိကျမှန်ကန်မှုကို ရရှိနိုင်ပါတယ်ဆိုတဲ့ အကြောင်းကို ဒီ vision-language မော်ဒယ်ကြီးတွေကို အသုံးပြုပြီး အလွန်အကျွမ်းကျင်တဲ့ vision စွမ်းဆောင်ရည်ကို ရရှိနိုင်ပါတယ်။ ဒါအပြင် အမှန်တကယ်ရှိတဲ့ အခြေအနေတွေမှာ မွန်းမံထားတဲ့ ဒေတာအနည်းငယ်တဲ့ နေရာမှာ အလွန်အရေးကြီးပါတယ်။ ဒါက "အထောက်အထားများမှ တွေးခေါ်မှု" နဲ့ပတ်သက်တဲ့ အာရုံခံရမှုကို ပြသနေပြီး၊ မော်ဒယ်က "မြင်လို့ရ" ထို့အပြင် အမြင်အာရုံနဲ့ ဘာသာစကားဆိုင်ရာအကြောင်းအရာတွေကို အသုံးပြုနိုင်ပါတယ်၊ ဒါဟာ ပိုမိုကျယ်ပြန့်တဲ့ အေးဂျင့် ဖြစ်စေပါတယ် (ဥပမာ၊ နိဒါန်းကို ဖတ်ပြီး ရှင်းပြခြင်း၊ သို့မဟုတ် အကြောင်းပြချက်တစ်ခုအနေနဲ့ ရုပ်ပုံကို အသုံးပြုခြင်း)။ အထူးသဖြင့် Qwen3-VL ကို Tinker ထဲသို့ ထည့်သွင်းခြင်းက စက်ရုပ်၏ အကန့်အသတ်ကို သန့်ရှင်းစင်ကြယ်တဲ့ စာသားမှ ရုပ်ပုံဒိုမိန်းထဲသို့ ချဲ့ထွင်ပြီး multi-modal reasoning workflows ကို တစ်ခုတည်းသော API အောက်မှာ အထောက်အထား ပြုလုပ်နိုင်စေပါတယ်။

Mind Lab၏အခြေအနေကိုသိရှိတတ်သောစနစ်များ: အတွေ့အကြုံမှကျင့်သုံးရသောဗဟုသုတ

သုတေသနဘက်မှာတော့ Mind Lab – Macaron AI နဲ့ဆက်စပ်တဲ့ နောက်ဆုံးခေတ်သုတေသနဌာန – က AI နည်းပညာတွေကို အမှန်တကယ် ဖြစ်တည်မှုအရ အကျွမ်းတဝင်ဖြစ်အောင် လုပ်ဆောင်နေပါတယ်။ Mind Lab ရဲ့ အဓိကကျတဲ့ယူဆချက်က “အမှန်တကယ်အသိဉာဏ်ဆိုတာ ပိုကြီးမားတဲ့ ကြိုတင်သင်ယူမှုကနေမလာဘဲ အမှန်တကယ် အတွေ့အကြုံကနေ လာရမယ်”[17] လို့ယူဆပါတယ်။ ဒါကြောင့်၊ ဆက်ပြောရရင်၊ ကုန်ကြမ်းဒေတာတွေကို သာ ရှည်လျားတဲ့ပုံစံနဲ့ မော်ဒယ်တွေကို တိုးချဲ့တာနဲ့ စုံလင်ခြင်းမရနိုင်ပါဘူး။ AI နည်းပညာရဲ့ နောက်အဆင့်က လူသားတွေလို အတွေ့အကြုံတွေ စုဆောင်းမှုအရ မကြာခဏ အပြန်အလှန် သင်ယူတဲ့ စနစ်တွေ ကနေ လာမှာပါ။ Mind Lab က ဒီမြင်ကွင်းကို အတွေ့အကြုံဆိုင်ရာ ဉာဏ်ပညာ လို့ အဓိပ္ပါယ်ထားပါတယ် – ရပ်တည်နေတဲ့ “ဉာဏ်ရည်” ကနေ အသွင်ပြောင်းနိုင်တဲ့ “စိတ်” တွေဖြစ်ဖို့ ရှေ့ဆက်ကြိုးစားနေပါတယ်။ အတွင်းပိုင်းကမ္ဘာ့မော်ဒယ်တွေကို ဖွဲ့စည်းနိုင်ပြီး အကြံပြန်သုံးစွဲမှုကနေ အသိပညာကို အဆက်မပြတ် အသစ်ပြောင်းလဲနိုင်တဲ့ ရည်ရွယ်ချက်တွေ သို့မဟုတ် တန်ဖိုးတွေကို ရှိစေပြီး ကိုယ့်လက်ဆောင်မှုကို ပြန်လည်တွေးခေါ်နိုင်တဲ့ ယခုလို လက်ရှိ LLMs တွေရဲ့ အခက်အခဲတွေကို ဖြေရှင်းဖို့ တိုက်ရိုက်တုံ့ပြန်မှုပါ။ အများအားဖြင့် အစွမ်းထက်ပေမယ့် ကြိုတင်သင်ယူမှုပြီးနောက်မှာ ရပ်တည်နေတဲ့ လက်ရှိ LLMs တွေရဲ့ အခက်အခဲတွေကို ဖြေရှင်းဖို့ တိုက်ရိုက်တုံ့ပြန်မှုပါ[18]။ အမှန်တကယ် အသွင်ပြောင်းမှုအတွက် အပြန်အလှန်အားဖြည့်သင်ယူမှု နဲ့ ဒိုင်နမစ်မွေးစားမှု စသော စနစ်တွေကို ထည့်သွင်းပေးခြင်းဖြင့် Mind Lab က အသုံးပြုမှုအရ တိုးတက်ပြောင်းလဲနေတဲ့ အေးဂျင့်တွေ ဖန်တီးဖို့ ရည်ရွယ်ပါတယ်။

Mind Lab ၏လုပ်ငန်း၏ အခြေခံသော အထွေထွေမှု နှစ်ခုမှာ (1) ဧရာမမော်ဒယ်များကို အသစ်သော အပြုအမူများဖြင့် ပြုပြင်ရန် ထိရောက်သော RL လေ့ကျင့်မှု နှင့် (2) အဆင့်မြင့်မှတ်ဥာဏ်စနစ်များ ဖြစ်ပြီး၊ ဤစနစ်များက အေးဂျင့်များကို ရေရှည်အသိပညာကို ထိန်းသိမ်းအသုံးပြုနိုင်စေသည်။ နှစ်ခုစလုံးသည် AI ကို ပိုမို အေးဂျင့်တဦး (ကိုယ့်အလိုရှိသလို ဆုံးဖြတ်ချက်ချခြင်းနှင့် တိုးတက်မှုများပြုလုပ်ခြင်း) ဖြစ်စေရန်နှင့် သုတေသနတိုးတက်မှုများကို ထုတ်ကုန်ဖြန့်ဝေရန်နှင့် ထပ်တူကျစေရန် ရည်ရွယ်ပါသည်။

LoRA အခြေခံသော တစ်ထရီလီယံ-ပါရာမီတာ RL ကို 10% GPU များဖြင့်

ဤအရာကို မည်သို့ အောင်မြင်ခဲ့သနည်း?

Mind Lab ရဲ့ ထိပ်တန်းအောင်မြင်မှုများထဲက တစ်ခုကတော့ trillion-parameter scale မှာ reinforcement learning ကို ပြသနိုင်ခြင်း ဖြစ်ပြီး အကောင်အထည်ဖော်ရာမှာ အကျိုးရှိပြီး စရိတ်သက်သာအောင် ပြုလုပ်နိုင်ခဲ့တာပါ။ 2025 ခုနှစ် ဒီဇင်ဘာလမှာ ၁.၀၄T-parameter Kimi K2 ရှုထောင်မှုမော်ဒယ်ပေါ်မှာ ပထမဆုံး end-to-end RL pipeline ကို ကြေညာခဲ့ပြီး၊ အဲဒီလေ့ကျင့်မှုအတွက် လိုအပ်မယ့် GPU အရင်းအမြစ်ရဲ့ အနည်းဆုံး ၁၀% နီးပါးသာ အသုံးပြုခဲ့ပါတယ်[19]။ ဒါကို ဘယ်လိုဖြစ်နိုင်ခဲ့တာလဲ? အဖွဲ့က parameter-efficient finetuning (LoRA) နဲ့ hybrid parallelism ကို မော်ဒယ်ရဲ့ Mixture-of-Experts ဖွဲ့စည်းပုံတစ်လျှောက် ရောစပ်အသုံးပြုပြီး အထူးပြုလေ့ကျင့်မှုအင်ဂျင်ကို တည်ဆောက်ခဲ့ပါတယ်[20][21]။

ထရီလီယံဝိတ်အားလုံးကိုပြင်ဆင်ခြင်းမပြုဘဲ Mind Lab ၏လမ်းကြောင်းသည် Kimi K2 ၏ရွေးချယ်ထားသော အလွှာများတွင် အနိမ့်တန်းသွေးဆောင်မှု matrix များကို ထည့်သွင်းပြီး၊ သုံးသပ်သူအလွှာတွင်လည်းဖြစ်ပါသည်။ RL[22] အတွင်း၌ အလွှာတစ်ခုချင်းစီတွင် အနည်းငယ် သို့မဟုတ် ရာချီ matrix အပြည့်အဝမဟုတ်သော LoRA အဆင့်နှင့် လေ့ကျင့်နိုင်သော အချိုးအစားကို သိသိသာသာ လျှော့ချပြီး၊ အမှတ်စဉ်နှင့် ကြိုတင်ပြင်ဆင်မှုကိုရှောင်ခြင်နိုင်သည်။ အချိန်တစ်ချိန်တည်းမှာပင်၊ ဒီအရွယ်အစားရှိတဲ့ မော်ဒယ်ကို လေ့ကျင့်ဖို့ဆိုရင် GPU အများအပြားကို ထိရောက်စွာ ဖြန့်ဝေဖို့လိုအပ်ပါတယ်။ အဖွဲ့က hybrid-parallel မဟာဗျူဟာ ကို အသုံးပြုခဲ့ပြီး၊ tensor parallelism, pipeline parallelism, expert parallelism (MoE အထူးကျွမ်းကျင်သူများအတွက်) နှင့် ရှည်လျားသော အချိုးအစား လေ့ကျင့်ခြင်းအတွက် အစီအစဉ် parallelism တို့ကို LoRA အသစ်များနှင့် သဟဇာတဖြစ်စေရန် လုပ်ဆောင်ခဲ့သည်[23]။ လက်တွေ့တွင် နောက်ဆုံးရရှိနိုင်သော ကြီးမားသော မော်ဒယ်လေ့ကျင့်ရေးဘလော့များကို (NVIDIA ၏ Megatron နှင့် ByteDance ၏ VolcEngine RL) အသုံးပြု၍၊ LoRA ကို MoE တွင် လုပ်ဆောင်နိုင်ရန် ပေါင်းစပ်၍၊ ကွန်ပျူတာကို 64 GPU များဖြင့် ချိန်ညှိခဲ့သည်[24]။ ရလဒ်မှာ Kimi K2 မော်ဒယ်အပြည့်ကို reward model နဲ့ အပြန်အလှန် ဖြေရှင်းမှု အရည်အသွေးကို ဖြည့်စွက်ပေးသော on-policy RL လေ့ကျင့်ခြင်းဖြစ်ပြီး၊ အများစု အဖွဲ့များအတွက် စရိတ်ကြောင့် မဖြစ်နိုင်ခဲ့သည်ဟု ယူဆရသည်။

အဓိကအချက်ကတော့ အဲဒါအောင်မြင်ခဲ့တယ်: LoRA-finetuned Kimi K2 က အလွန်ရှည်လျားတဲ့ အကြောပြောင်းလဲမှုလုပ်ငန်းများတွင် အရေးပါသော တိုးတက်မှုများကို ရရှိခဲ့ပြီး, သင်ခန်းစာခရီးစဉ်များသည် ပျော့ပျောင်းပြီး ချိုးဖောက်မှု မရှိခဲ့ပါ[25]။ အရေးပါသော အချက်မှာ, ပြောင်းလဲထားသော မော်ဒယ်သည် အခြေခံမော်ဒယ်၏ အထွေထွေကျွမ်းကျင်မှုများကို ထိန်းသိမ်းထားနိုင်ပြီး (အနည်းငယ်သော အလေးချိန်ပြောင်းလဲမှုများကြောင့်သာဖြစ်သည်)၊ လုပ်ငန်းသီးသန့်ကျွမ်းကျင်မှုအသစ်များကို ရရှိခဲ့ပါသည်[26]။ အခြေခံမော်ဒယ်၏ အကြီးစားမသေးမဖြစ်သော ပညာရှိမှုကို ဖျက်ဆီးခြင်းမရှိဘဲ၊ တိုးမြှင့်ခြင်းသာပြုလုပ်ခဲ့သည် - LoRA finetuning ၏ အဓိက အကျိုးကျေးဇူးဖြစ်သည်။ တကယ်တော့, Mind Lab ၏ စမ်းသပ်မှုများက ကြီးမားသော မော်ဒယ်များသည် RL အတွက် သင်ခန်းစာအခြေခံအနေနှင့် အားထားရသော အခြေခံအုတ်မြစ်ကို ပံ့ပိုးပေးသည် ဟု အတည်ပြုခဲ့သည်။ သတ်မှတ်ထားသော သင်ကြားမှု ဘတ်ဂျက်အောက်တွင်, ကြီးမားသော မော်ဒယ်နှင့် သေးငယ်သော LoRA အထူးပြုပြင်မှုများသည် လုံးဝပြောင်းလဲမှုဖြင့် သင်ကြားထားသော သေးငယ်သော မော်ဒယ်ထက် အလုပ်လုပ်နိုင်စွမ်းပိုမိုကောင်းမွန်ခဲ့သည်၊ ဒေသတွင်းလုပ်ငန်းများတွင်သာမက အသစ်သော လုပ်ငန်းများသို့လည်း ပြောင်းလဲခြင်း အထူးပြုပြင်မှုများဖြင့်[27]။ အဖွဲ့ကပြောသလို, RL က “အခြေခံပညာ အကန့်အသတ်ရှိသည်” - အခြေခံမော်ဒယ်က အရည်အသွေးမြင့် ခရီးစဉ်များကို စတင်မချည်းပြနိုင်ပါက, RL သည် အားကောင်းသော အချက်ပြရန် အလွန်နည်းပါးသည်[27]။ Kimi K2 ကဲ့သို့ အားကောင်းသော အကန့်အသတ်မရှိသော ဒေါင်းကြိုးပုံစံက RL ကို ချဉ်းကပ်မှုများကို ထိုးထွင်းအောင်မြင်စေပြီး, သေးငယ်သော မော်ဒယ်ကို အစအဆုံးပြန်လည်သင်ကြားမည်ဆိုလျှင် အလွန်ခက်ခဲသော ကျွမ်းကျင်မှုများကို ထပ်မံဖန်တီးရမည်ဖြစ်သည်။ ဤအမြင်သည် စာအုပ်တွင် ရှိသော ဉာဏ္ဍာရဏ်ကို ပြောင်းလဲစေသည် - ကြီးမားသော မော်ဒယ် (အားကောင်းသော အကန့်အသတ်နှင့် LoRA ထိရောက်မှုဖြင့်) ပေါ်တွင် RL ပြုလုပ်ခြင်းသည် သေးငယ်သော မော်ဒယ်ပေါ်တွင် RL ပြုလုပ်ခြင်းထက် ပိုမိုလျှော့ထားသော ကွန်ပျူတာ အင်အားကို အသုံးပြုနိုင်သည်[28]။ Mind Lab ၏ လှုပ်ရှားမှုသည် algorithm တစ်ခုတည်းမဟုတ်ပါဘဲ, အဆောက်အဦးနည်းလမ်း - ကြီးမားသော မော်ဒယ်များတွင် ဆက်လက်သင်ကြားမှုကို အလုပ်ဖြစ်အောင်ပြုလုပ်ခြင်းအတွက် အခြေခံအုတ်မြစ်ဖြစ်သည်။ သူတို့သည် သူတို့၏ နည်းလမ်းများကို မူပိုင်ခွင့်မရှိသော စီမံကိန်းများ (Megatron-Bridge, VERL) သို့ အထက်တန်းပေးပြီး, လူမှုအသိုင်းအဝိုင်းက ဤလုပ်ငန်းကို ထပ်မံပြုလုပ်၍ အခြေခံပညာနှင့် LoRA ထိရောက်မှုဖြင့် သုံးသပ်နိုင်ပြီး, အုပ်စုအများစုကို သင့်လျော်သော ဟာ့ဒ်ဝဲဘတ်ဂျက်များပေါ်တွင် ထရီလီယံဖြစ်သော နာရီသတ်မှတ်ထားသော အေးဂျင့်များကို ပြုပြင်ခြင်းဖြင့် အလုပ်ဖြစ်အောင် ပြုလုပ်နိုင်သည်[29]။

အမှတ်ဉာဏ်ပျံ့နှံ့မှု: Agent အမှတ်ဉာဏ်ကို Vector DB များအပြင်မှ ပြန်လည်စဉ်းစားခြင်း

အမှတ်ဉာဏ်ပျံ့နှံ့မှု အသက်ဝင်မှုကို ပြသခြင်း

Mind Lab ကလေ့လာနေသောနောက်ထပ်နယ်မြေတစ်ခုက AI ကိုယ်စားလှယ်တစ်ခုဟာ သူ့ရဲ့အကြောင်းအရာတွေနဲ့ ရေရှည်မှတ်ဉာဏ်ကို ကိုင်တွယ်နိုင်ဖို့ပဲ ဖြစ်ပါတယ်။ လက်ရှိစနစ်များစွာက အတိတ်စကားပြောအပိုင်းအစများကို ရှာဖွေရန်အတွက် ဗက်တာဒေတာဘေ့စ်ကို ပေါင်းစပ်သုံးခြင်း သို့မဟုတ် သမိုင်းကြောင်းကို တိုတောင်းစွာဖျော့ဖျပြီး နည်းလမ်းအသုံးပြုခြင်းဖြင့် အချက်အလက်တွေကို လျှော့ချပါတယ်။ Mind Lab က ပိုမိုပေါင်းစည်းထားတဲ့ “မော်ဒယ်-ဒေသခံ” မှတ်ဉာဏ် စနစ်တစ်ခုဖြစ်တဲ့ Memory Diffusion ကို ကမ်းလှမ်းပါတယ်။ ဒီအတွေးက ကိုယ်စားလှယ်ရဲ့ စကားဝိုင်းသို့မဟုတ် လမ်းကြောင်းရဲ့ အစဉ်အတိုင်း ပြင်ဆင်နိုင်သောမှတ်ဉာဏ် အဖြစ် ကိုင်တွယ်ရန်ဖြစ်ပြီး ဘယ်တော့မှ အပြင်မှာသိမ်းထားရန်မလိုဘူး။ Memory Diffusion က mask–allocate–refill loop နည်းလမ်းကို အသုံးပြုကာ အချိန်တိုင်းမှာ အကြောင်းအရာရဲ့ အရွယ်အစားကို ပြန်လည်ထိန်းသိမ်းနေပါတယ်။ အဆင့်တိုင်းမှာ မော်ဒယ်က ဘယ် token (အတိတ်စကားပြောအပိုင်းအစများ) ကို ထိန်းသိမ်းမလဲ (mask) ဘယ်ဟာကို ဖျက်မလဲဆိုတာဆုံးဖြတ်ပြီး၊ ပြီးတော့ လွတ်လပ်နေရာကို အသစ်ဖြစ်လာတဲ့အကြောင်းအရာနဲ့ ပြန်လည်ဖြည့်ဆည်းပါတယ် - အကြောင်းအရာအရှည်အတွက် token အခွင့်အရေးကို လေးစားစွာဖြင့်။ အဓိကအားဖြင့် မော်ဒယ်က သူ့ရဲ့ကိုယ်ပိုင်အကြောင်းအရာကို စီမံခန့်ခွဲရန်လေ့လာနေပြီး အရေးကြီးတဲ့အချက်အလက်များကို ထိန်းသိမ်းထားပြီး အရေးမပါသေးတဲ့အချက်အလက်များကို ဖျော့ဖျပြီး အသုံးပြုမှုအရ အမှတ်တရကို ဖျတ်ရှင်းသွားပါတယ်။ ဒါဟာ သတိရမှုကို ဇွတ်ဆံခြင်းနဲ့ ဆင်တူပါတယ်၊ ရည်မှန်းချက်က အရာအားလုံးကို အစဉ်အဆက်မှတ်မိတဲ့အစား (အကြောင်းအရာအရှည်ကန့်သတ်ချက်ကြောင့် မဖြစ်နိုင်ဘူး) တကယ့်ကန့်သတ်ချက်များအောက်မှာ အသုံးတည့်စွာ မှတ်မိဖို့ပဲ ဖြစ်ပါတယ်။

အမှတ်တရဖြစ်စဉ်အဆင့်တွင် လည်ပတ်ခြင်းအားဖြင့် Memory Diffusion သည် ပြင်ပ embedding များ သို့မဟုတ် အလားတူရှာဖွေမှုများ လိုအပ်ခြင်းကို ရှောင်ရှားနိုင်ပြီး၊ "အမှတ်တရ" သည် မော်ဒယ်၏ လည်ပတ်မှုအကြောင်းအရာနှင့် တူညီသော ကိုယ်စားပြု အာကာသတွင် ရှိနေသည်။ Mind Lab ၏ အစီရင်ခံမှုအရ၊ ဤနည်းလမ်းသည် state-of-the-art အလွှာတစ်လျှောက် အမှတ်တရ စွမ်းဆောင်ရည်ကို ရရှိစေပြီး၊ အေးဂျင့်သည် ကြာရှည်စကားဝိုင်းများ သို့မဟုတ် တာဝန်များကို ပတ်သက်သော အချက်များကို မဆုံးရှုံးဘဲ ဆောင်ရွက်နိုင်သည်ဟု ဆိုသည်။ ဤနည်းလမ်းသည် အခြေအနေ အရွယ်အစားနှင့် ဆက်စပ်သော အချိန်အမြဲတမ်း ကို လည်ပတ်ပြီး၊ အကြောင်းအရာအရှည်သည် မျက်နှာဖုံး/ပြန်ဖြည့်မှု စစ်ဆေးမှုများအားဖြင့် အမြဲတမ်းနှင့် စီမံထားသောကြောင့် အကြောင်းအရာကြာချိန်ကြီးလာသည်နှင့်အမျှ ပြန်လည်ရယူမှုကုန်ကျစရိတ် မတိုးပွားခြင်း ဖြစ်သည်။ အလေ့အကျင့်အရ၊ Memory Diffusion ပါသော အေးဂျင့်သည် စကားဝိုင်းများကို ထောင်ချီသော အကြိမ်ရေများအထိ ပါဝင်နိုင်ပြီး၊ အချက်အလက်အားလုံးကို ထိန်းသိမ်းထားမရနိုင်သော်လည်း မိမိအတွင်းရှိ ဂရုစိုက်မှုအပိုင်းကို ဆုံးဖြတ်လိမ့်မည်။ အသုံးပြုသူ၏ အရေးကြီးသော စိတ်ကြိုက်များ သို့မဟုတ် ဖြေရှင်းရန်မလိုအပ်သော မေးခွန်းများသည် ရှင်သန်နေပြီး၊ အလေးမထားသော စကားဝိုင်းများအားလုံးကို စနစ်တကျ ဖြတ်တောက်နိုင်သည်။ ဤနည်းလမ်းသည် အမှတ်တရကို မော်ဒယ်၏ သဘောတရား၏ ပထမတန်းစား အစိတ်အပိုင်း အဖြစ် ဆက်ဆံခြင်းဖြစ်ပြီး၊ အမှတ်တရကို စနစ်၏ ပျက်စီးမှုအချက်အဖြစ်မဟုတ်ဘဲ လေ့လာမှုအပိုင်းအဖြစ် အရေးကြီးစေရန် Mind Lab ၏ အမြင်နှင့် ကိုက်ညီသည်။

ကျွန်ုပ်တို့၏ နည်းပညာဘလော့ဂ်တွင် ဆက်ဖတ်ပါ

သုတေသန–ထုတ်ကုန် ပူးတွဲဒီဇိုင်း: မရပ်မနား သင်ယူမှုလည်ပတ်မှု

Tinker ၏ အခြေခံဖွဲ့စည်းမှုနှင့် Mind Lab ၏ အယ်လ်ဂိုရီသမ် ထိရောက်မှုများသည် သဘာဝပေါင်းစပ်မှုတစ်ခုဖြစ်သည်။ Tinker သည် Mind Lab ၏ ရောနှော LoRA RL ကို Kimi K2 နှင့် Qwen3-VL တွင် တိုက်ရိုက်အသုံးချနိုင်စေရန် အထောက်အပံ့ပေးပါသည်၊ မျိုးစုံမီဒီယာ အေးဂျင့် လည်ပတ်မှုများကို လွယ်ကူစွာ အဆင့်မြှင့်တင်သည်။

သုတေသန-ထုတ်ကုန် ပူးတွဲဒီဇိုင်းတွင်—Mind Lab ၏ အဓိကကိုယ်စားပြုချက်—ဤသည်မှာ အဖြစ်အပျက်များအနေဖြင့် အသွင်ပြောင်းသည်။

- တုန့်ပြန်မှု အတွက် ကိရိယာများ: တင်ကာမှ ၀န်ဆောင်မှုပြုသော မော်ဒယ်များမှ စွဲကြိုးထားသော အေးဂျင့်များသည် အသုံးပြုသူ အပြုအမူများ၊ ကိရိယာရလဒ်များနှင့် ပြင်ဆင်ချက်များမှ တည်ဆောက်ထားသော အပိုင်းများကို ဖန်တီးသည်။

- အွန်လိုင်း RL ပိုက်လိုင်းများ: ရောနှော လှိုဏ်ကူးမှုသည် တိုက်ရိုက်အချက်အလက်များပေါ်တွင် မရပ်မနား အဆင့်မြှင့်တင်မှုများကို ပံ့ပိုးပေးပြီး အော့ဖ်လိုင်း အစုလိုက်ထုတ်လုပ်မှု မလိုဘဲ တန်ဖိုးအလုပ်အမှုများနှင့် မူဝါဒများကို တိုးတက်စေသည်။

- မျိုးစုံမီဒီယာ လျော်ကန်မှု: မျက်မြင်အဝင်များသည် ရူပဗေဒဆိုင်ရာ လုပ်ငန်းများတွင် RL ကို ခွင့်ပြုပြီး GUI လမ်းညွှန်မှု၊ စာရွက်စာတမ်း နားလည်မှု သို့မဟုတ် ရူပဗေဒဆိုင်ရာ အခွင့်အလမ်းများကို အဆင့်မြှင့်တင်သည်။

- လုံခြုံမှုနှင့် တည်ငြိမ်မှု: တည်နေရာတူ အပြန်အလှန်ဖြစ်မှုများသည် ဖြန့်ချိမှု အပြောင်းအလဲကို လျှော့နည်းစေပြီး Mind Lab ၏ HTML အလှဆင်မှု ဥပမာအတိုင်း ဆုလာဘ် ခိုးယူမှုကို တားဆီးသော ဆုလာဘ်များကို စီးဆင်းစေသည်။

မဟာဗျူဟာအရ၊ ဤ ပုံစံသည် အဆင့်မြှင့်တင်မှုကို လျင်မြန်စေသည်: ထုတ်ကုန်များသည် စမ်းသပ်မှု အစမ်းသပ်မှုအဖြစ်သို့ ပြောင်းလဲလာပြီး သုတေသန အကြံပြုချက်များကို ပြန်လည်တိကျစေသော မြင့်မားသောအသေးစိတ်အချက်အလက်များကို ထုတ်လုပ်သည်။ ဥပမာ၊ Tinker မှ ရရှိသော အနည်းငယ်သော ရူပဗေဒ ခွဲခြားမှုသည် တင်ထားသော ရူပဗေဒအေးဂျင့်များတွင် RL ရည်ရွယ်ချက်များကို စိုက်ထူနိုင်ပြီး အသုံးပြုသူ နှစ်သက်မှုများနှင့် လိုက်လျောညီထွေဖြစ်သော ရူပဗေဒ မူဝါဒများကို အဆင့်မြှင့်တင်သည်။

ရိုးရာအားဖြင့် AI သုတေသနသည် မော်ဒယ် သို့မဟုတ် အယ်လဂိုရစ်သမ်တစ်ခုကို ထုတ်လုပ်ပြီးနောက် ထုတ်ကုန်အဖွဲ့သည် ၎င်းကို မည်သို့တပ်ဆင်ရမည်ကို သီးခြားစီ တွေးဆသည်၊ နှစ်ခုအကြား အလျင်မြန်ဆုံးပြန်လည်ပြုပြင်မှုဖြစ်ပါသည်။ Mind Lab သည် သုတေသန-ထုတ်ကုန် ပူးပေါင်းဒီဇိုင်း၏ အတွေးအခေါ်ကို လုပ်ဆောင်သည်။ အသစ်သောနည်းလမ်းတိုင်းကို အမြန်ဆုံး ပရိုဂရမ်ဇာတ်ကောင်တွင် စမ်းသပ်ပြီး အသုံးပြုသူ၏ အပြုအမူမှ ဒေတာကို ရရှိကာ သုတေသနကို ပြုပြင်ရန် အသုံးပြုပါသည်။

"သုတေသနနှင့် ထုတ်ကုန်သည် သီးခြားလမ်းကြောင်းများမဟုတ်တော့ပါ။ ၎င်းတို့သည် အပြန်အလှန်တုံ့ပြန်မှုလမ်းကြောင်းဖြစ်သည် - အသုံးပြုသူ၏ အတွေ့အကြုံ → ဒေတာ → RL လေ့ကျင့်ခြင်း → တပ်ဆင်ခြင်း → ပိုမိုကောင်းမွန်သော UX → ပိုမိုကြွယ်ဝသောဒေတာ → ထပ်ခါတလဲလဲ။" လက်တွေ့အနေနှင့်၊ Mind Lab သည် ၎င်းတို့၏ RL အယ်လဂိုရစ်သမ် သို့မဟုတ် မှတ်ဉာဏ်စနစ်ကို တိုးတက်အောင်လုပ်သောအခါ၊ ၎င်းကို Macaron ၏ ကိုယ်ပိုင် AI အကူအညီကဲ့သို့ အသုံးပြုသူသို့ ရင်ဆိုင်သော ပရိုဂရမ်ဇာတ်ကောင်တစ်ခုတွင် ပေါင်းစည်းကာ အဖြစ်အပျက်များကို စောင့်ကြည့်ပါသည်။ အသုံးပြုသူတို့မေးသောမေးခွန်းများ၊ အောင်မြင်မှု သို့မဟုတ် မအောင်မြင်မှုရှိသောနေရာများ၊ တိုက်ရိုက်တုံ့ပြန်မှုများကို အသုံးပြု၍ နောက်ထပ်မော်ဒယ် အပ်ဒိတ်အတွက် လေ့ကျင့်မှုအချက်အလက်အဖြစ် နောက်ပြန်ထည့်သွင်းသည်။ ၎င်းသို့ပြန်လှန်မှုက Learning ကို အလျင်မြန်ဆုံးဖြစ်စေသည်။ ထုတ်ကုန်သည် စမ်းသပ်မှုဖြစ်ပါသည်။

သင်္ကေတတစ်ခုမှာ စီးဆင်းမှုဆုလာဘ်မော်ဒယ်များနှင့် အွန်လိုင်း RLHF (လူသားတုံ့ပြန်မှုမှ အတည်ပြုမှုသင်ယူခြင်း) အသုံးပြုခြင်းဖြစ်သည်။ လူသားနှစ်သက်မှုနှိုင်းယှဉ်မှုများ၏ အတည်ပြုမှုဒေတာသီးသန့်စုဆောင်း၍ ဆုလာဘ်မော်ဒယ်တစ်ခုကို တစ်ကြိမ်သာလေ့ကျင့်ခြင်းအစား၊ Mind Lab ၏ ဖွဲ့စည်းမှုပုံစံမှာ အသုံးပြုမှုအတွင်းအကြောင်းပြန်လည်သုံးသပ်မှုအသစ်များရလာသည့်အခါ ဆုလာဘ်မော်ဒယ်ကို အဆက်မပြတ်အပ်ဒိတ်လုပ်ရန် ရည်ရွယ်ထားသည်။ ဥပမာအားဖြင့်၊ အေးဂျင့်တစ်ခုသည် အသုံးပြုသူများအတွက် အလုပ်များကို ဖြေရှင်းနေပြီး အခါအားလျော်စွာ အငြင်းပွါးချက် သို့မဟုတ် ပြင်ဆင်ချက်များရရှိလာပါက၊ ၎င်းအချက်ပြများကို ဆုလာဘ်မော်ဒယ်ထဲသို့ စီးဆင်းသွားစေပြီး "ကောင်းသော" အပြုအမူ၏ အယူအဆကို အချိန်နှင့်တပြေးညီ ပြုပြင်ပေးနိုင်သည်။ နောက်တစ်ကြိမ် RL ကို အလုပ်လုပ်သည့်အခါ (၎င်းသည် စီစဉ်ထားသော ကာလအတွင်း သို့မဟုတ် ထိုင်းချိန်မဟုတ်စွာလည်းဖြစ်နိုင်သည်)၊ အပ်ဒိတ်လုပ်ထားသော ဆုလာဘ်မော်ဒယ်သည် မူဝါဒကို အသုံးပြုသူနှစ်သက်မှုများနှင့် ပိုမိုကိုက်ညီစေရန် လမ်းညွှန်ပေးသည်။ ဤ စီးဆင်းမှု RL ပုံစံသည် အသုံးပြုမှုကို လေ့ကျင့်မှု၏ တိုးချဲ့မှုအဖြစ်ပြောင်းလဲစေသည် - အေးဂျင့်သည် အပြင်မကျက်မှာ အချိန်ကြာကြာ လည်ပတ်သည့်အခါ အတွေ့အကြုံများ ပိုမိုစုဆောင်းပြီး ပိုမိုကောင်းမွန်လာသည်။ Tinker မှ ပံ့ပိုးပေးသော OpenAI အညီအမျှမျက်နှာသစ်သည် ဤမဟာဗျူဟာကို တကယ်ပေါင်းစပ်ပေးသည် - ၎င်းသည် အဆက်မပြတ်လေ့လာထားသော မော်ဒယ်များကို တပ်ဆင်ထားသော ထုတ်ကုန်များနှင့် ကိရိယာများထဲသို့ ပိုမိုလွယ်ကူစွာ ထည့်နိုင်စေသည်၊ ၎င်းအားဖြင့် သုတေသနဌာနသည် ထုတ်ကုန်သို့ မော်ဒယ်ဗားရှင်းအသစ်များကို မြန်မြန်ဆန်ဆန် ထုတ်နိုင်ပြီး ရလဒ်များကို စောင့်ကြည့်နိုင်သည်၊ တစ်ကြိမ်စီရဲ့ အစုန်းအထင်းကို ပြန်လည်ပြုလုပ်ရန် မလိုအပ်ပဲဖြစ်သည်။

Tinker ၏ဘက်မှ ကြားလေ့လာမှုများနှင့်အတူ မော်ဒယ်မှ အလယ်ပိုင်းသင်ယူမှုမှ နမူနာယူနိုင်သော ပလက်ဖောင်း၏စွမ်းရည်သည် အတွင်းစိတ်ထွက်ရှိခြင်းများကို ဖျော်ဖြေရန်နှင့် အနုစိတ်ညှိနှိုင်းမှုဆုံးဖြတ်ချက်များကို လုပ်ဆောင်နိုင်စေသည်။ Mind Lab ၏ဘက်မှ, သူတို့၏တီထွင်မှုများ (ဥပမာ trillion-scale RL သို့မဟုတ် memory diffusion) ကို အမှန်တကယ်အသုံးပြုမှုများတွင် စမ်းသပ်မှုခံစားရစေရန် ပူးတွဲဒီဇိုင်းလည်ပတ်မှုသည် အထောက်အကူဖြစ်စေသည်။ ဤနည်းလမ်းသည် လက်တွေ့ကျသောစိန်ခေါ်မှုများကို စောစောစီဖော်ထုတ်ပေးပြီး (ဥပမာ latency သို့မဟုတ် မထင်မှတ်ထားသောအသုံးပြုသူထည့်သွင်းမှုများကို မည်သို့ကိုင်တွယ်မည်) နောက်ဆုံးပေါ်သုတေသနနှင့် အသုံးပြုသူကိုရောစပ်ထားသော AI ထုတ်ကုန်များအကြားကွာဟချက်ကိုပိတ်ပင်ပေးသည်။ မဟာဗျူဟာအကျိုးဖြစ်ထွန်းမှုသည် အကောင်အထည်ဖော်မှုများကို အမှန်တကယ်အသုံးပြုမှု၏လိုအပ်ချက်များဖြင့် ကြိုးပမ်းပြီး အမှန်တကယ်အသုံးပြုမှုနှင့်တိုက်ရိုက်စစ်ဆေးခြင်းဖြင့် အတည်ပြုသည်။ Mind Lab ၏အထောက်အထားများအရ, တိုးတက်မှုဖြစ်စဉ်သည် "အသုံးပြုသူနှင့်ထုတ်ကုန်အပြန်အလှန်လက်တွေ့လေ့လာမှု"မှရရှိနိုင်ခြင်းဖြစ်ပြီး, နေရာအခြေပြု၍ လိုက်လျောညီထွေဖြစ်သောအေးဂျင့်သည် deployment မှာတည်နေရာချထားသောအေးဂျင့်ထက် ပိုမိုကောင်းမွန်သောအသုံးပြုသူအတွေ့အကြုံကိုပေးစွမ်းနိုင်သည်။

အေးဂျင့် AI နှင့် အနာဂတ် ပူးတွဲဒီဇိုင်းစနစ်များအတွက် အကျိုးသက်ရောက်မှုများ

Tinker နှင့် Mind Lab မှတိုးတက်မှုများကိုစုစည်းပြီး, AI စနစ်များကို တည်ဆောက်နည်းတွင် အလွန်တရားသောပြောင်းလဲမှုကို ဖော်ပြထားသည် – တည်ငြိမ်သောမော်ဒယ်များမှ ပတ်ဝန်းကျင်နှင့် ပူးတွဲဒီဇိုင်းလုပ်ဆောင်သော လိုက်လျောညီထွေသောအေးဂျင့်များသို့။ အဓိကအကျိုးသက်ရောက်မှုအချို့ကို ဖော်ထုတ်ရသည်။

- *အခြေခံပုံစံများမှ အခြေခံ ကိုယ်စားလှယ်များသို့: စွမ်းရည်ပြည့်ဝသော ပုံစံများဖြစ်သော Kimi K2 (ကိရိယာအသုံးပြုခြင်းနှင့် အကြောင်းပြချက်ရှာဖွေခြင်းတို့ကို ပေါင်းစပ်ထားခြင်း) တို့နှင့် ၎င်းတို့ကို အဆက်မပြတ် တိုးတက်အောင် ပြုပြင်ခြင်းဆိုင်ရာ နည်းလမ်းများဖြင့် တွဲဖက်ပြီး များမကြာမီတွင် ကြီးမားသော ဘာသာစကားပုံစံများသည် အသိပညာ မဟုတ်ပဲ အပြုအမူ အတွက် နေရာများဖြစ်လာသည်ကို ဖျော်ဖြေရန် ဖြစ်လာသည်။ တစ်ကြိမ်သာလျှင် ကြိုးစားပြင်ဆင်ထားသော ပုံစံများကို ယူပြီး ပုံစံကို ယခင်ကဲ့သို့ မဟုတ်ဘဲ အပြုအမူများကို စီစဉ်ခြင်း၊ လုပ်ဆောင်ခြင်းနှင့် တုံ့ပြန်ခြင်းများကို လုပ်နိုင်သော အခြေခံပုံစံများရရှိသည်။ ဒါက AI ပုံစံနဲ့ AI ထုတ်ကုန်ကြားက နယ်နိမိတ်ကို ဖျတ်ကြီးစေပြီး ပုံစံသည် များပြားစွာ ကိုယ်စားလှယ် ဖြစ်လာသည်။ ၎င်းကို အဆင့်မြင့်အောင် ပြုလုပ်ရန် **ပုံစံကို အခြေခံသော သုတေသန (သစ်လွင်သော ပုံစံများ၊ လေ့လာမှုနည်းလမ်းများ) နှင့် **ထုတ်ကုန်ကို အခြေခံသော ထင်မြင်ချက်များ (အသုံးပြုသူအတွေ့အကြုံ၊ တင်သွင်းမှုကန့်သတ်ချက်များ) တို့ကို တစ်ခုတည်းသော ဖွံ့ဖြိုးရေးလုပ်ငန်းစဉ်တွင် ပေါင်းစပ်ရန် လိုအပ်သည်။

- ကိရိယာအသုံးပြုခြင်းအတွေးအခေါ်များအဖြစ် အစဉ်အလာဖြစ်လာခြင်း: Tinker ၏ OpenAI ကိုက်ညီသော အင်တာဖေ့စ်နှင့် ကိရိယာအသုံးပြုခြင်းအတွက် အထူးသဖြင့် တည်ဆောက်ထားသော ပုံစံများကို အသုံးပြု၍ AI ကိုယ်စားလှယ်များသည် အပြင်ပဏင်္ဂတွင် ကိရိယာများ၊ API များ၊ ဒေတာဘေ့စ်များကို အနားယူရန် လိုအပ်သောအခါတွင် တစ်စိတ်တစ်ပိုင်းအဖြစ် အသုံးပြုနိုင်သည်ကို ကြိုတင်မြင်နိုင်သည်။ Kimi K2 ၏ ဒီဇိုင်းနှင့် Mind Lab ၏ ကိုယ်စားလှယ်ဆိုင်ရာ စမ်းသပ်မှုများသည် အရှုပ်ထွေးသော တာဝန်များကို ဖြေရှင်းရန် AI ကို ကိရိယာများကို သွားရောက်မေးမြန်းရန် သို့မဟုတ် ပတ်ဝန်းကျင်များကို အတုယူရန် လိုအပ်သော အဖြစ် ဖော်ပြသည်။ အနာဂတ်စနစ်များသည် များမကြာမီ အခြေခံပုံစံ၏ လေ့လာမှုအတွင်း ကိရိယာ API များကို စိမ်းလန်းနေသောအခါတွင် ပေါင်းစပ်ရန် အခြေခံပုံစံ၏ အတွေးအခေါ်တွင် ကိရိယာ API များကို ပေါင်းစပ်ရန် ဖြစ်နိုင်သည်။ ဤသည်သည် AI ကိုယ်စားလှယ်များသည် အထီးကျန်သော ပုံစံတစ်ခုထက် ပို၍ လုပ်ဆောင်နိုင်သည်ဟု ရည်ညွှန်းသည်။ ၎င်းသည် အလုပ်ပိုင်းဆိုင်ရာ ကိရိယာပလက်ဖောင်းများ ဖြစ်လာပြီး AI ပုံစံသည် အင်္ဂါရပ်တစ်ခုအဖြစ် နေရာယူပြီး ကိရိယာများကို အသုံးပြုရန် အချိန်နှင့် နည်းလမ်းကို သိရှိသည်။

- အခြေခံပြုခြင်းနှင့် ပုဂ္ဂိုလ်ရေး AI: Memory Diffusion ကဲ့သို့သော မှတ်ဉာဏ်ဆိုင်ရာ တီထွင်မှုများသည် AI ကို အလျင်အမြန် အစဉ်အဆက် မပြတ်သော အခြေအနေ ကို ထိန်းသိမ်းနိုင်စေသည်ကို ဖော်ပြသည်။ တစ်ခုချင်းစီ၏ အခန်းကဏ္ဍမှ သီးခြားထားခြင်းမရှိဘဲ အနာဂတ်ကိုယ်စားလှယ်များသည် ယခင်က အတွေ့အကြုံများ၊ ကွာဟမှုများနှင့် ပတ်ဝန်းကျင်များကို လေ့လာရေးအရ မွေးစားနိုင်မည်။ ၎င်းသည် ပိုမို ပုဂ္ဂိုလ်ရေးနှင့် အခြေအနေကို သိရှိသော AI အကူအညီများ ကို ဖန်တီးသွားမည်ဖြစ်ပြီး အကြောင်းတရားများကို အားလုံးသိရှိပြီး စကားဝိုင်းအဖြစ် ခံစားမှုပိုမို ဖြစ်လာမည်။

- အလွှာနှစ်ခု ပါဝင်သော အခြေခံအဆောက်အအုံအဖြစ် ပြိုင်ဆိုင်မှုအားသာချက်: ဤစီမံကိန်းများမှ အခြေခံအဆောက်အအုံ – ဥပမာ: အမျိုးအစားနှစ်ခုဖြစ်သော ပျော်ရွှင်မှု၊ LoRA-on-MoE၊ ဖြန့်ဝေထားသော RL – သည် AI ဖွံ့ဖြိုးရေးအဖွဲ့များ အတွက် ပြောင်းလဲမှုဖြစ်လာမည်။ အဖွဲ့များသည် ဤနည်းလမ်းများကို လက်ခံယူပြီး အပြိုင်အဆိုင်သော ကြီးမားသော ပုံစံများကို ကြားဖြတ်လုပ်ဆောင်နိုင်မည်ဖြစ်သည်။ ဤကဲ့သို့ AI ကိုယ်စားလှယ်များကို တီထွင်ရန် အခက်အခဲများကို လျှော့ချပြီး စိတ်ကြိုက်ထုတ်ကုန်များကို ဖန်တီးနိုင်မည်ဖြစ်သည်။

- ဆက်လက်လေ့လာခြင်းနှင့် လူ- AI အပြန်အလှန်ဆက်သွယ်မှု: နောက်ဆုံးတွင် ပိတ်လှောင်ထားသောလေ့လာမှုစနစ်၏ အယူအဆသည် AI ကမ္ဘာပေါ်တွင် အသုံးပြုသူ၏ အခန်းကဏ္ဍကို ပြောင်းလဲစေသည်။ အသုံးပြုသူ၏ အပြန်အလှန်ဆက်သွယ်မှုများသည် လေ့လာမှုဥပမာအဖြစ် ဖြစ်လာနိုင်ပြီး ထုတ်ဝေမှုတိုင်းသည် စမ်းသပ်မှုဖြစ်လာနိုင်သည်။ လက်တွေ့အနေနှင့် ဤကဲ့သို့ AI ၀န်ဆောင်မှုများသည် ညနေခင်းအချိန်တွင် ပိုမို သတင်းသွင်းသည့် နိဒါန်းပြုခြင်း ဖြစ်လာနိုင်သည်။ သို့သော် ၎င်းသည် အကဲဖြတ်ခြင်းနှင့် လုံခြုံရေး၏ ပူးတွဲဒီဇိုင်းကို ဂရုစိုက်စေရန် လိုအပ်သည်။ ကိုယ်စားလှယ်တစ်ခုသည် ၎င်း၏ အပြန်အလှန်ဆက်သွယ်မှုများမှ လေ့လာနေသည်ဆိုပါက၊ ၎င်းသည် မှန်ကန်သော သင်ခန်းစာများကို လေ့လာနိုင်ရန် အားကောင်းသော အကျိုးဆက်ပုံစံများနှင့် ကန့်သတ်ချက်များကို လိုအပ်သည်။

ကိုယ်စားပြုစိတ်များဆီသို့: အဆုံးသတ်အမြင်

အတိအကျပြောရလျှင် အတည်ပြုပြီးသောအရွယ်အစားစံချိန်များသည် တည်ငြိမ်ပြုနေသော်လည်း Tinker ၏ လွယ်ကူသော တရားဝင်အပြောင်းအလဲ အတူ Mind Lab ၏ ထိရောက်သော အတွေ့အကြုံအခြေပြု reinforcement learning သည် ပြောင်းလဲမှုနောက်ခံခေတ်တစ်ခုကို ကြိုဆိုသည်။ ထုတ်ကုန်လည်ပတ်မှုတွင် ကိုက်ညီမှုကို ပေါင်းစပ်ခြင်းဖြင့် ကျွန်ုပ်တို့သည် ခိုင်ခံ့သော ဦးနှောက်များကို ကျော်လွန်ပြီး ပတ်ဝန်းကျင်နှင့် အပြန်အလှန်ကြီးထွားသော စနစ်များသို့ ရောက်ရှိသည်။ ဤပူးပေါင်းဖွံ့ဖြိုးမှုလမ်းကြောင်းသည် လူ့လိုအပ်ချက်များနှင့် အမှန်တကယ်ကမ္ဘာ၏ ရှုပ်ထွေးမှုများကို ဆက်လက်ကျင့်ကောင်းသော AI ကို ကတိပေးသည်။

[1] [34] [35] [36] [2507.20534] Kimi K2: Open Agentic Intelligence

https://ar5iv.labs.arxiv.org/html/2507.20534

[2] [3] [8] [9] Tinker - Thinking Machines Lab

https://thinkingmachines.ai/tinker/

[4] [5] [6] [10] [11] [12] [13] [14] [15] [16] Tinker: အထွေထွေ ရရှိနိုင်မှုနှင့် မြင်သာသော အထည့်သွင်းမှု - Thinking Machines Lab

https://thinkingmachines.ai/blog/tinker-general-availability/

[7] [20] [21] [22] [23] [24] [25] [26] [27] [28] [37] ၁၀% GPUs နဲ့ Trillion Parameter Reasoning RL ကိုဘယ်လိုတည်ဆောက်ကြမလဲ

[17] [30] [33] Macaron AI | LinkedIn

https://www.linkedin.com/company/macaronaiofficial

[18] [19] [29] [31] [32] Mind Lab ကိုမိတ်ဆက်ခြင်း — Macaron AI ၏သုတေသနဌာန