May-akda: Boxu Li

Panimula: Ang Paningin bilang Isang Compression Layer para sa LLMs

Matagal nang problema ang pagproseso ng mahabang konteksto para sa mga modelo ng wika – kapag pinakain mo ang isang transformer ng dokumentong may 100K-token, makakaranas ka ng pagkaantala, sobrang paggamit ng memorya, o mataas na halaga ng API. Ang tradisyunal na mga dense large language models (LLMs) ay hindi talaga dinisenyo para sa epektibong pagproseso ng mga input na kasinghaba ng libro. Dito pumapasok ang DeepSeek-OCR 3B, isang bagong open-source Mixture-of-Experts (MoE) model na gumagamit ng radikal na naiibang pamamaraan: ito ay gumagamit ng visual perception bilang compression medium para sa teksto[1][2]. Sa halip na direktang iproseso ang libu-libong text tokens, ginagawa ng DeepSeek na mga imahe ang mga pahina at hinahayaan ang vision-language pipeline na buuin muli ang teksto. Ang teknik na ito, na tinatawag na Context Optical Compression, ay nagpapahintulot sa modelo na ipasok ang higit pang impormasyon sa mas kaunting tokens[2][3]. Nangangako ang DeepSeek-OCR ng hanggang 7–20× token reduction na may minimal na pagkawala ng katumpakan[4][5], na nag-e-enable ng scalable ultra-long document parsing sa standard na hardware. Mahalaga, ang modelo ay ganap na open-source (inilabas sa Hugging Face at GitHub) sa ilalim ng isang permissive na lisensya, na ginagawang accessible sa lahat ang advanced na OCR capabilities[6][7]. Sa post na ito, susuriin natin ang arkitektura at pagsasanay ng DeepSeek-OCR, ihahambing ito sa tradisyunal na dense LLMs at mga closed-source OCR services, at tuklasin kung ano ang ibig sabihin ng paglabas nito para sa mga developer at sa open-source na direksyon ng industriya.

Pagbubuwag ng Arkitektura: MoE Decoder Nakikilala ang Vision Encoder

Dalawang Yugto ng Disenyong Paningin-Wika. Ang DeepSeek-OCR ay binuo bilang isang sistema na may dalawang bahagi: isang visual encoder na tinatawag na DeepEncoder at isang text decoder na tinatawag na DeepSeek-3B-MoE-A570M[8]. Ang DeepEncoder (≈380M params) ay kumukuha ng larawan ng pahina ng dokumento at nagbibigay ng maikling pagkakasunod-sunod ng “mga vision token.” Ang mga token na ito ay ipinapasok sa DeepSeek-3B-MoE decoder, na bumubuo ng nilalaman ng teksto. Ang paghahating ito ay hindi katulad ng tradisyonal na dense LLM (na magpoproseso ng text input mula umpisa hanggang dulo) – dito ang masusing gawain ng pag-unawa sa layout ng pahina at visual na teksto ay ginagawa ng encoder, na nagbibigay-daan sa decoder na mag-operate sa mas maikling pagkakasunod-sunod[2][3].

Compression sa pamamagitan ng Vision Encoding. Ang encoder ay kung saan matatagpuan ang marami sa mga inobasyon. Ito ay idinisenyo upang mahusay na hawakan ang mga high-resolution na pahina at i-compress ang mga ito ng higit pa. Paano? Pinagsasama ng DeepEncoder ang maraming bahagi: (1) isang lokal na vision module na nakabase sa SAM-base (Segment Anything Model) para sa detalyadong pagpersepsyon, gamit ang windowed attention upang masuri ang maliliit na rehiyon; (2) isang 16× convolutional downsampler na malaki ang binabawas sa bilang ng mga token ng imahe (hal. 4096 patch tokens pababa sa 256); at (3) isang global vision module na nakabase sa CLIP-large para sa kabuuang pag-intindi ng imahe gamit ang dense attention. Sa praktika, ang isang buong 1024×1024 na dokumento ng imahe ay maaring i-encode sa kakaunti lamang ng 256 latent tokens nang hindi nawawala ang karamihan ng impormasyon sa teksto. Sa pamamagitan ng pagpapanatili ng mababang bilang ng vision token (64–400 tokens sa iba't ibang mode), iniiwasan ng DeepSeek ang quadratic cost explosion na maaaring maranasan ng isang simpleng Vision Transformer sa mga high-res na imahe. Ibig sabihin nito, nananatiling kontrolado ang activation memory kahit sa mga pahinang puno ng pixel.

Mixture-of-Experts Decoder kumpara sa Dense LLMs. Ang decoder, DeepSeek-3B-MoE, ay isang 3 bilyong-parameter Mixture-of-Experts transformer[8]. Hindi tulad ng tradisyunal na dense LLM kung saan lahat ng weights ay aktibo para sa bawat token, ang isang MoE model ay may maraming expert subnetworks at pinapagana lamang ang ilan para sa bawat input. Sa kaso ng DeepSeek, mayroong 64 expert sub-models, kung saan 6 na eksperto ang aktibo kada token sa pagdecode[15]. Ito ay nagreresulta sa humigit-kumulang 570 milyong parameters na “aktibo” kada token – epektibong ang modelo ay kumikilos na parang isang 570M-param model sa inference time, kahit na ang kabuuang kapasidad nito ay 3B[16]. Sa pamamagitan ng pag-route ng bawat token sa isang subset ng mga eksperto, ang modelo ay kayang mag-scale ng kabuuang mga parameter nang hindi proporsyonal na tumataas ang compute cost[17]. Sa tradisyunal na dense LLMs, kung gusto mo ng mas malaking kapasidad, kailangan mong dagdagan ang bilang ng mga parameter at bayaran ang buong compute cost para sa lahat ng ito sa bawat pagkakataon. Nilalampasan ito ng MoE: Ang decoder ng DeepSeek ay maaring gumamit ng mga espesyal na eksperto (halimbawa, marahil ang ilang eksperto ay dalubhasa sa math formulas, ang iba naman sa tabular data, atbp.) pero ang mga kaugnay lamang ang magsisimula para sa isang ibinigay na token. Ang resulta ay isang decoder na parehong magaan patakbuhin at mayamang sa kaalaman. Sa esensya, ang DeepSeek-3B-MoE ay nagtataglay ng lakas ng isang mas malaking modelo habang pinapanatili ang bilis ng isang mas maliit na isa[15]. Ito ay isang pangunahing pagkakaiba mula sa mga karaniwang dense OCR models at LLMs, na kulang sa kondisyunal na computation advantage na ito. Mahalaga ring tandaan na ang Google’s Switch Transformers at GLaM ay unang nagpatunay ng bisa ng MoE, ngunit dinadala ng DeepSeek ang kapangyarihang iyon sa isang open-source vision-language system.

Larawan: Ang dalawang-yugtong arkitektura ng DeepSeek-OCR ay kumikompres ng input na imahe ng dokumento sa mas kaunting mga token sa pamamagitan ng DeepEncoder, pagkatapos ay muling binubuo ang mayamang istrukturang output sa pamamagitan ng isang Mixture-of-Experts decoder. Sa halimbawang ito, hinihiling sa modelo na i-convert ang isang PDF ng problemang heometriyang Tsino sa Markdown: hindi lamang nito kinukuha ang teksto ngunit nagko-convert din ng diagram sa nakabalangkas na mga koordinado at LaTeX, na nagpapakita ng pag-unawa lampas sa simpleng OCR.[18][19]

Mga Mode ng Multi-Resolution na “Gundam”. Isang bagong aspeto ng disenyo ng DeepSeek ay ang mga nako-configure na resolution mode, na nakakatawang tinawag na Tiny, Small, Base, Large, at Gundam. Ang mga mode na ito ay nagbibigay-daan sa mga developer na pagpalitin ang detalye laban sa bilang ng token upang umangkop sa kanilang mga pangangailangan[20]. Halimbawa, ang Tiny mode ay nagpoproseso ng isang 512×512 na imahe sa 64 na token lamang (kapaki-pakinabang para sa mabilis na, mababang-detalye na mga pag-scan), samantalang ang Large ay humahawak ng 1280×1280 na may 400 na token para sa pinakamataas na detalye[21]. Ang Gundam na mga mode ay tumutuloy pa – sila ay nagta-tile ng pahina sa maramihang lokal na tanawin kasama ang isang pandaigdigang tanawin, pinagsasama, halimbawa, ang n lokal na 640×640 na hiwa (bawat isa ay 100 na token) na may pangkalahatang-ideyang buong pahina (256 o 400 na token)[22]. Ang dinamikong pagta-tile na ito ay tinitiyak na kahit napaka-komplikado o napakalaking mga pahina ay maaaring iproseso sa pamamagitan ng paghahati-hati nito, habang nagbibigay pa rin sa modelo ng pandaigdigang konteksto. Isa itong pag-uulit ng mga pamamaraan mula sa InternVL 2.0 at iba pa, na inangkop dito upang mapanatili ang mataas na katumpakan sa masisikip na dokumento[23]. Sa pamamagitan ng pagpapakita ng malinaw na token budgets at mga laki ng imahe, ang DeepSeek-OCR ay mahalagang nagbibigay sa mga inhinyero ng isang dial: i-optimize para sa bilis o katumpakan sa pamamagitan ng pag-aayos kung gaano karaming visual na detalye ang pinapanatili ng encoder[24][25]. Ang mga tradisyonal na OCR pipeline ay hindi nag-aalok ng ganitong detalye – ito ay isang matalinong hakbang sa pag-engineer upang gawing praktikal ang modelo sa ilalim ng iba't ibang mga limitasyon ng compute.

Pagsasanay at Pagsasama ng OCR: Paano Nagsasama ang Paningin at Teksto

Ang pagbuo ng isang modelo na talagang nagbabasa ng mga imahe na parang teksto ay nangangailangan ng maingat na pinagsamang proseso ng pagsasanay. Ang pagsasanay ng DeepSeek-OCR ay malaki ang pagkakaiba mula sa karaniwang pagsasanay ng LLM, dahil kailangan nitong isama ang kakayahan ng OCR mula simula hanggang katapusan.

Dalawang Yugto ng Pagsasanay. Ang mga mananaliksik ay nagpatupad ng isang dalawang-yugtong sistema ng pagsasanay[26][27]. Sa Yugto 1, sinanay nila ang DeepEncoder nang mag-isa bilang isang tagahula ng susunod na token sa mga pares ng data ng imahe-teksto. Karaniwang, natutunan ng encoder na lumikha ng isang hanay ng mga token na makikilala ng isang modelo ng wika bilang naglalarawan sa imahe. Ang yugtong ito ay gumamit ng malalaking dataset na nakatuon sa OCR (mga detalye sa ibaba), na epektibong nagtuturo sa module ng bisyon na i-encode ang mga imahe ng teksto sa parehong espasyo tulad ng mga text token. Matapos maging dalubhasa ang encoder, nagsimula ang Yugto 2: ang magkasanib na pagsasanay ng buong sistema ng encoder-decoder[27]. Sa panahon ng Yugto 2, ang modelo ay pinakain ng halo ng mga input na dokumento ng imahe (kung saan natutunan ng decoder na ilabas ang tamang teksto) at mga regular na input ng teksto (upang mapanatili ang talas ng kasanayan sa wika nito). Ang dalawang-hakbang na pamamaraang ito – una sa bisyon, pagkatapos ay multimodal na pagsasaayos – ay nagtiyak na ang mga kasanayan sa OCR ay malalim na naitanim sa encoder bago hilingin sa decoder na lumikha ng wika mula sa mga pag-encode nito.

Iba't ibang Multimodal na Datos sa Pagsasanay. Ang lawak ng datos ng pagsasanay ng DeepSeek ay isang pangunahing dahilan para sa katatagan nito. Ayon sa model card, nag-curate ang koponan ng isang halo ng tunay, synthetic, at kahit purong tekstwal na datos[28]:

- Dataset ng OCR 1.0: 30 milyong pahina ng totoong dokumento (scans, PDFs) na sumasaklaw sa 100+ wika[28]. Ang malaking multilingual corpus na ito ay nagbigay sa modelo ng exposure sa iba't ibang script at layout, mula sa mga English na invoice hanggang sa mga Arabic na pahayagan at mga Chinese na libro. Ang ganitong pagkakaiba-iba ay mahalaga – maraming OCR engine ang nahihirapan sa ilang wika lamang, ngunit ang DeepSeek ay sinanay mula sa simula na maging polyglot.

- Data ng OCR 2.0: Isang synthetic na dataset na naglalaman ng mga structured na dokumento na may charts, formulas, chemical structures, tables, at diagrams[28]. Ang mga ito ay malamang na mga computer-generated images na ipinares sa ground truth text (hal. isang rendered math equation image na may LaTeX bilang text). Sa pamamagitan ng pagsasama nito, natutunan ng modelo na hawakan ang mga nilalaman na karaniwang hindi pinapansin ng tradisyonal na OCR – tulad ng pagbabasa ng plots at pag-output ng pinagbabatayang data o equation. Halimbawa, maaring ma-interpret ng DeepSeek ang isang chemical diagram at mag-output ng SMILES formula o mag-convert ng bar chart image sa isang CSV/HTML table, mga gawain na lampas sa “pagbasa ng naka-print na teksto.” Ito ay nagbibigay sa DeepSeek ng natatanging edge sa structured document understanding.

- General vision data (20%): Standard na mga imahe mula sa mga dataset tulad ng LAION (100M samples) ay isinama[29]. Ang layunin ay tiyaking hindi magiging makitid ang modelo – pinanatili nito ang general vision-language grounding, kaya maaari nitong i-caption ang isang imahe o kilalanin ang mga bagay. Bilang resulta, maaring ilarawan ng DeepSeek-OCR ang mga imahe o hanapin ang mga visual elements kung hinihingi (katulad ng isang basic vision AI), na hindi kayang gawin ng mga purong OCR tools.

- Purong text data (10%): Maliit na bahagi ng training ay text-only data[28]. Ito ay upang mapanatili ang kakayahan ng decoder na bumuo ng fluent na wika. Dahil sa huli, pagkatapos ng “pagbasa” sa imahe, dapat mag-output ang modelo ng coherent na teksto. Ang pagsasama ng ilang text corpora ay tumutulong sa decoder na hindi mag-overfit at maging isang may kakayahang language model (halimbawa, maaari itong mag-reformat ng teksto, mag-summarize, o mag-translate kung hihilingin).

Ang pinaghalong datos na ito ay nagtitiyak na ang OCR capability ay malalim na isinama: Hindi lamang gumagawa ang DeepSeek ng image preprocessing kasama ang off-the-shelf LLM, kundi ito ay sabay na sinanay upang magsagawa ng end-to-end na pag-unawa sa visual na teksto. Binubuo nito ang teksto mula sa mga imahe na may pambihirang katumpakan – 97% exact match accuracy sa ~10× compression sa isang karaniwang benchmark[30][31]. At dahil sa iba't ibang pagsasanay, ginagawa ito hindi lamang para sa simpleng naka-type na teksto, kundi pati na rin sa mga kumplikadong layout at naka-embed na visual. Bilang resulta, ang pagsasanay ay nagtransforma sa DeepSeek-OCR bilang isang hybrid ng isang OCR system, isang layout analyzer, at isang language model nang sabay-sabay.

Kaliskala at Kompyutasyon. Ang pagsasanay ng DeepSeek ay isang seryosong pagsisikap sa kompyutasyon, na maihahambing sa pagsasanay ng modernong LLM. Gumamit ang koponan ng 20 nodes na may 8×A100 (40GB) GPUs bawat isa – kabuuang 160 A100 GPUs[29]. Salamat sa mahusay na pipeline parallelism, nakamit nila ang napakabilis na throughput na umaabot sa 90B tokens bawat araw sa text-only data at 70B tokens/araw sa multimodal data[29]. Sa buong kurso ng pagsasanay, malamang na umabot ito sa maraming trilyon ng tokens na naproseso. Ang ganitong kaliskala ay isa sa mga dahilan kung bakit mahusay ang pagganap ng modelo kahit na ito ay epektibong may ~570M aktibong mga parameter; naipakita ito sa isang napakalawak na hanay ng mga halimbawa. Ang optimisasyon sa pagsasanay (AdamW optimizer, batch size 640, LR ~3e-5[32]) ay pinino upang mahawakan ang napakalaking daloy ng data na ito. Ang huling resulta ay naka-package sa isang solong ~6.7 GB safetensors file para sa 3B MoE model – sapat na maliit upang patakbuhin sa isang solong high-end na GPU[33]. Ito ay malayo sa mga proprietary OCR models o malalaking dense LLMs, na maaaring mangailangan ng mga cluster o hindi maaaring i-host ng sarili. Ipinapakita ng mahusay na training pipeline ng DeepSeek na sa tamang arkitektura (MoE + vision compression), maaari mong makamit ang mahusay na katumpakan nang hindi nangangailangan ng napakalaking modelo.

Lisensya ng Open-Source at Pag-ampon ng mga Developer

Isa sa mga pinaka-mahalagang aspeto ng DeepSeek-OCR 3B ay ang ganap na open-source na paglabas nito. Ang parehong model weights at code ay ginawa nang magagamit sa ilalim ng isang MIT na lisensya[34], isa sa mga pinaka-maluwag na lisensya sa software. Para sa mga developer at organisasyon, ito ay may malaking kahulugan:

- Malawak na Karapatan sa Paggamit: Ang lisensyang MIT ay nangangahulugang maaari mong gamitin ang modelo komersyal o pribado na may kaunting mga paghihigpit – karaniwang “kahit ano pwede” basta't isama mo ang paunawa ng lisensya. Ito ay isang malaking pagkakaiba mula sa maraming “bukas” na mga modelo na may mga sugnay na hindi pang-komersyal o nangangailangan ng espesyal na pahintulot. Sa madaling salita, ang mga startup at mga kumpanya ay maaaring isama ang DeepSeek-OCR sa mga produkto (kahit na sa mga produktong sarado ang source) nang walang legal na hadlang. Ito ay tunay na bukas na inobasyon.

- Kalinawan at Tiwala: Ang pagkakaroon ng mga weights sa Hugging Face at code sa GitHub ay nangangahulugang walang itinatago. Maaaring suriin ng mga developer kung paano gumagana ang modelo, tiyakin ang arkitektura, at kahit na i-audit o i-finetune ito para sa kanilang mga pangangailangan. Ang kalinawang ito ay nagpapalakas ng tiwala – halimbawa, kung ikaw ay nagpoproseso ng sensitibong mga dokumento, mas pipiliin mo ang bukas na modelo na maaari mong patakbuhin nang buo sa iyong lugar kaysa sa pagpapadala ng data sa isang third-party na API.

- Dali ng Integrasyon: Kasama sa release ang detalyadong model card at halimbawa ng paggamit. Sa ilang linya ng Python (gamit ang Hugging Face Transformers na may trust_remote_code=True upang payagan ang custom na code ng modelo), maaari mong i-load ang modelo at patakbuhin ang inference[35][36]. Nagbigay pa ang koponan ng DeepSeek ng nasubok na mga detalye ng kapaligiran (Python 3.12, Torch 2.6, Transformers 4.46, FlashAttention 2.7, atbp.) upang ang mga inhinyero ay makapag-replicate ng setup nang maaasahan[37]. Ito ay nagpapababa ng hadlang sa paggamit – hindi mo kailangang maging AI researcher para subukan ito. Kung mayroon kang image file ng dokumento at disenteng GPU, maaari kang makakuha ng resulta sa loob ng ilang minuto.

- Komunidad at Suporta: Mula nang ilunsad, ang DeepSeek-OCR ay mabilis na nakakuha ng atensyon. Ang GitHub repo ay nakakuha ng libu-libong stars (5k+ stars) sa loob ng ilang araw mula sa paglabas[38], at ang modelo ay nagkaroon ng sampu-sampung libong downloads sa Hugging Face[39], na nagpapakita ng buhay na interes ng komunidad. Maraming demo applications (Spaces) ang lumitaw sa Hugging Face kung saan maaari mong subukan ang modelo sa iyong browser[40]. Ang momentum ng komunidad na ito ay nangangahulugang malamang na makahanap ng tulong, mga tutorial, o mga extension na kontribusyon ng iba ang mga developer. Ibig sabihin din nito na ang modelo ay masusubok sa iba't ibang mga kaso ng paggamit, na nagtatanggal ng mga bug at nag-iinspire ng mga pagpapahusay.

- Kalayaan na I-customize: Marahil ang pinakamahalaga, ang bukas na weights ay nangangahulugang maaaring i-fine-tune ng mga developer ang DeepSeek-OCR o baguhin ito. Kung ang iyong kumpanya ay may natatanging gawain sa OCR (halimbawa, pagbabasa ng isang partikular na uri ng engineering schematic o napaka-stylized na mga font), maaari mong karagdagang sanayin o i-angkop ang modelo sa domain na iyon. Sa mga saradong OCR API, wala kang ganitong opsyon – makukuha mo lang ang inaalok ng provider. Ang DeepSeek ay nagbibigay-kapangyarihan sa mga R&D teams na mag-innovate dito. Maaaring makakita tayo ng mga espesyal na derivative – halimbawa, maaaring may mag-fine-tune ng bersyon ng DeepSeek para sa mga historikal na handwritten na dokumento, o isama ito sa mas malaking pipeline (mga chatbot na maaaring sumagot sa mga tanong tungkol sa nilalaman ng PDF, atbp.).

Sa kabuuan, ang open-source MIT release ng DeepSeek-OCR ay nag-aalis ng parehong hadlang sa gastos at hadlang sa pag-access para sa makabagong OCR. Kahit sinong developer na may GPU ay maaaring mag-deploy ng state-of-the-art vision-language model sa kanilang sariling kapaligiran, nang walang bayad. Ang demokratisasyong ito ay maihahambing sa nakita natin nang naging available ang mga image model tulad ng Tesseract (open-source OCR) o Stable Diffusion (open-source image generation) – maliban na lang na ang kakayahan ng DeepSeek ay mas advanced. Ang mga implikasyon nito ay kahit ang maliliit na startup o mananaliksik ay maaaring magdagdag ng world-class OCR at pag-unawa sa dokumento sa kanilang mga proyekto, na nagtutulak sa larangan pasulong sa pamamagitan ng sama-samang kontribusyon.

Paghahambing ng DeepSeek-OCR sa Mga Saradong OCR API ng Google at Amazon

Paano nakikipagsabayan ang modelong ito laban sa mga kasalukuyang tulad ng Google Cloud Vision OCR at Amazon Textract? Ang mga cloud-based OCR services na ito ay naging pangunahing solusyon para sa document processing ng mga enterprise, kilala sa kanilang katumpakan at scalability. Gayunpaman, ang pagdating ng DeepSeek-OCR ay naglalantad ng ilang malinaw na pagkakaiba sa kakayahan, access, flexibility, at bilis ng inobasyon:

- Katumpakan at Kakayahan: Sa mga gawain ng purong text extraction, napakataas ng katumpakan ng mga OCR engine ng Google at Amazon, na pinino gamit ang malawak na datos. Pumapasok ang DeepSeek-OCR sa larangang iyon na may kompetitibong resulta (kahit state-of-the-art) sa mga benchmark – halimbawa, 97–98% eksaktong tugma sa text sa mga karaniwang OCR benchmark sa makatwirang antas ng compression[30]. Nalalampasan pa nito ang mga kamakailang academic OCR models (GOT-OCR 2.0, Mineru 2.0) habang gumagamit ng mas kaunting tokens[19]. Sa praktikal na termino, kayang makipagsabayan ng DeepSeek sa mga malalaking cloud API para sa pag-extract ng naka-print na teksto. Ngunit ang mga kakayahan ng DeepSeek ay lampas sa plain OCR. Dahil sa multimodal training nito, nauunawaan nito ang mga layout at kayang i-interpret ang naka-embed na content. Halimbawa, kaya nitong basahin ang isang scientific PDF at hindi lang isulat muli ang mga talata, kundi i-interpret din ang isang graph sa PDF – naglalabas ng datos ng graph o nagbubuod ng nilalaman nito. Kaya nitong i-convert ang isang imahe ng talahanayan sa aktwal na istrukturang HTML o markdown table. Kaya pa nitong ilarawan ang mga hindi tekstuwal na elemento sa isang dokumento (mga figure, mga imahe) kung hinihiling. Ang mga saradong API tulad ng Google Vision o Textract ay karaniwang espesyal para sa ilang mga gawain (text detection, form data extraction, atbp.) – maaaring mag-extract sila ng teksto at marahil matukoy ang pangunahing istruktura ng layout, ngunit hindi nila isusulat kung ano ang ibig sabihin ng isang diagram ng kemikal o i-convert ang isang tsart sa code. Gumagana ang DeepSeek na parang isang human reader: kaya nitong bumuo ng mga output sa flexible na mga format at humawak ng mixed content. Ginagawa nitong hindi lang isang OCR tool ang DeepSeek, kundi isang pangkalahatang modelong pang-unawa ng dokumento. Iyon nga lang, may mga advanced na tampok ang saradong serbisyo (hal. ang Textract ay direktang makapagbibigay sa iyo ng mga structured form fields, at ang Document AI ng Google ay makapag-uuri ng mga uri ng dokumento) – ngunit ang mga ito ay makitid na tinukoy. Nag-aalok ang DeepSeek ng mas malawak na kakayahan kung saan ang output ay kung ano man ang hilingin mo (“i-convert ito sa Markdown”, “i-extract ang lahat ng mga pangalan at email”, “ibuod ang ulat na ito”, atbp.), ginagamit ang LLM nature nito.

- Pag-access at Pagsasama: Isang pangunahing pagkakaiba ay kung paano mo ginagamit ang mga ito. Ang Google at Amazon OCR ay mga cloud service – magbibigay ka ng mga imahe (o PDF) sa kanilang API at makakakuha ka ng mga resulta pabalik. May mga pros at cons ito. Ang pro ay kaginhawahan: walang kinakailangang kaalaman sa ML, at awtomatikong nasusukat; ang pagsasama ay isang simpleng REST API call[41]. Ang con ay kailangan mong ipadala ang iyong mga potensyal na sensitibong dokumento sa isang panlabas na server, at nagbabayad ka sa bawat paggamit[42][43]. Ang pagiging open-source ng DeepSeek-OCR ay bumaliktad sa modelong ito. Ida-download mo ang model at patakbuhin ito sa iyong sariling hardware. Maaaring mangailangan ng kaunti pang trabaho ang pagsasama (pagtatakda ng isang GPU environment, pagtawag sa model sa code), ngunit walang panlabas na dependency – kritikal para sa privacy at pagsunod sa batas. Halimbawa, ang mga kompanyang pangkalusugan o legal ay madalas na nag-aalangan sa pag-upload ng mga kumpidensyal na file sa mga third-party clouds; sa DeepSeek, maaari nilang panatilihing nasa loob ng bahay ang data. Sa gastos, kung may matatag kang dami ng mga dokumento, ang pagpapatakbo ng iyong sariling model ay maaaring mas cost-effective sa pangmatagalan[44][43]. Ang mga Cloud OCR API ay karaniwang naniningil sa bawat 1,000 pahinang naproseso. Ang mga gastusing iyon ay nagdaragdag, samantalang ang isang open model ay nagbibigay-daan sa iyo na gamitin ang isang beses na pamumuhunan sa isang GPU o cloud instance at pagkatapos ay magproseso ng milyun-milyong pahina sa marginal na gastos. Sa kabuuan, walang limitasyon ang pag-access sa DeepSeek – walang rate limits, walang bayarin, at full control sa kapaligiran. Ang trade-off ay ikaw ang nag-mamanage ng imprastraktura, ngunit para sa marami, ito ay isang welcome trade para sa kalayaan.

- Kakayahang umangkop at Pag-customize: Ang mga closed-source OCR solution ay karaniwang mga nakapirming alok. Kung sila ay nagkakamali o hindi naka-tukoy sa iyong domain (halimbawa, pagbabasa ng sulat-kamay o espesyal na jargon), kaunti lang ang magagawa mo maliban sa pag-post-process o pag-asang mapabuti ng provider ang model. Sa isang bukas na model tulad ng DeepSeek, mayroon kang ganap na kakayahang umangkop. Maaari mong i-finetune ang model sa iyong domain data (hal. finetune sa mga sample ng sulat-kamay o niche language documents) upang mapabuti ang pagganap nito partikular sa iyong mga pangangailangan. Maaari mo ring i-customize ang output format sa pamamagitan ng prompting – hal. hingin sa DeepSeek na mag-output ng JSON na may ilang field na na-extract, o panatilihin ang markdown syntax para sa formatting. Ang LLM DNA ng model ay nangangahulugang kaya nitong sundin ang mga tagubilin kung paano ipapakita ang mga resulta ng OCR, isang bagay na hindi magagawa ng Google/Amazon APIs (mayroon silang predefined output schemas). Bukod dito, maaari mong isama ang DeepSeek sa mga composite workflows: marahil patakbuhin mo ang DeepSeek para makakuha ng draft extraction, pagkatapos ay ipasa iyon sa isa pang model para sa verification o sa isang human-in-the-loop system. Sa mga saradong API, madalas kang nakakulong sa kanilang pipeline. Sa esensya, ang pagiging open-weight ng DeepSeek ay nagbibigay sa mga developer ng kalayaan na mag-innovate sa ibabaw nito, samantalang ang mga saradong solusyon ay “kung ano ang nakikita mo ay iyon ang makukuha mo.” Ang flexibility na ito ay isang katalista para sa mas mabilis na inobasyon sa aplikasyon – maaaring makakita tayo ng mga bagong use case (tulad ng interactive document chatbots, o visual document editing tools) na binuo sa paligid ng DeepSeek na hindi magiging posible o cost-effective gamit ang saradong APIs.

- Bilis ng Inobasyon: Ang mga open-source model ay may tendensiyang mabilis na umunlad sa pamamagitan ng kontribusyon ng komunidad at integrasyon ng pananaliksik, samantalang ang mga saradong serbisyo ay nag-iimprove sa likod ng mga nakasarang pintuan at sa kanilang sariling timeline. Sa paglabas ng DeepSeek-OCR sa ligaw, maaaring suriin ng mga mananaliksik ang arkitektura nito at bumuo sa ibabaw nito. Kung may makadiskubre ng paraan para gawing 2× mas mabilis o mas tumpak, maari nilang ibahagi ang mga pagpapahusay na iyon nang hayagan. Halimbawa, isipin ang isang pagsusumikap ng komunidad na i-prune o i-quantize ang model para sa edge deployment – maaari itong mangyari sa loob ng ilang linggo sa open source. Ang mga saradong provider, sa kabilang banda, ay maaaring mag-update ng kanilang OCR tech tuwing ilang buwan o taon, at maaaring hindi man lang malaman ng mga user kung ano ang nagbago sa ilalim ng hood. Ang bilis ng inobasyon sa mga open models ay napatunayang mabilis sa LLM space (nakita nating ang mga open LLM ay umabot sa pagganap ng mga pangunahing labs sa loob ng ilang buwan)[45][46]. Maaari nating asahan ang isang katulad na epekto dito: ang paglabas ng DeepSeek ay mag-uudyok ng kompetitibong benchmarking laban sa Google/AWS, at kung ito ay kulang sa anumang lugar, maraming mga mata ang maghahanap ng kung paano ito mapapabuti. Gayundin, ang pagkakaroon ng isang viable open alternative ay malamang na mag-pressure sa mga closed-source OCR provider sa pagpepresyo at mga tampok. Kung ang mga kumpanya ay magsimulang lumipat sa mga open models upang makatipid ng gastos o maiwasan ang vendor lock-in, maaaring tumugon ang mga cloud OCR services sa pamamagitan ng pagpapababa ng mga presyo o pag-aalok ng mga bagong value-add feature (hal. mas seamless na pagsasama sa iba pang mga cloud tools, o mga garantiya ng data privacy). Ito ay isang malusog na kumpetisyon na sa huli ay nakikinabang sa mga end user. Kapansin-pansin na kahit ang ilang malalaking lider sa teknolohiya ay kinilala ang momentum ng open AI – halimbawa, kamakailan lamang ay sinabi ng CEO ng OpenAI na si Sam Altman, “Ako ay personal na naniniwala na tayo ay nasa maling panig ng kasaysayan dito [sa closed models] at kailangan nating maghanap ng ibang open-source na estratehiya.”[47]. Ang pahayag na ito ay dumating habang ang mga open models, tulad ng mga mula sa DeepSeek, ay nagpakita ng mabilis na pag-unlad. Sa larangan ng OCR, maaaring mag-udyok ang DeepSeek-OCR ng katulad na pag-iisip ng kung gaano karaming halaga ang ibinibigay ng mga proprietary na alok kumpara sa mga proyektong pinapatakbo ng komunidad.

Epekto sa Industriya: Mga Open-Weight na Vision-Language Model at Malalaking Tech

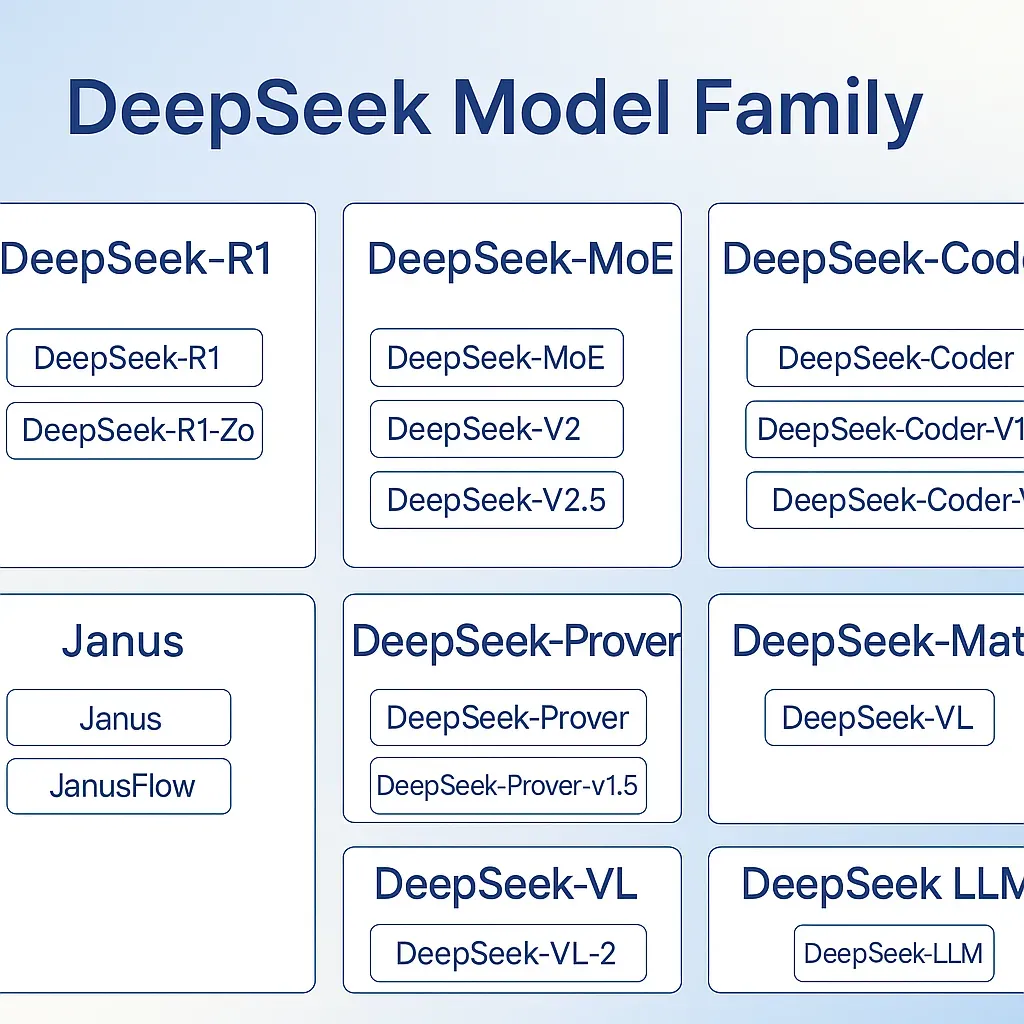

Ang paglabas ng DeepSeek-OCR ay bahagi ng mas malawak na alon sa AI: ang pag-usbong ng open-weight vision-language models (VLMs). Noong nakaraan, ang mga nangungunang multimodal models (tulad ng mga gumagawa ng OCR, image captioning, o VQA) ay halos eksklusibong pagmamay-ari o mga akademikong patunay ng konsepto. Ngayon, nakakakita tayo ng pagbabago sa paradigma. Sa nakaraang taon o dalawa, ang mga organisasyon at mga kolektibong pananaliksik – marami sa labas ng tradisyunal na Big Tech na espasyo – ay nagbu-bukas ng advanced VLMs na may kahanga-hangang kakayahan. Ang DeepSeek mismo ay nangunguna sa kilusang ito. Ang kanilang mga naunang inilabas, tulad ng serye ng DeepSeek-VL2 (3B, 16B, 27B MoE models noong huling bahagi ng 2024), ay mga pasimuno sa open vision-language systems[48][17]. Ang mga modelong iyon ay nagpakilala ng mga inobasyon tulad ng dynamic image tiling at latent attention upang mahusay na pangasiwaan ang komplikadong visual na data[49][17]. Ang bagong DeepSeek-OCR ay bumubuo sa pundasyong iyon, na nakatutok sa pag-unawa ng dokumento at long-context compression. Mahalagang tandaan, lahat ng mga modelong ito ay may isang bagay na karaniwan: pampublikong mga timbang at isang misyon na gawing demokratiko ang multimodal AI.

Ang trend na ito ay naglalagay ng kompetitibong presyon sa mga higanteng may saradong pinagmulan. Isaalang-alang na sa kasaysayan, kung kailangan mo ng modelo na kayang "makakita" at "magbasa," kailangan mong gumamit ng mga serbisyo tulad ng Google Vision o magbayad para sa mahal na proprietary software (o gumamit ng mas matatandang bukas na gamit tulad ng Tesseract, na mas hindi gaanong epektibo). Ngayon, sa mga bukas na modelo tulad ng DeepSeek-OCR (at iba pa, halimbawa Alibaba’s Qwen-VL o Meta’s open image-text models), may mga pagpipilian ang mga developer na hindi sila nakatali sa ekosistema ng isang malaking provider. Ang pagkabukas na ito ay maaaring magpabilis ng inobasyon sa paraang hindi nagawa ng mga saradong modelo. Halimbawa, ang isang akademikong lab ay maaaring kunin ang mga weights ng DeepSeek at i-fine-tune ang mga ito para sa visual na mayamang tanong at pagsagot, naglalabas ng bagong state-of-the-art na modelo nang hindi kailangan ng Google o OpenAI. Ang kolektibong progreso ay kahanga-hanga: tulad ng nabanggit sa isang pagsusuri, kahit na ang mga saradong modelo ang unang nanguna, ang mga bukas na pinagmulan na release ay mabilis na nagsasara ng agwat sa performance at humihikayat ng bagong direksyon sa pananaliksik[45][46]. Sa larangan ng vision-language, nakikita natin ang mga bukas na modelo na humaharap sa mga gawain tulad ng image-to-markup (halimbawa, pag-convert ng mga diagram sa code) o multimodal na pangangatwiran na dati ay saklaw lamang ng panloob na pananaliksik sa mga tech na kumpanya.

Ang pagkakaroon ng mga open-weight VLM ay nagpapalaganap din ng mas transparent na kultura sa pananaliksik. Sa teknikal na ulat at modelong magagamit ng DeepSeek-OCR, maaaring i-verify ng mga mananaliksik ang mga pahayag at magpatuloy sa mga ito – halimbawa, sinusubukan ang 97% compression fidelity claim sa kanilang sariling mga dokumento[50]. Binabago nito ang paradigma mula sa "ilan lang na kumpanya ang makakagawa nito" patungo sa "sinuman sa komunidad ay maaaring mag-replicate at magpalawak ng ito." Nakita natin kung paano ito naganap sa purong text LLM world: Ang LLaMA ng Meta (bahagyang bukas) ay nagpasiklab ng pagdagsa ng inobasyon noong 2023, at ang mga modelo tulad ng sariling R1 ng DeepSeek sa unang bahagi ng 2025 ay pinuri bilang isang "major reset" para sa pagiging ganap na bukas at mapagkumpitensya[51]. Ang modelong iyon ay tinukoy bilang unang malinaw na frontier-level na modelo na walang mga limitasyon sa paggamit, at talagang nagdulot ito ng pagninilay-nilay sa mga tagapagtaguyod ng mga closed model[51][47]. Ngayon, ang DeepSeek-OCR ay nagdadala ng parehong diwa sa vision-text AI.

Kahit ang mga lider sa industriya ay nakikibahagi sa mga ideyang ito. Ang kilalang AI researcher na si Andrej Karpathy ay nagkomento sa approach ng DeepSeek-OCR, binanggit na ang paggamit ng mga imahe bilang input para sa LLM ay maaaring mas epektibo at mas expressive kaysa sa text tokens sa ilang pagkakataon[52][53]. Ipinunto niya kung paano ang isang image patch ay maaaring mag-encode ng maramihang karakter (mas mataas na info density) at kung paano ang mga imahe ay likas na naglalaman ng formatting (mga font, layout) na nawawala sa text[53][54]. Sa kanyang pananaw, ang papel ng DeepSeek-OCR ay nagpapakita ng isang hinaharap kung saan ang image input ay magiging karaniwang paraan para magbigay ng mahabang konteksto sa mga modelo, na posibleng mag-redefine ng “language” models bilang mas pangkalahatang “information models”[55][56]. Ang mga ganitong pananaw mula sa mga lider ng pag-iisip ay nagpapakita kung paano ang bukas na pananaliksik na tulad nito ay maaaring magpasimula ng mga bagong direksyon. Kung ang images-as-context ay maging isang trend, maaaring utang natin ito sa mga eksperimento tulad ng DeepSeek na nagpapatunay nito. Nagbiro si Karpathy na kailangan niyang “pigilan ang sarili mula sa agarang pag-develop ng chatbot na sumusuporta lamang sa image input” matapos makita ang mga resultang ito[57] – isang pabirong pagtukoy sa kung gaano kapromising ang ideya, kahit na may mga praktikal na hamon pa rin (dahil ang mga modelo ay naglalabas pa rin ng text). Ang pangunahing punto ay, ang mga bukas na modelo ay nagpapalakas ng bukas na talakayan at paggalugad. Ang mga ideya ay hindi nananatiling lihim ng mga may-ari; mabilis silang kumakalat sa larangan.

Mula sa isang kumpetisyon na pananaw, ang trend ng open-weight model ay kinakain ang kalamangan na dating hawak ng closed-source vision-language systems. Partikular na ang mga Chinese tech labs, ay naglalabas ng maraming mga kilalang open models at datasets, humahabol (o kahit na lumalampas) sa mga pagsisikap ng Kanluran sa ilang mga lugar. Ang DeepSeek mismo ay isang startup mula sa Tsina (nasa Hangzhou) na gumagawa ng pandaigdigang alon sa pamamagitan ng open-sourcing ng mga makabagong ideya. Ang kolaborasyon ng silangan-kanluran na ito ay nagpapabilis ng pag-unlad para sa lahat. Napapansin ito ng mga malalaking kumpanya ng teknolohiya – ang ilan ay nagsimula nang tumugon sa pamamagitan ng hybridizing ng kanilang pamamaraan (halimbawa, ang Meta na nag-open-source ng ilang mga vision models tulad ng Segment Anything, o ang OpenAI na bahagyang binubuksan ang ilang mas maliit na models).

Sa mas malawak na larawan, ang paglabas ng DeepSeek-OCR 3B sa ilalim ng MIT license ay isa pang tagumpay sa rebolusyon ng open-source AI. Ipinapakita nito ang E-E-A-T (Karanasan, Ekspertis, Awtoritatibo, Mapagkakatiwalaan) mula sa pananaw ng komunidad: mga bihasang AI developer na bukas na ibinabahagi ang kanilang kaalaman at karanasan sa modelo sa komunidad, na nagpapalakas ng tiwala at kolektibong kaalaman. Para sa mga developer at negosyo, nangangahulugan ito na ang pinakabagong OCR ay hindi na pag-aari lamang ng mga higante sa teknolohiya – ito'y isang pampublikong mapagkukunan na maaaring gamitin ng sinuman sa kanilang mga aplikasyon. At para sa larangan ng AI, ito'y paalala na ang pagiging bukas ay maaaring magtulak ng mabilis na inobasyon. Ang kakayahan ng modelo na i-compress ang mga konteksto at hawakan ang mga gawain sa vision-text ay maaaring magbigay-inspirasyon sa bagong uri ng hybrid na aplikasyon at pananaliksik sa mas masinop na MoE VLM architectures. Ang mga saradong higante ngayon ay may malinaw na mensahe: ang bukas na komunidad ay mabilis na kumikilos, at upang manatiling kaugnay (at etikal, at malawak na tinatanggap), ang pagyakap sa pagiging bukas ay maaaring hindi na opsyonal. Tulad ng inilagay ng isang ulat, Malaking tulong ang ibinigay ng DeepSeek sa LLMs bilang isang bukas na pandaigdigang proyektong pang-agham, kumpara sa isang saradong "Manhattan Project" – sa puntong kahit ang dating saradong mga manlalaro ay muling iniisip ang kanilang posisyon

Konklusyon

Ang DeepSeek 3B MoE OCR ay kumakatawan sa pagsasanib ng makabagong pananaliksik: ito ay pinagsasama ang mixture-of-experts transformer sa isang matalinong idinisenyong vision encoder upang malampasan ang limitasyon sa haba ng konteksto na karaniwang problema ng tradisyonal na LLMs. Sa arkitektura, ito ay lumilihis mula sa mga dense na modelo sa pamamagitan ng pag-activate ng mga espesyal na ekspertong per token at sa pamamagitan ng pagturing sa mga imahe bilang pangunahing input para sa mga text na gawain. Praktikal na, ito ay nakakamit ang halos walang pagkawala na OCR compression sa 10× na pagbabawas, hinahawakan ang komplikasyon ng mga real-world na dokumento, at ginagawa ito sa iba't ibang wika at format. Kasinghalaga rin ang kanyang kinakatawan – isang open-source, MIT-licensed na modelo sa panahon kung kailan ang ganitong kakayahan ay inaakalang nasa pag-iingat ng malalaking tech na kumpanya. Sa pamamagitan ng pagbubukas ng DeepSeek-OCR, ang mga lumikha nito ay nagbigay sa mga developer sa buong mundo ng isang makapangyarihang kasangkapan at hinamon ang mga saradong tagapagbigay.

Para sa mga developer, malinaw ang mensahe: Mas naging abot-kamay na ang OCR at document AI. Maaari mong isama ang isang expert-level na vision-language model sa iyong stack nang hindi nagbabayad kada API call o nangangamba sa mga limitasyon ng serbisyo. Maaari mo itong i-fine-tune, i-dissect, o gamitin lamang ito agad-agad para i-parse ang mga PDF, larawan, at iba pa sa makabuluhang teksto o datos. Ang mga naunang gumagamit ay nagpakita na ng kakayahan sa pag-convert ng buong research papers sa Markdown, pagkuha ng mga table at math nang tama, at kahit sa mga gawain tulad ng visual question answering gamit ang modelong ito. Ang ganitong kakayahang umangkop ay walang kapantay sa isang OCR system.

Para sa industriya, ang DeepSeek-OCR ay naglalarawan kung paano patuloy na pinapaliit ng mga open-source na pagsisikap ang agwat sa (at minsan ay nalalampasan pa) mga closed na solusyon sa parehong kalidad at inobasyon. Ito ay nagdaragdag sa lumalaking ebidensya na ang mga open model ay maaaring magtakda ng mga bagong pamantayan – mula sa Stable Diffusion sa imaging hanggang sa mga LLaMA derivative sa NLP, at ngayon sa DeepSeek sa vision-language OCR. Malamang na makakita tayo ng isang panahon ng mabilis na eksperimento na nakabatay sa DeepSeek-OCR: asahan ang mga na-optimize na bersyon, mas malalaking follow-up na modelo (marahil ay DeepSeek-OCR 16B MoE?), at integrasyon sa mga open-source na OCR pipeline at mga UI tool. Ang mga huling makikinabang ay tayong lahat, na makikinabang sa mas mabilis na pag-unlad ng mga tampok ng AI at mas maraming pagpipilian sa mga tool na ginagamit natin.

Sa kabuuan, ang DeepSeek 3B MoE ay higit pa sa isang OCR model – ito ay isang nagbabadya ng susunod na yugto ng AI kung saan ang open-weight multimodal models ay nagtutulak ng inobasyon sa mga larangan na tradisyonal na pinangungunahan ng mga proprietary systems. Pinapantay nito ang laro para sa pananaliksik at pagbuo ng aplikasyon sa OCR at pag-unawa sa mahabang dokumento. Sa pamamagitan ng pagtanggap sa isang bukas na modelo na may ganitong kataas na kakayahan, nagpapadala ang komunidad ng isang malakas na mensahe: ang hinaharap ng pag-unlad ng AI ay maaaring maging pag-aari ng lahat, hindi lamang ng malalaking iilan. At tulad ng ipinapakita ng DeepSeek-OCR, minsan ang pinakamagandang paraan upang harapin ang bundok ng teksto ay tingnan ito – at ngayon, kahit sino ay pwede, sa tamang modelo sa kamay.

Mga Pinagmulan: Ginamit ang mga mataas na awtoridad na reperensya at dokumentasyon upang buuin ang pagsusuring ito, kabilang ang opisyal na ulat teknikal ng DeepSeek-OCR at model card[8][50], mga balita mula sa South China Morning Post at MarkTechPost[1][24], mga pananaw mula sa mga eksperto sa AI tulad ni Andrej Karpathy[53][56], at paghahambing na impormasyon sa mga serbisyo ng OCR ng Google/Amazon[41][44]. Ang mga pinagmulan na ito ay nagpapatibay sa mga detalyeng arkitektural, mga pahayag sa pagganap, at konteksto ng industriya na tinalakay sa itaas, na nagsisiguro ng isang tumpak at mapagkakatiwalaang pag-uulat sa kahalagahan ng DeepSeek-OCR.

[1] [6] [59] Inilunsad ng DeepSeek ang multimodal AI model na gumagamit ng biswal na persepsyon upang i-compress ang text input | South China Morning Post

[2] [3] [9] [10] [11] [12] [15] [18] [23] [27] [28] [32] Narito na ang DeepSeek OCR. Paano gamitin ang DeepSeek OCR nang libre? | ni Mehul Gupta | Data Science in Your Pocket | Okt, 2025 | Medium

https://medium.com/data-science-in-your-pocket/deepseek-ocr-is-here-37096b562bb0

[4] [5] DeepSeek-OCR: Multimodal AI Binabawasan ang Text Processing Tokens ng 7-20x - Balita at Estadistika - IndexBox

https://www.indexbox.io/blog/deepseek-releases-multimodal-model-for-text-compression/

[7] [38] GitHub - deepseek-ai/DeepSeek-OCR: Mga Konteksto ng Optical Compression

https://github.com/deepseek-ai/DeepSeek-OCR/tree/main

[8] [13] [14] [16] [19] [20] [21] [22] [24] [25] [26] [29] [30] [31] [33] [37] [50] Kalalabas lang ng DeepSeek ng isang 3B OCR Model: Isang 3B VLM na Disenyo para sa Mataas na Performance na OCR at Structured Document Conversion - MarkTechPost

[17] [48] [49] Binuksan ng DeepSeek-AI ang DeepSeek-VL2 Series: Tatlong Modelo ng 3B, 16B, at 27B Parameter na may Mixture-of-Experts (MoE) Arkitektura na Muling Nagpapakahulugan sa Vision-Language AI : r/machinelearningnews

[34] [35] [36] [39] [40] deepseek-ai/DeepSeek-OCR · Hugging Face

https://huggingface.co/deepseek-ai/DeepSeek-OCR

[41] [42] [43] [44] AWS kumpara sa Google Vision (Paghahambing ng Mga Tampok ng OCR) | IronOCR

[45] [46] [47] [51] [58] [60] Bukas vs. Sarado: Ang Laban para sa Hinaharap ng mga Modelong Pangwika | American Civil Liberties Union

https://www.aclu.org/news/privacy-technology/open-source-llms

[52] [53] [54] [55] [56] [57] Nagkomento si Andrej Karpathy sa papel na DeepSeek-OCR: Maaring maging bagong direksyon para sa malalaking modelo ng wika ang pag-input ng imahe